Kochetkov, Dmitry. 2025. “Who Owns the Knowledge? Copyright, GenAI, and the Future of Academic Publishing.” arXiv, noviembre 24, 2025. https://doi.org/10.48550/arXiv.2511.21755

El documento aborda el impacto profundo y multifacético de la inteligencia artificial generativa (GenAI) y los grandes modelos de lenguaje (LLMs) en la investigación científica y el sistema de publicación académica. Las capacidades de estas tecnologías, señala el autor, representan un cambio de paradigma que ofrece oportunidades revolucionarias para acelerar descubrimiento, análisis y difusión del conocimiento, pero al mismo tiempo plantea desafíos éticos, legales y regulatorios significativos que no han sido adecuadamente resueltos por los marcos jurídicos existentes en las principales jurisdicciones del mundo.

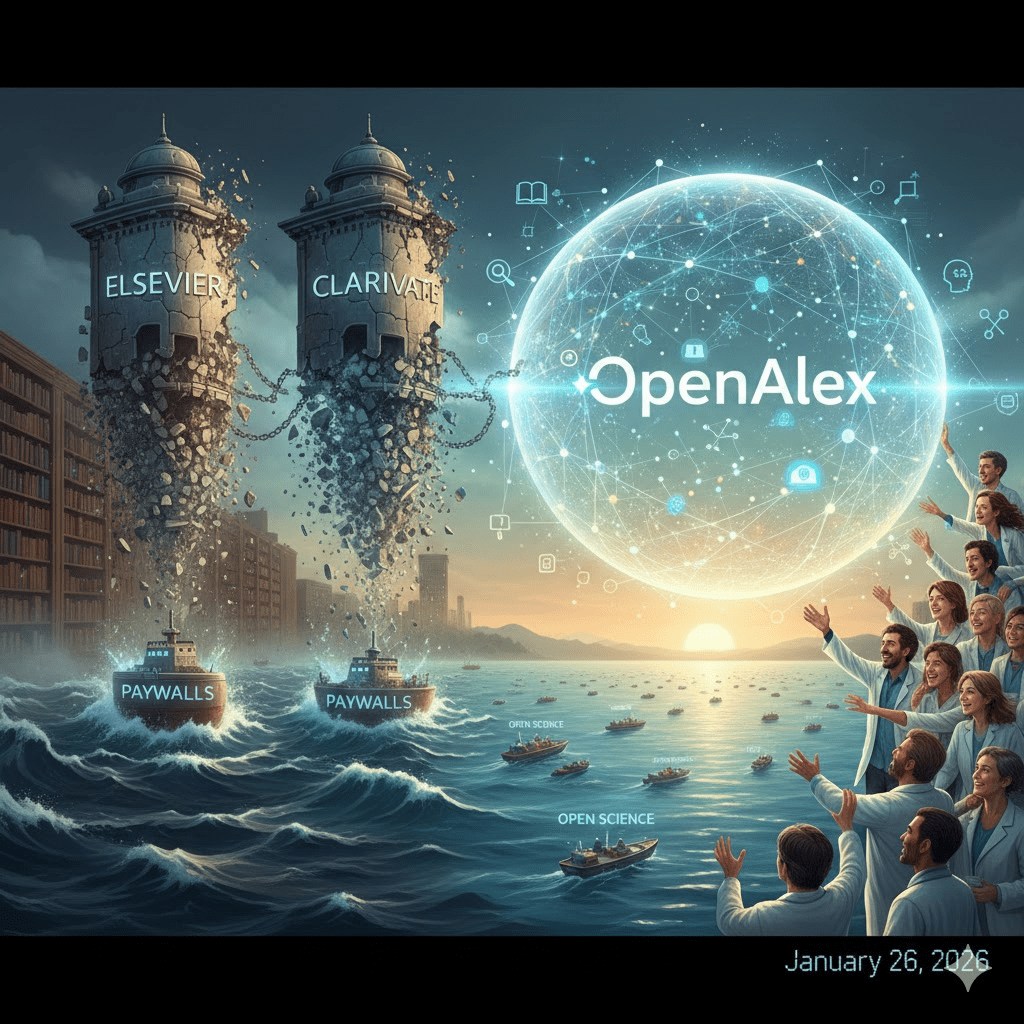

Un foco central del análisis es el reto que GenAI plantea para las leyes de copyright tradicionales y para los principios de la ciencia abierta. Kochetkov argumenta que las normativas actuales en países como Estados Unidos, China, la Unión Europea y el Reino Unido, aunque pretenden fomentar la innovación, dejan vacíos importantes específicamente en relación con el uso de obras protegidas por derechos de autor y de resultados de ciencia abierta para entrenar modelos de IA. Es decir, las normas pensadas para regular la reutilización humana de contenidos no cubren adecuadamente la ingestión masiva de textos científicos por parte de algoritmos de aprendizaje automático.

El autor también discute las limitaciones de los mecanismos de licencia existentes, incluyendo las licencias de acceso abierto como las de Creative Commons. Aunque estas licencias han sido útiles para permitir la reutilización y difusión entre personas, no están diseñadas para regular el entrenamiento de GenAI, que implica procesamiento de datos a gran escala y sin intervención humana directa. Esto se traduce, según el artículo, en una falta de atribución y reconocimiento de la autoría real de los contenidos, lo cual socava nociones académicas fundamentales de originalidad, crédito y responsabilidad intelectual.

Frente a esto, Kochetkov propone una crítica al uso automático de figuras legales como la “excepción de uso justo” (“fair use”) en Estados Unidos para justificar el entrenamiento de modelos de IA con textos académicos. En su análisis, depender de este enfoque es problemático porque no respeta suficientemente los derechos de los creadores originales —especialmente cuando los modelos son desarrollados o explotados comercialmente o cuando producen derivados opacos sin atribución clara— y podría favorecer la consolidación de mercados oligopólicos donde prevalecen intereses comerciales sobre la integridad científica y la equidad en la producción de conocimiento.

Como alternativa, el autor aboga por que los autores mantengan derechos explícitos para rechazar el uso de sus obras en procesos de entrenamiento de IA, independientemente de la doctrina de uso justo, y que las universidades jueguen un papel más activo en la gobernanza responsable de IA. Las instituciones académicas, sostiene, están en una posición única para desarrollar políticas internas que reflejen los valores de integridad científica, transparencia y justicia epistémica, negociando derechos que incluyan cláusulas específicas sobre IA.

Finalmente, Kochetkov llama a un esfuerzo legislativo internacional armonizado que pueda integrar coherentemente derechos de autor, ciencia abierta y el uso de GenAI en la investigación académica. Una regulación coordinada a nivel global ayudaría a proteger la propiedad intelectual, garantizar transparencia en los datos de entrenamiento, y evitar que la infraestructura de conocimiento científico quede dominada por intereses comerciales en detrimento del acceso equitativo y la integridad de la producción académica.

En conjunto, el artículo plantea que la revolución de la IA en la ciencia requiere no solo innovación tecnológica, sino también reformas profundas en las políticas de derechos de autor, licencias abiertas y gobernanza institucional, para asegurar que la transformación digital refuerce —y no erosione— los principios fundamentales de la investigación científica y la difusión del saber.