VER VIDEO Ponencia: ¿Cómo publicar un artículo científico y cómo hacerlo con impacto? por Julio Alonso Arévalo Universidad Dr. José Matías Delgado San Salvador (El Salvador) 23/05/2023

Publicar un manuscrito científico en una revista de alto impacto puede ser un objetivo deseado para muchos investigadores. El proceso requiere un enfoque estratégico y una comprensión sólida de los principios de investigación científica y publicación. A continuación, se detallan los pasos clave para aumentar las posibilidades de lograrlo:

- Selección de la revista adecuada: Investiga y selecciona una revista de alto impacto que sea relevante para tu campo de estudio. Considera el alcance, el prestigio y la audiencia objetivo de la revista. Lee detenidamente las guías para autores y los requisitos de publicación de la revista para asegurarte de que tu manuscrito cumpla con sus criterios.

- Elaboración de un manuscrito de calidad: Realiza una investigación sólida y rigurosa, y presenta tus hallazgos de manera clara y concisa. Sigue las pautas de la revista en cuanto a la estructura y el formato del manuscrito. Asegúrate de que tu trabajo aporte nuevos conocimientos y sea relevante para la comunidad científica.

- Escritura y revisión minuciosas: Dedica tiempo a redactar tu manuscrito de manera clara y coherente. Evita errores gramaticales y ortográficos, y utiliza un lenguaje preciso. Solicita la revisión por parte de colegas o expertos en el campo para obtener comentarios y sugerencias constructivas antes de enviarlo.

- Presentación del manuscrito: Sigue las instrucciones proporcionadas por la revista para la presentación del manuscrito. Asegúrate de incluir todos los elementos requeridos, como el resumen, las palabras clave, las secciones apropiadas (introducción, métodos, resultados, discusión, conclusiones, referencias, etc.) y cualquier material adicional solicitado.

- Revisión por pares y respuesta a los comentarios: Una vez que envíes tu manuscrito, será sometido a un proceso de revisión por pares. Los revisores evaluarán la calidad y la originalidad de tu trabajo. Si recibes comentarios o sugerencias, respóndelos de manera exhaustiva y constructiva, abordando cada uno de los puntos planteados.

- Realización de ajustes y mejoras: Si se solicitan revisiones o modificaciones, trabaja en ellas de manera cuidadosa y rigurosa. Asegúrate de abordar todos los comentarios de los revisores y de proporcionar justificaciones claras para los cambios realizados en tu manuscrito.

- Envío final y espera de la decisión: Una vez que hayas realizado todas las modificaciones solicitadas, envía la versión final del manuscrito. Luego, debes esperar la decisión final de la revista, que puede ser aceptación, rechazo o requerir revisiones adicionales.

Recuerda que el proceso de publicación puede llevar tiempo y que recibirás retroalimentación tanto positiva como negativa. No te desalientes por los rechazos, ya que forman parte del proceso. Utiliza los comentarios y las sugerencias para mejorar tu trabajo y aumentar tus posibilidades de publicar en una revista de alto impacto en el futuro.

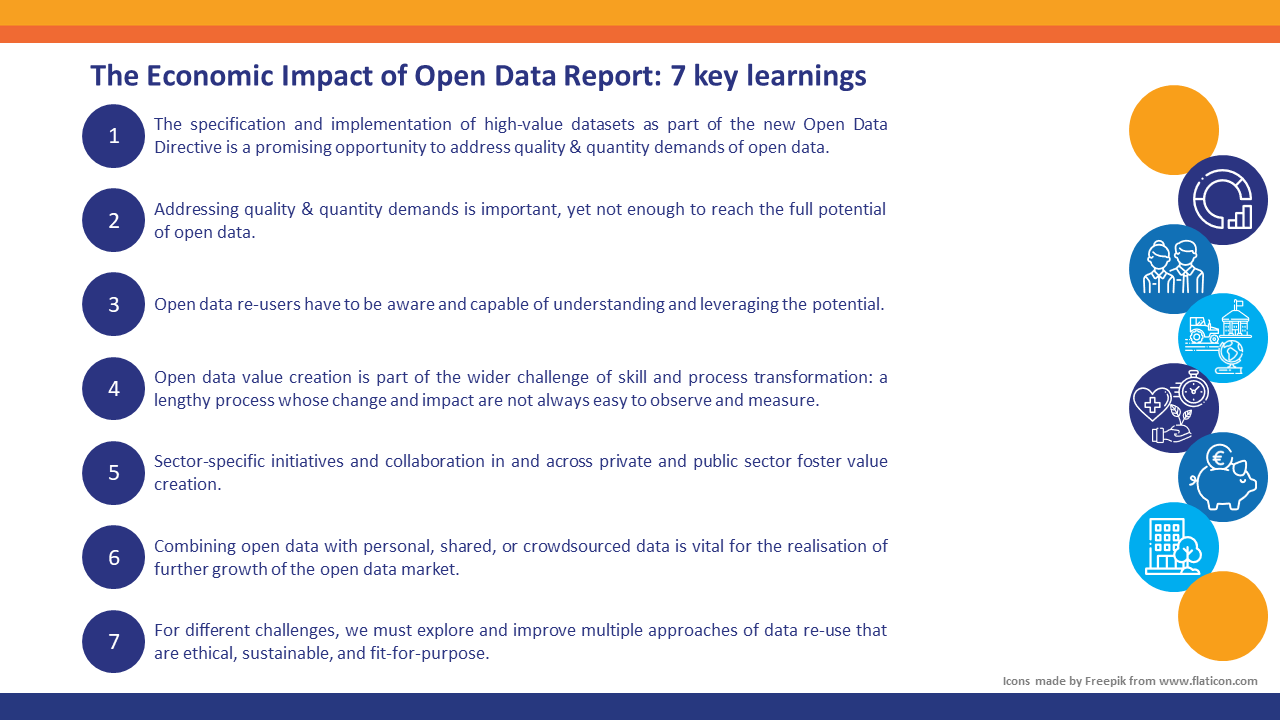

Tener un importante impacto en una publicación científica implica lograr que nuestro trabajo sea reconocido y valorado por la comunidad científica. El impacto de una publicación científica se refiere a la influencia y la relevancia que tiene en el campo de la investigación. Indica cómo el trabajo publicado ha contribuido al conocimiento existente, ha generado avances en la disciplina y ha influido en la comunidad científica.

El impacto de una publicación científica puede evaluarse de diferentes maneras:

- Citaciones: Uno de los indicadores más comunes del impacto de una publicación es el número de veces que ha sido citada por otros investigadores. Cuantas más citas reciba un artículo, mayor es su impacto, ya que indica que ha sido reconocido y utilizado por la comunidad científica.

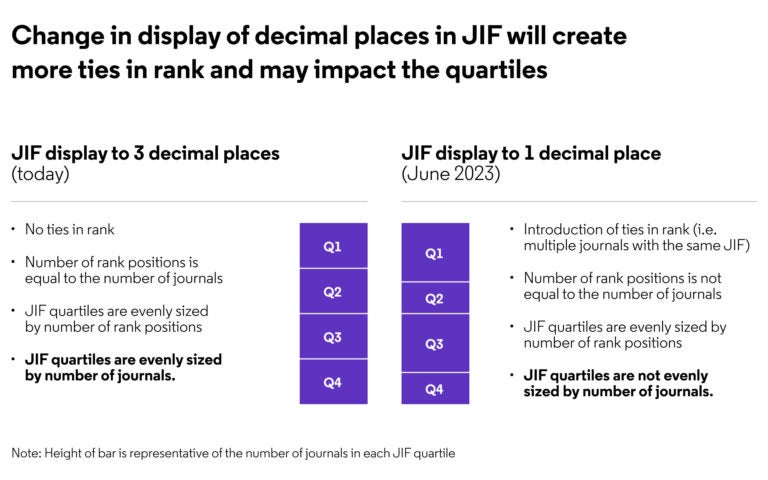

- Índice de impacto de la revista: Algunas revistas científicas tienen un índice de impacto asignado, que se calcula en función del número de citas que reciben los artículos publicados en esa revista durante un período determinado. Un índice de impacto alto indica que los artículos publicados en esa revista son ampliamente reconocidos y citados en el campo.

- Altmetrics: Las altmetrics (métricas alternativas) son indicadores que miden el impacto de un artículo más allá de las citas tradicionales. Estos incluyen el número de descargas, menciones en redes sociales, vistas en línea y discusiones en blogs o medios de comunicación. Los altmetrics proporcionan una visión más amplia del alcance y la influencia de un artículo.

- Reconocimiento y premios: El reconocimiento recibido por un artículo, como premios, becas o invitaciones a presentar en conferencias, también puede indicar su impacto. Estos reconocimientos demuestran que el trabajo ha sido considerado significativo y ha generado interés en la comunidad científica.

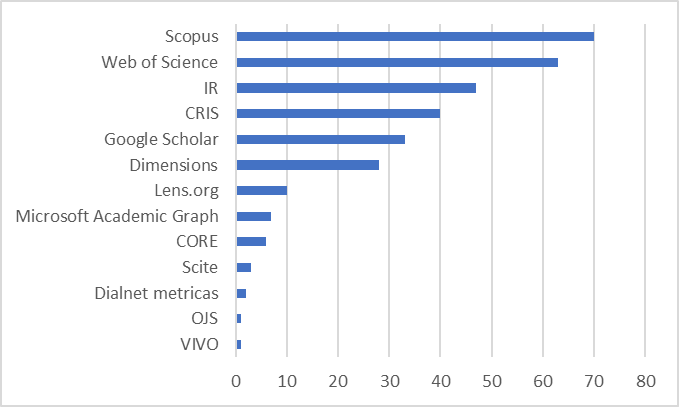

Existen varios índices de citas ampliamente utilizados para evaluar el impacto de las publicaciones científicas. Scopus, Web of Science y Google Scholar son tres de las principales bases de datos utilizadas por la comunidad académica y científica para medir el impacto de la literatura científica. Cada una de estas bases de datos tiene características distintas:

- Web of Science: desarrollada por Clarivate Analytics, es una base de datos multidisciplinaria que incluye una amplia gama de revistas científicas revisadas por pares, conferencias y otros tipos de literatura académica. Web of Science es conocida por su índice de citas, que permite rastrear y analizar las citas recibidas por los artículos publicados.

- Scopus: es una base de datos bibliográfica desarrollada por Elsevier. Contiene una amplia cobertura de literatura científica, incluyendo revistas científicas revisadas por pares, libros y actas de conferencias. Scopus ofrece funciones avanzadas de búsqueda y filtrado, así como métricas de citas y análisis de rendimiento para autores, instituciones y revistas.

- Google Scholar: Google Scholar es un motor de búsqueda académico que indexa una amplia gama de fuentes académicas, como artículos científicos, tesis, libros y preprints. Aunque no es una base de datos especializada como Scopus o Web of Science, Google Scholar ofrece una amplia cobertura y es conocido por su accesibilidad y facilidad de uso. También proporciona información sobre citas y perfiles de autores.

Los indicadores bibliométricos son medidas cuantitativas utilizadas para evaluar la producción científica y el impacto de las publicaciones académicas. Estos indicadores se basan en datos bibliográficos, como el número de citas recibidas por un artículo o el número de artículos publicados por un autor en particular. Algunos de los indicadores bibliométricos más comunes son:

- Factor de impacto (Impact Factor, IF): El factor de impacto se aplica a las revistas científicas y es una medida del número promedio de citas recibidas por los artículos publicados en esa revista durante un período determinado. Es calculado por empresas como Clarivate Analytics y se utiliza ampliamente para evaluar la calidad y la influencia de las revistas.

- Índice h (H-index): El índice h es una medida desarrollada por el físico Jorge E. Hirsch que evalúa tanto la productividad como el impacto de un investigador. Indica el número de artículos (h) que han sido citados al menos h veces. Por ejemplo, un investigador con un índice h de 20 tiene al menos 20 artículos que han sido citados al menos 20 veces cada uno.

- El CiteScore es un indicador bibliométrico que se utiliza en la base de datos Scopus para evaluar el impacto de las revistas científicas. Es calculado anualmente por Elsevier y representa el promedio de citas recibidas por los artículos publicados en una revista en los últimos tres años.

Aquí tienes algunos consejos sobre cómo aumentar el impacto de tu publicación científica:

- Selección del tema adecuado: Elije un tema de investigación relevante y de actualidad en tu campo. Identifica brechas en el conocimiento existente y enfoques novedosos para abordar esas brechas. Esto aumentará las posibilidades de que tu trabajo sea considerado importante y valioso.

- Calidad de la investigación: Realiza una investigación rigurosa y de alta calidad. Asegúrate de tener un diseño experimental sólido, una muestra adecuada, métodos precisos y análisis estadísticos adecuados. Cuanto más sólida sea tu investigación, mayor será su impacto potencial.

- Contribución original: Asegúrate de que tu trabajo aporte algo nuevo al campo científico. Esto podría ser la identificación de nuevos hallazgos, la aplicación de métodos innovadores o la resolución de un problema relevante. Demuestra la originalidad de tu trabajo y su contribución al conocimiento existente.

- Escritura clara y concisa: Comunica tus ideas de manera clara y accesible. Utiliza un lenguaje técnico apropiado pero evita la jerga excesiva. Organiza tu artículo de forma lógica y asegúrate de que sea fácil de leer y comprender. Utiliza gráficos, tablas y figuras para ilustrar tus resultados de manera efectiva.

- Contextualización y relevancia: Sitúa tu investigación en el contexto más amplio de tu campo. Explica cómo tus hallazgos se relacionan con el conocimiento existente y cómo podrían tener implicaciones prácticas o teóricas. Destaca la relevancia de tu trabajo y su impacto potencial en la comunidad científica y en la sociedad en general.

- Publica en revistas de alto impacto: Elige revistas de renombre y alto factor de impacto en tu campo. Estas revistas tienen una amplia audiencia y un riguroso proceso de revisión por pares. Publicar en revistas de alto impacto aumentará la visibilidad y credibilidad de tu trabajo.

- Promoción activa: No te quedes solo en la publicación de tu trabajo. Promuévelo activamente a través de redes sociales, conferencias y colaboraciones con otros investigadores. Comparte tus resultados y discute tus hallazgos con la comunidad científica. Cuanto más se difunda y se debata tu trabajo, mayor será su impacto potencial.

- Mantén la pasión por tu trabajo, busca retroalimentación y colabora con otros investigadores para aumentar la visibilidad y la influencia de tu investigación en el campo científico.

Es importante tener en cuenta que el impacto de una publicación científica se desarrolla con el tiempo. Puede llevar años antes de que los efectos de un estudio se perciban completamente y se reflejen en citas y reconocimientos. Sin embargo, un artículo que tiene un impacto significativo es aquel que influye en el campo, contribuye al avance del conocimiento y genera un cambio en la forma en que se comprende o aborda un tema determinado.