Nield, David. «Battle of the AI Bots: Copilot vs ChatGPT vs Gemini». Popular Science, 11 de mayo de 2024. https://www.popsci.com/technology/copilot-vs-chatgpt-vs-gemini/.

El artículo «Battle of the AI bots: Copilot vs ChatGPT vs Gemini,» publicado el 11 de mayo de 2024 por David Nield, compara el rendimiento de tres conocidos chatbots generativos: Copilot de Microsoft, ChatGPT de OpenAI y Gemini de Google.

La batalla entre los bots de inteligencia artificial, específicamente Copilot de GitHub, ChatGPT de OpenAI y Gemini de Google, refleja el avance significativo en el campo de la inteligencia artificial y su aplicación en diversas áreas. Cada uno de estos bots tiene características y especializaciones que los distinguen, y a continuación se presenta una comparación detallada de cada uno:

Microsoft Copilot:

Copilot se encuentra prácticamente en todo lo que hace Microsoft ahora: Bing, Windows, OneDrive, y también está disponible en forma de aplicación web y móvil. Ni siquiera necesitas registrarte para usarlo, aunque tu asignación de uso está limitada si no inicias sesión con tus credenciales de Microsoft.

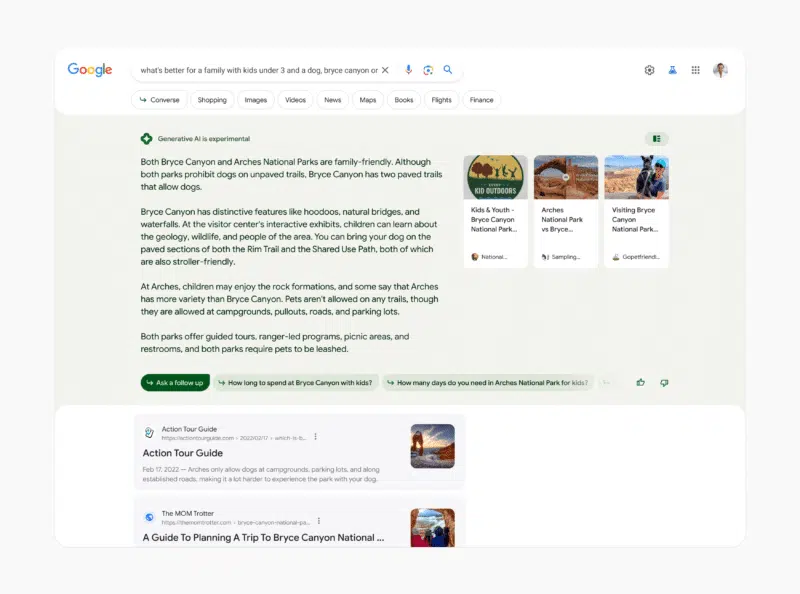

Copilot utiliza el motor de búsqueda Bing de Microsoft de manera transparente, y muchas respuestas tienen enlaces web adjuntos como citas, muy útiles si quieres asegurarte de que la IA no está alucinando. Además, tiene un tono amigable y conversacional, ofreciendo un montón de sugerencias para estímulos cada vez que lo abres.

El motor de IA que sustenta a Copilot es en realidad el GPT-4 de OpenAI (al menos hasta que Microsoft desarrolle el suyo propio), pero las herramientas son diferentes en varios aspectos, incluidos los tres ajustes de chat que puedes modificar para ajustar la salida de texto de Copilot: Más Creativo, Más Equilibrado y Más Preciso.

Copilot es la elección obvia si ya estás inmerso profundamente en el ecosistema de Microsoft. Funciona bien al referenciar información relevante de la web y proporciona enlaces de cita que son claros y fáciles de seguir.

OpenAI ChatGPT:

Parece que ChatGPT ha estado marcando el ritmo en lo que respecta a la IA generativa, pero ¿realmente es mucho mejor que la competencia cuando realmente lo usas? Ciertamente está ampliamente disponible: Puedes acceder a él desde la web en cualquier computadora, o desde las aplicaciones móviles en Android e iOS.

Hay una gran diferencia entre la versión gratuita de ChatGPT y la versión Plus de 20$ al mes; necesitas ser suscriptor para obtener características como generación de imágenes y escaneo de documentos, por ejemplo. Una suscripción también te permite construir tus propios GPT, con estímulos personalizados y tus propios datos (así que podrías, por ejemplo, alimentar a un GPT con tus propios documentos y luego hacer preguntas sobre ellos.

ChatGPT Plus también te da acceso a los modelos GPT-4 más recientes, pero el modelo GPT-3.5 gratuito es una puerta de entrada perfectamente adecuada a las conversaciones con chatbots de IA. Es rápido y versátil, aunque no te ofrece enlaces a otros lugares en la web como lo hace Copilot, para ayudarte a verificar la veracidad de lo que estás leyendo.

Una de las principales razones para elegir ChatGPT como tu chatbot preferido es que está en la vanguardia del desarrollo de IA, con nuevas mejoras y características lanzadas regularmente. Dicho esto, impresiona más cuando estás pagando por él, así que tal vez no sea el bot al que recurrir si tienes un presupuesto ajustado.

Google Gemini:

Por último, tenemos Google Gemini (anteriormente conocido como Google Bard), que está disponible como una aplicación web, una aplicación independiente para Android y en la aplicación de Google para iOS. Nuevamente, hay dos planes, gratuito y de pago, pero ese plan de pago (20$ al mes) es parte de Google One, por lo que también obtienes extras como almacenamiento en la nube incluido.

En cuanto a las diferencias reales en el uso del producto, pagar una tarifa mensual solo te da acceso a un modelo más nuevo y más inteligente (estos modelos también se llaman Gemini). En algunas situaciones, es posible que no notes la diferencia, pero en otras, como la programación o las matemáticas, probablemente lo harás.

Independientemente de la versión de Gemini que elijas, la interfaz es muy similar a la de ChatGPT, con tus conversaciones anteriores a la izquierda de la pantalla. Enlazar con conversaciones anteriores es sencillo, y nos gusta la forma en que puedes ver múltiples respuestas en borrador para el mismo estímulo (aunque los borradores a menudo son muy similares).

Al igual que con Copilot y Microsoft, Gemini tiene mucho sentido si ya usas muchos productos de Google; de hecho, es posible que ya lo hayas usado a través de Google Docs o Gmail. Sin embargo, en términos de respuestas y la interfaz, se parece más a la oferta de OpenAI, para bien o para mal: un poco más eficiente y no tan amigable como Copilot.

Conclusiones

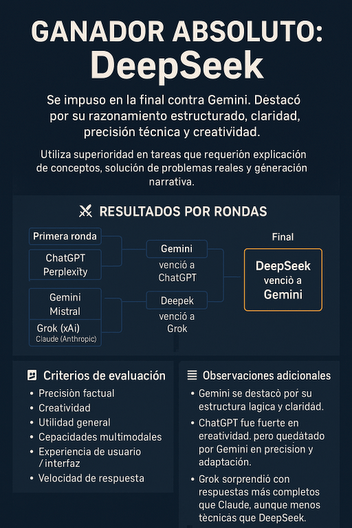

No estábamos buscando encontrar un ganador absoluto a través de esta comparación, y de hecho, todos están bastante equilibrados: como Copilot, ChatGPT y Gemini pueden usarse de forma gratuita, puedes ver por ti mismo cuál se adapta mejor a tus necesidades. En cuanto a nuestras pruebas, Copilot te ofrece la mayor funcionalidad de IA sin pagar, ChatGPT es más o menos la IA más competente (pero solo si pagas por ella), mientras que Gemini es la opción si ya eres fan de todo lo que hace Google.

En conclusión, cada herramienta tiene sus propias particularidades. Copilot es ideal para usuarios de Microsoft, ChatGPT es competente pero requiere suscripción para su máximo potencial, y Gemini es recomendable para usuarios de Google. Todos pueden probarse gratuitamente para ver cuál se adapta mejor a las necesidades de cada usuario.