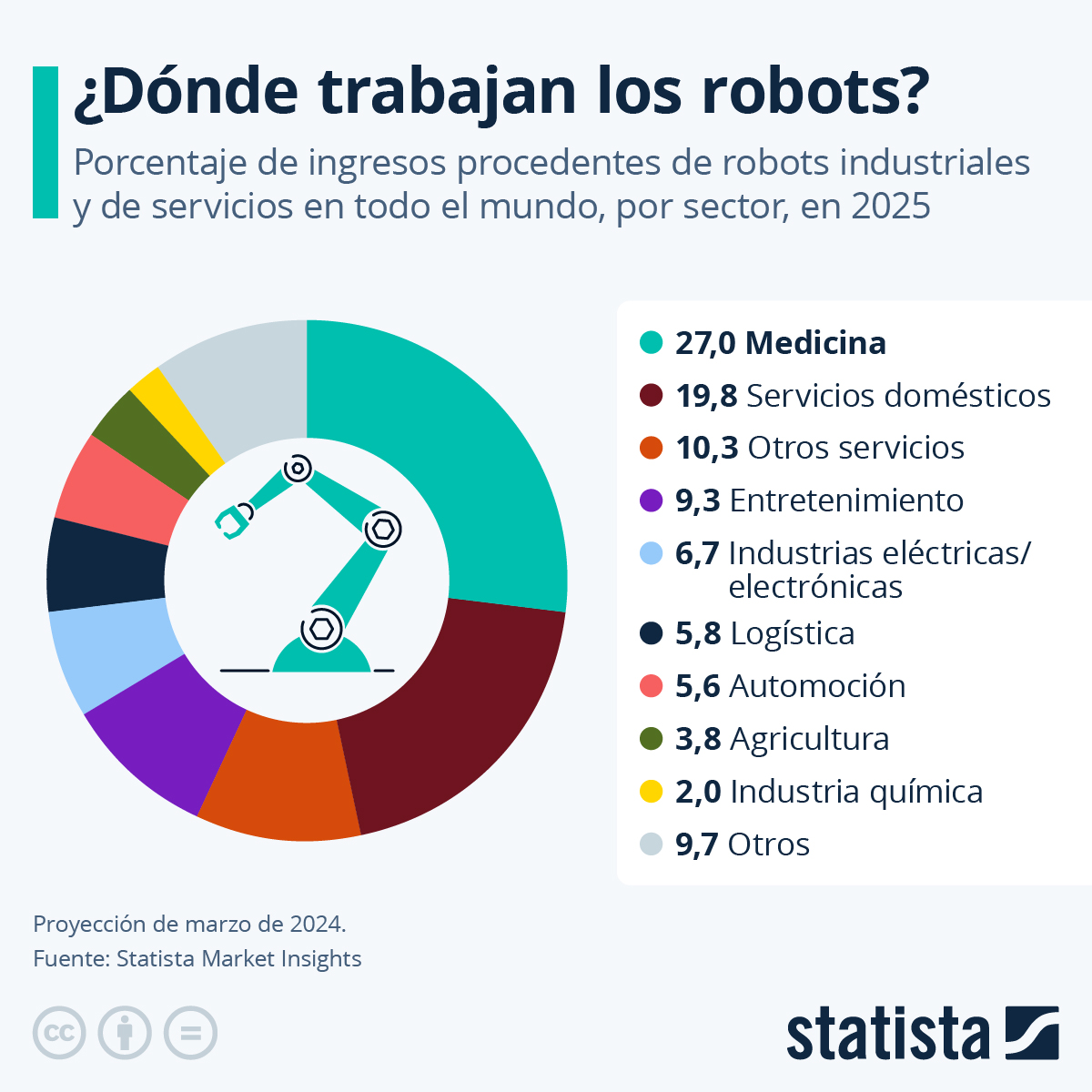

Melo, M.F. “Porcentaje de ingresos procedentes de robots industriales y de servicios en todo el mundo.” Statista.. Accedido el 27 de agosto de 2025.

Para 2025, se espera que la robótica genere ingresos significativos en distintos sectores, destacando especialmente el campo de la medicina, que representa aproximadamente el 27 % de los ingresos totales. Los robots en medicina no solo se utilizan en cirugía, sino que también tienen aplicaciones en desinfección, rehabilitación y transporte de suministros, mostrando cómo la tecnología robótica está ampliando sus funciones dentro de hospitales y centros de salud. Este crecimiento refleja tanto la inversión en innovación como la necesidad de optimizar la atención al paciente y la eficiencia operativa.

En el ámbito doméstico, los robots de servicio han experimentado un aumento considerable, con una expectativa de generar casi el 20 % de los ingresos de la robótica en 2025. Esta cifra incluye principalmente robots aspiradores, aunque también contribuyen robots cortacésped y otros dispositivos automatizados para el hogar. En el sector servicios, otras aplicaciones, como robots camareros o baristas, todavía representan un porcentaje menor, alrededor del 10 %, pero su coste por unidad es elevado, y su presencia señala la tendencia hacia una integración más avanzada de la robótica en la vida cotidiana y en la industria de la hostelería.

Otros sectores de aplicación mantienen porcentajes más modestos, generalmente de un solo dígito, pero muestran un panorama diversificado de la robótica. Esto incluye la industria del entretenimiento, las industrias eléctrica y electrónica, así como aplicaciones en la automoción, logística, agricultura y química. A medida que la tecnología avanza y los costos disminuyen, es probable que la adopción de robots en estos campos continúe aumentando, contribuyendo a un ecosistema robótico más amplio y multifacético.