Impact of Social Sciences. «Can Generative AI Add Anything to Academic Peer Review?», 26 de septiembre de 2023. https://blogs.lse.ac.uk/impactofsocialsciences/2023/09/26/can-generative-ai-add-anything-to-academic-peer-review/.

Aunque las aplicaciones de IA generativa prometen eficiencia y pueden beneficiar el proceso de revisión por pares, dadas sus deficiencias y nuestro limitado conocimiento de su funcionamiento interno, Mohammad Hosseini y Serge P.J.M. Horbach sostienen que no deberían utilizarse de forma independiente ni indiscriminada en todos los contextos. Centrándose en los últimos acontecimientos, sugieren que el proceso de revisión por pares es uno de los contextos en los que la IA generativa debería utilizarse con mucho cuidado, si es que se utiliza.

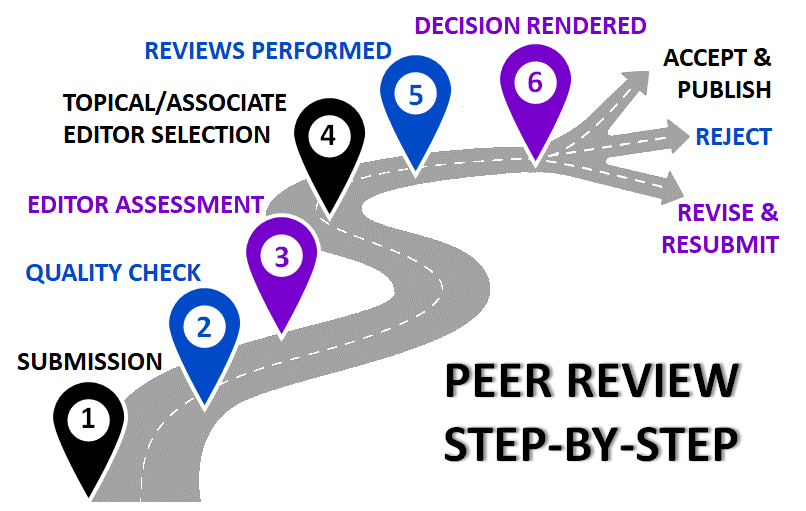

En el siempre cambiante panorama de la investigación académica y la comunicación académica, la llegada de la inteligencia artificial generativa y modelos de lenguaje grandes (LLM) como el ChatGPT de OpenAI ha despertado atención, elogios y críticas. El uso de la inteligencia artificial generativa en diversas tareas académicas se ha discutido en profundidad. Entre los posibles casos de uso, contar con el apoyo de la inteligencia artificial generativa para revisores y editores en el proceso de revisión por pares parece una opción prometedora. El sistema de revisión por pares ha enfrentado durante mucho tiempo diversos desafíos, incluyendo revisiones sesgadas o no constructivas, escasez de revisores expertos y la naturaleza que consume mucho tiempo de la empresa.

Aunque el uso de la inteligencia artificial generativa podría mitigar algunos de estos desafíos, como ocurre con muchas discusiones sobre la integración de nuevas tecnologías en flujos de trabajo existentes, también existen varias preocupaciones legítimas. Recientemente se analizó el uso de LLM en el contexto de cinco temas críticos dentro del contexto de la revisión por pares: los roles de los revisores y editores, la calidad y funciones de las revisiones por pares, problemas de reproducibilidad y las amplias implicaciones sociales y epistémicas del proceso de revisión por pares. Se concluyó que la inteligencia artificial generativa tiene el potencial de remodelar los roles tanto de los revisores por pares como de los editores, agilizando el proceso y posiblemente aliviando problemas relacionados con la falta de revisores. Sin embargo, esta posible transformación no está exenta de complejidad.

Asistir en las revisiones, pero no ser un revisor independiente

En su forma actual, las aplicaciones de IA generativa son incapaces de realizar revisiones por pares de forma independiente (es decir, sin supervisión humana), porque siguen cometiendo demasiados errores y su funcionamiento interno es desconocido y cambia rápidamente, lo que da lugar a resultados impredecibles. Sin embargo, la IA generativa puede ayudar a los actores del proceso de revisión por pares de otras maneras, por ejemplo, ayudando a los revisores a mejorar sus notas iniciales para que sean más constructivas y respetuosas. Además, la IA generativa puede permitir a los académicos que no escriban en su lengua materna contribuir al proceso de revisión en otros idiomas (por ejemplo, inglés), o ayudar a los editores a redactar cartas de decisión basadas en un conjunto de informes de revisión. Estos casos de uso podrían ayudar a ampliar el grupo de revisores y hacer que el proceso sea más eficiente y equitativo.

Confidencialidad, sesgo y robustez

A pesar de estos posibles beneficios, y además de las limitadas capacidades de la inteligencia artificial generativa para llevar a cabo revisiones independientes, existen preocupaciones importantes relacionadas con el uso de LLMs en contextos de revisión. Estas preocupaciones se refieren, por ejemplo, a la forma en que los desarrolladores de herramientas de inteligencia artificial generativa utilizan los datos proporcionados. Especialmente cuando se envían conjuntos de datos que pueden contener información personal o confidencial, la forma en que los desarrolladores de las herramientas utilizan el contenido proporcionado debería ser transparente, lo cual no es el caso en la actualidad. Además, las herramientas de inteligencia artificial generativa corren el riesgo de agravar algunos de los sesgos existentes en la revisión por pares, ya que reproducen contenido y sesgos presentes en sus datos de entrenamiento. En tercer lugar, dado que estas herramientas evolucionan rápidamente y su resultado depende en gran medida de la indicación proporcionada (incluso cambios menores podrían tener un gran impacto en el contenido generado), su resultado no siempre es reproducible. Esto plantea dudas sobre la robustez de las revisiones generadas con la ayuda de la inteligencia artificial, lo que refuerza la idea de que la inteligencia artificial generativa solo podría servir para mejorar (en cuanto a formato, tono, gramática y legibilidad) las revisiones que han sido escritas por revisores humanos.

Externalización del elemento social de la revisión por pares

Otra preocupación se relaciona con el hecho de que la revisión por pares es un proceso inherentemente social. De hecho, en lugar de ser un mecanismo de control mecánicamente objetivo, la revisión por pares se basa en las interacciones entre colegas acerca de lo que significa hacer buena ciencia. Por lo tanto, el proceso es un medio importante para debatir y negociar las normas de la comunidad acerca de qué preguntas deben abordarse, qué métodos son apropiados o aceptables, qué formas de comunicación son más adecuadas y muchas otras cuestiones. La revisión por pares también es un componente constitutivo fundamental de la integridad de la investigación y las normas éticas. En un estudio reciente, descubrimos que, en lo que respecta a las normas de integridad de la investigación, los investigadores valoran principalmente la opinión de sus pares epistémicos, es decir, aquellos que publican en las mismas revistas o asisten a las mismas conferencias, en lugar de, por ejemplo, otros colegas que trabajan en el mismo instituto. Los procesos de revisión por pares son un lugar destacado donde los expertos «se encuentran» y donde se desarrollan discusiones sobre estos temas, de manera implícita o explícita. Externalizar estos procesos a herramientas automatizadas podría empobrecer estas discusiones y tener consecuencias imprevistas más amplias.

Desarrollos recientes

En los último meses varios acontecimientos han cambiado el panorama de la inteligencia artificial generativa y han tenido un impacto en su uso con fines de revisión académica por pares. La reacción de algunos financiadores, como el National Institutes of Health (NIH) [Notice number NOT-OD-23-149] y Australian Research Council [Policy on Use of Generative Artificial Intelligence in the ARC’s grants programs]) que han prohibido el uso de la inteligencia artificial generativa en sus procesos de revisión y evaluación de subvenciones, se encuentra entre estos cambios.

Estos financiadores están principalmente preocupados por la confidencialidad y la generación de contenido falso, y con razón. La revisión de subvenciones es un juego diferente en comparación con las revisiones de artículos en revistas, ya que lo primero moldea las agendas de investigación y el acceso a recursos financieros, mientras que lo segundo informa principalmente sobre los resultados de estudios que ya se han realizado y, a veces, se han publicado como preprints.

En cuanto a la generación de contenido falso, los modelos de inteligencia artificial generativa aún cometen errores, incluso a nivel de hechos básicos. Por lo tanto, utilizarlos para revisar subvenciones y posteriormente distribuir fondos podría dañar seriamente la integridad del flujo de trabajo de los financiadores y comprometer la legitimidad de las decisiones de financiamiento. Además, las solicitudes de subvención a veces contienen información detallada sobre cada miembro del proyecto, cuya privacidad podría verse comprometida si se comparte con terceros. Esto también es una preocupación principal cuando se utiliza la inteligencia artificial generativa para revisar manuscritos o conjuntos de datos, que podrían contener información personal o sensible sobre los participantes en la investigación o tecnologías.

Las aplicaciones de la inteligencia artificial generativa todavía se encuentran en fases tempranas de desarrollo y en un futuro cercano podrían beneficiar el proceso de revisión por pares de muchas maneras. Dicho esto, dadas las limitaciones de esta tecnología, se deberían fomentar experimentos a pequeña escala y una adopción gradual. También debemos estar preparados para poner fin a su uso cuando sea necesario o en casos en los que los riesgos superen a los beneficios.

Si bien apoyamos la prohibición de las aplicaciones de inteligencia artificial generativa en algunos contextos, también tenemos preocupaciones sobre esta estrategia a largo plazo. Además de la complicada pregunta de cómo hacer cumplir dicha prohibición y supervisar el cumplimiento, siempre es necesario equilibrar las preocupaciones en relación con la inteligencia artificial generativa con sus beneficios en términos de eficiencia, que podrían liberar recursos financieros (en el caso de los financiadores, para financiar proyectos adicionales). En el futuro, recomendamos a los diferentes grupos de usuarios en la academia que revisen y modifiquen con frecuencia sus políticas sobre el uso de aplicaciones de inteligencia artificial generativa en función de las circunstancias y adopten medidas de mitigación de riesgos que se adapten a su contexto específico.