Jeannette Ekstrøm , Mikael Elbaek , Chris Erdmann e Ivo Grigorov. The research librarian of the future: data scientist and co-investigator. LSE, 4 dic. 2016

Sigue existiendo una cierta desconexión entre la forma en que los propios bibliotecarios de investigación ven su papel y sus responsabilidades y cómo las ven sus colegas de la facultad. Jeannette Ekstrøm , Mikael Elbaek , Chris Erdmann e Ivo Grigorov imaginan cómo podría trabajar el bibliotecario de investigación del futuro, utilizando la nueva ciencia de datos y habilidades digitales para impulsar una investigación más colaborativa y abierta. Podría decirse que este futuro ya está sobre nosotros, pero las instituciones deben implementar un enfoque estructurado para desarrollar las habilidades y los servicios de los bibliotecarios para aprovechar plenamente los beneficios.

Imagina a los bibliotecarios de investigación como socios iguales en el proceso de investigación, ayudando a un investigador en cualquier disciplina a mapear las brechas de conocimiento existentes, identificar los cruces disciplinarios emergentes incluso antes de que sucedan, y ayudar en la formulación y el refinamiento de preguntas de investigación.

Imagina un bibliotecario pertrechado de las herramientas digitales para automatizar las revisiones de la literatura para cualquier disciplina, reduciendo miles de ideas de artículos en memes y luego aplicando análisis de redes para visualizar tendencias en líneas de investigación emergentes.

¿Qué pasaría si su bibliotecario de investigación pudiera profundizar y usar un complemento ami-2word para mapear en qué secciones de artículos aparecen los términos clave de su investigación? Imagina que los resultados confirman que tu término de investigación favorito casi nunca aparece en las secciones de resultados, sino que se agrupan solo en torno a presentaciones y perspectivas.

¿Y si el bibliotecario no se detuviera allí, sino que se acercara a la nube de datos con estadísticas inteligentes, aplicando las últimas técnicas de extracción de texto y datos para satisfacer incluso a la mente científica más escrutadora, antes de formular una pregunta de investigación innovadora?

Imagina a un bibliotecario que comprende, en términos pragmáticos, los beneficios de la ciencia abierta para el proceso de descubrimiento. Imaginate a un bibliotecario que también ofrece consejos prácticos sobre cómo hacer que esas ideas formen parte de su flujo de trabajo diario. ¿Te gustaría que ese bibliotecario te ayudara a poner en marcha tu carrera académica?

Puede parecer demasiado bueno para ser verdad, pero en cierto modo ya está sucediendo.

En la era digital, muchas de las habilidades y competencias que desarrollan los bibliotecarios para realizar servicios «básicos» pueden servir directamente al ciclo de vida y al flujo de trabajo de la investigación. Competencias como mapear el panorama del conocimiento, gestionar volúmenes de datos heterogéneos o presentarlos en formatos comprensibles no son cosas con las que todos los investigadores están dotados, pero de las que todas las hipótesis pueden beneficiarse.

Al utilizar sus habilidades digitales y de ciencia de datos, los bibliotecarios de investigación tienen la oportunidad de hacer una contribución importante al flujo de trabajo de sus colegas de la universidad. Las habilidades de los bibliotecarios en ciencia de datos pueden ayudar a navegar a través de la avalancha de información y realmente pueden cambiar la forma en que se los percibe: desde un servicio general hasta su consideración como investigadores co-investigadores.

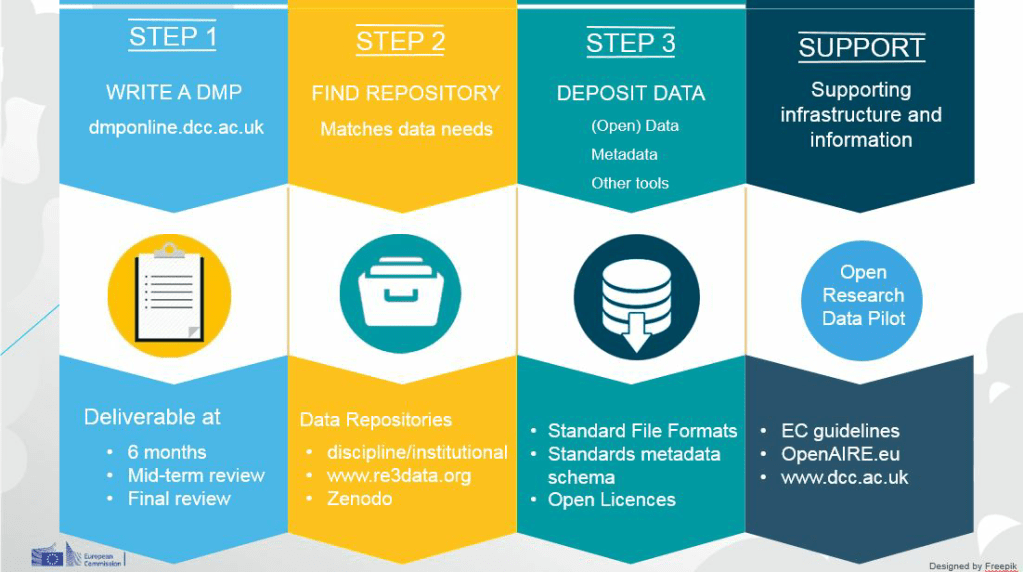

A medida que cada vez es más necesaria una investigación más abierta y transparente como una obligación de los mandatos de los financiadores, los bibliotecarios de investigación se convierten en un socio indispensable para divulgar de manera óptima los diversos resultados del proceso de investigación; desde el asesoramiento sobre la elección de las licencias adecuadas para su reutilización, hasta la mejor conservación a largo plazo y la asignación de identificadores persistentes en relación con las prácticas de derechos de propiedad intelectual existentes.

Hacer del futuro bibliotecario un socio de investigación indispensable para el profesorado no solo cerraría la brecha en cómo se percibe el rol, sino que también crearía un conducto autosuficiente para incluir las mejores prácticas en la erudición colaborativa y abierta, e implementar la ciencia abierta de forma predeterminada. Al final, todo el mundo tendría más impacto.