Deloitte Insights. (10 de diciembre de 2025). Tech Trends 2026: As technology innovation and adoption accelerate, five trends reveal how successful organizations are moving from experimentation to impact. Deloitte Development LLC.

El informe anual Tech Trends de Deloitte Insights se ha consolidado como un análisis de referencia sobre las tecnologías emergentes con mayor potencial para transformar los negocios en los próximos 18 a 24 meses.

En la edición 2026, publicada en diciembre de 2025, Deloitte describe cómo la innovación tecnológica se ha acelerado no solo en términos de mejoras aisladas, sino como un sistema en el que múltiples fuerzas se refuerzan mutuamente y amplifican su impacto. El foco ha cambiado de simplemente explorar qué puede hacer la tecnología —especialmente la inteligencia artificial (IA)— a cómo las organizaciones pueden pasar de la experimentación a generar valor de negocio real y sostenido.

El auge de la inteligencia artificial y la evolución del uso empresarial:

El documento comienza observando que la IA ha dejado de ser una novedad o una tendencia abstracta para convertirse en una fuerza estructural dentro de las operaciones empresariales. La adopción de herramientas como la IA generativa ha crecido de forma exponencial —un producto de IA líder alcanzó cientos de millones de usuarios semanales en apenas meses—, y esto implica que las empresas deben replantear no solo qué tecnologías emplean, sino cómo las integran estratégicamente en su infraestructura, procesos y modelos de negocio.

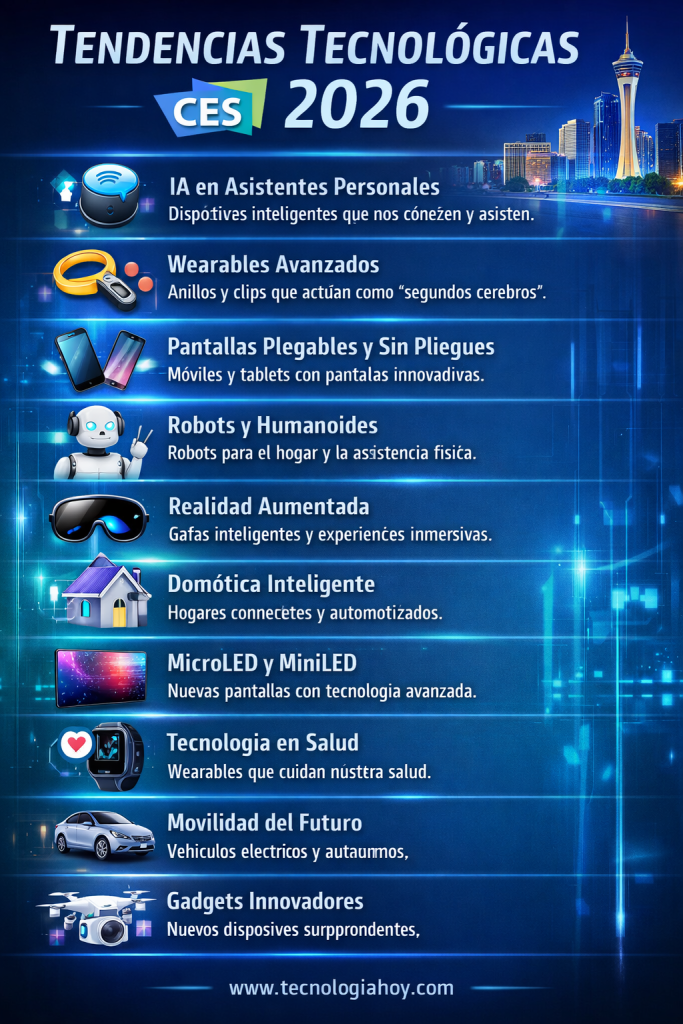

Cinco tendencias principales que están configurando el panorama tecnológico:

Deloitte identifica cinco fuerzas interconectadas que caracterizan las tendencias clave para 2026:

IA física y robótica autónoma: La inteligencia ya no se limita a las pantallas y algoritmos de software. Está integrándose con sistemas físicos —desde robots de almacén hasta vehículos autónomos en líneas de producción— transformando sectores tradicionales.

La realidad agente y el trabajo con IA: Aunque muchas empresas están probando agentes de IA (software capaz de tomar decisiones o acciones sin intervención humana directa), pocas han logrado desplegarlos a escala productiva. Este diferencial muestra que el verdadero reto es rediseñar procesos y no solo automatizarlos.

Infraestructura para la economía de la IA: Las estrategias tecnológicas existentes, como el enfoque de “cloud‑first”, están siendo reevaluadas ante la necesidad de gestionar costos de cómputo, datos y operaciones de inferencia en IA a gran escala. Las organizaciones exitosas combinan nubes públicas, infraestructura on‑premise y soluciones “edge” para equilibrar rendimiento y costes.

Reconstrucción organizacional para ser nativo en IA: Las estructuras tradicionales de IT y de gestión tecnológica no están preparadas para este nuevo ritmo de innovación. Las empresas que avanzan con éxito en la adopción de IA están reconfigurando sus equipos, sus modelos organizativos y su estrategia para integrar agentes digitales y talento humano en formas colaborativas.

Ciberseguridad y defensa adaptada a la IA: La misma tecnología que impulsa capacidades competitivas también introduce amenazas sofisticadas. Las organizaciones deben construir defensas que sean tan dinámicas y adaptativas como las herramientas de IA que usan, abordando riesgos en múltiples dominios como datos, modelos y aplicaciones.

La esencia de Tech Trends 2026 es que la innovación tecnológica ya no es un juego incremental, sino una carrera de velocidad en la que el tiempo entre el surgimiento de una tecnología y su adopción masiva se ha comprimido drásticamente. Esto exige que los líderes empresariales no solo sigan las tendencias, sino que anticipen y estructuren sus organizaciones para aprender, adaptarse y ejecutar de manera continua. Las empresas que sobresalgan en esta fase serán aquellas que integren la tecnología con una estrategia clara, midan su impacto en resultados reales de negocio y estén dispuestas a reinventar procesos y modelos existentes