Koebler, Jason. “Leaked Email Suggests Ring Plans to Expand ‘Search Party’ Surveillance Beyond Dogs.” 404 Media, February 18, 2026. https://www.404media.co/leaked-email-suggests-ring-plans-to-expand-search-party-surveillance-beyond-dogs/

Un correo interno filtrado de Amazon‑propiedad Ring ha revelado que la controvertida funcionalidad de inteligencia artificial denominada Search Party, lanzada con el propósito de ayudar a encontrar perros perdidos utilizando cámaras conectadas en vecindarios, podría evolucionar hacia un sistema de vigilancia más amplio con objetivos de seguridad comunitaria, según un informe de 404 Media.

En el mensaje, enviado por el fundador y CEO de Ring, Jamie Siminoff, a los empleados poco después del lanzamiento de la herramienta en octubre de 2025, Siminoff describió que la función fue introducida “primero para encontrar perros” pero insinuó que esta plataforma podría ampliarse para “eliminar el crimen en los vecindarios”, mostrando la intención de que la infraestructura de cámaras y el aprendizaje automático asociado sirvan a usos más allá de su propósito original.

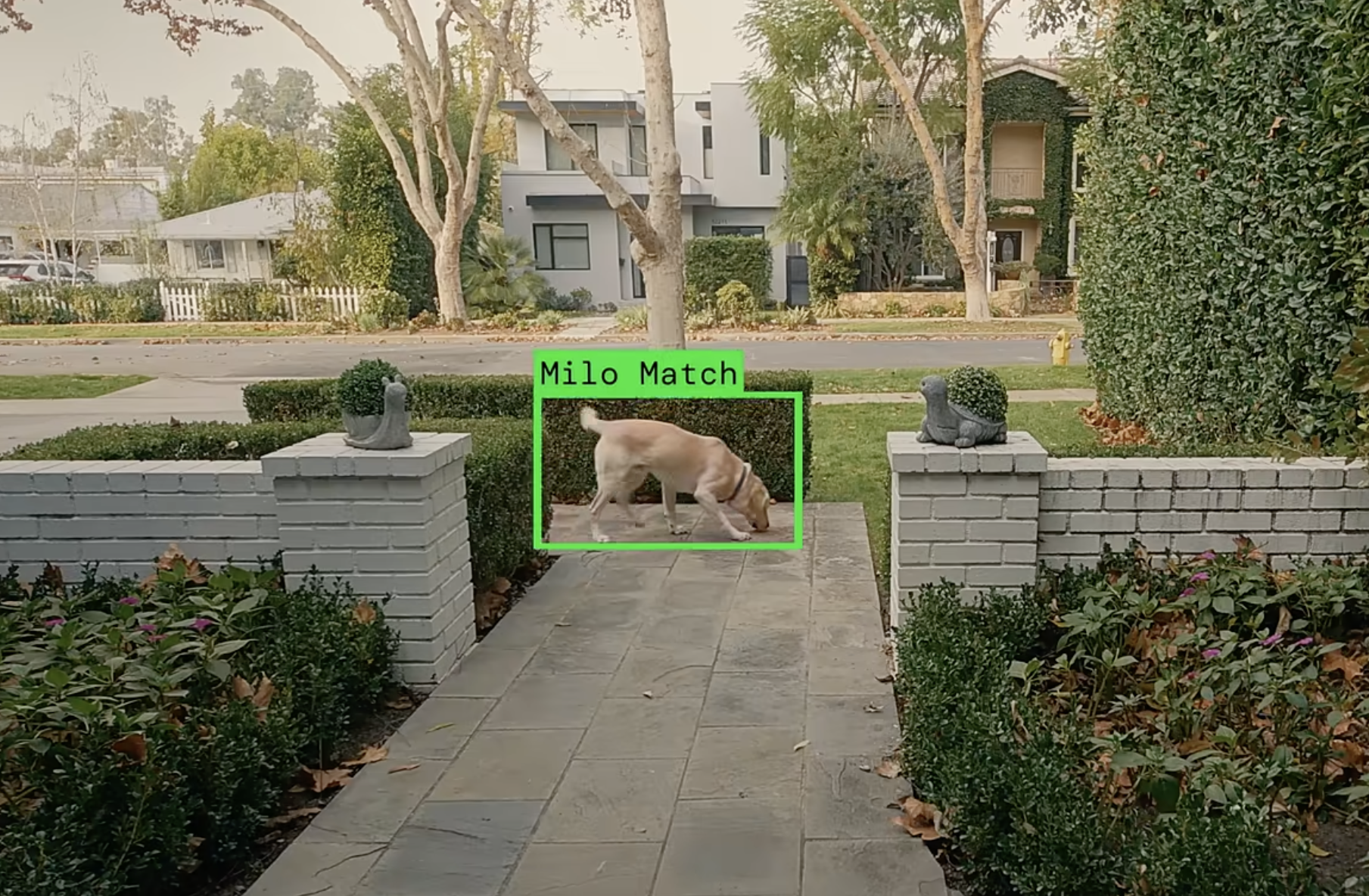

Search Party es una característica que se activa por defecto y crea una red de cámaras Ring en un área determinada que, mediante algoritmos de IA, analiza automáticamente el metraje grabado cuando se informa de un perro perdido para intentar localizarlo. Si una cámara detecta un posible avistamiento, se notifica al propietario del dispositivo, quien puede optar por compartir el video con quien busca al animal. La herramienta ha suscitado críticas por su activación por defecto y por la escala de la red de cámaras interconectadas, lo que ha despertado inquietudes sobre la normalización de una infraestructura de vigilancia en vecindarios.

La filtración ocurre en un contexto más amplio de escepticismo y rechazo público hacia las capacidades de vigilancia de Ring. La empresa enfrentó una reacción negativa importante tras la emisión de un anuncio en el Super Bowl que promocionaba Search Party, ya que muchos críticos interpretaron la publicidad como un preludio de un sistema de vigilancia encubierto que utiliza aparatos cotidianos como cámaras de puerta para monitorear barrios. Aunque Ring ha afirmado que Search Party no procesa biométricos humanos ni rastrea personas directamente, expertos en privacidad señalan que la tecnología subyacente y la expansión de funciones como Familiar Faces (identificación facial) y Fire Watch (detección de incendios) incrementan la capacidad de monitoreo automático y, por ende, los riesgos asociados a la protección de datos y libertades civiles.

Los defensores de la privacidad han advertido que una red tan extensa de dispositivos conectados por IA podría teoréticamente adaptarse para otros fines, incluidos la búsqueda de objetos o incluso personas, si futuros desarrollos así lo permiten. La reacción pública también llevó a Ring a cancelar una asociación planificada con la empresa de vigilancia Flock Safety, tras recibir críticas por el potencial uso de la herramienta para integrar a las fuerzas del orden en la recolección de evidencia a través de solicitudes de video. Ring declaró que la integración con Flock nunca se lanzó y que no se compartió ningún dato de usuario con esa empresa, enfatizando que la herramienta está diseñada para beneficiar a las comunidades y que la decisión de compartir videos recae en cada propietario.