Rachel Borchardt and Matthew R. Hartings. The academic papers researchers regard as significant are not those that are highly cited. LSE impact blog, 2018

Durante muchos años, la ciencia ha confiado en el conteo de citas como la principal forma de medir el impacto o la importancia de la investigación, informando de métricas como el Factor de Impacto y el h-index. Pero, ¿hasta qué punto estas métricas se alinean realmente con la evaluación subjetiva del impacto y la importancia de los investigadores? Rachel Borchardt y Matthew R. Hartings informan sobre un estudio que compara las percepciones de los investigadores sobre el significado, la importancia y lo que es altamente citado con los datos de citas reales. Los resultados revelan una discrepancia sorprendentemente grande entre las percepciones del impacto y la métrica que utilizamos actualmente para medirlo. Los trabajos científicos que los investigadores consideran significativos no son aquellos que son muy citados

Lo que comenzó como un intento de cuantificar la calidad de la investigación se nos ha escapado y ha cobrado vida propia. Este problema no es particularmente nuevo; ha sido ampliamente reconocido por académicos e investigadores y, como resultado, se está hablando de él más abiertamente. El problema es más sencillo se reduce a definir y medir el impacto.

Una descripción simple para la investigación de impacto es la investigación que se utiliza. Algunas investigaciones tienen la capacidad de transformar la sociedad a través de descubrimientos innovadores, de impactar en la política social y la regulación gubernamental a través de análisis que abren los ojos, y la capacidad de captar la atención del público con investigaciones que son relevantes para sus vidas, su medio ambiente o su bienestar. Este tipo de investigación se suele denominar «de alto impacto» y se ha convertido en el centro de atención de muchas universidades, centros de investigación y administradores que compiten por la financiación de becas, la atracción de los mejores y más brillantes estudiantes, y el prestigio y los rankings.

«Lo que comenzó como un intento de cuantificar la calidad de la investigación se nos ha escapado de las manos y ha cobrado vida propia.»

Rachel Borchardt and Matthew R. Hartings

Sin embargo, designar la investigación como de alto impacto no es tan sencillo como parece. Durante muchos años, el mundo académico ha confiado en el conteo de citas como la principal forma en que medimos el impacto o la importancia de la investigación. Como resultado, el conteo de citaciones es una de las métricas primarias usadas cuando se evalúa a los investigadores. Los recuentos de citas también forman la base de otras métricas, entre las que destacan el Factor de Impacto de Clarivate y el Índice h, que evalúan respectivamente la calidad/prestigio de la revista y la notoriedad de los investigadores.

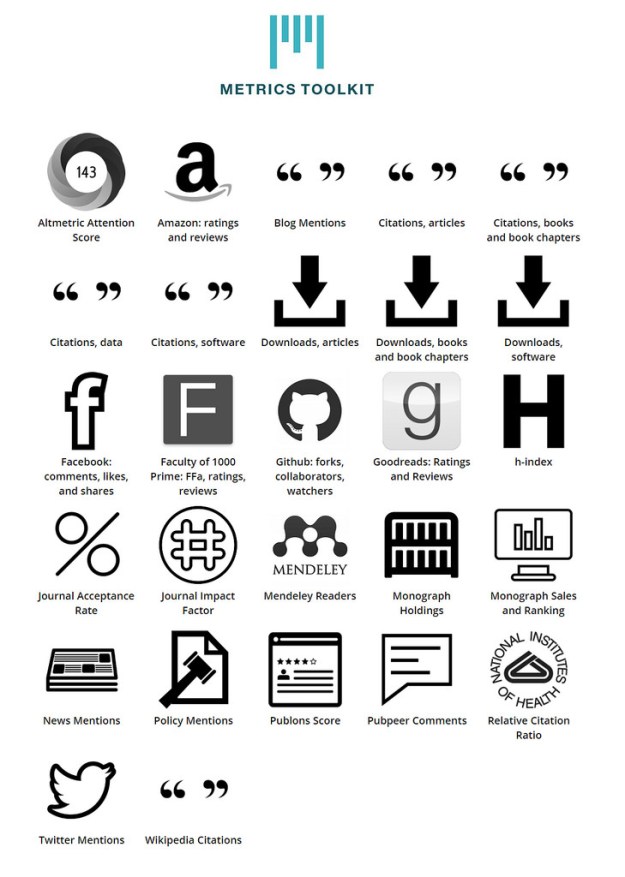

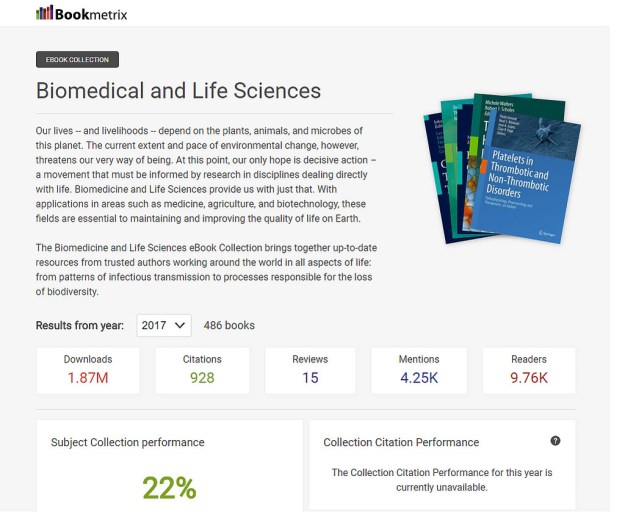

Las citas, el JIF y el h-index han servido como el triunvirato de la evaluación de impacto durante muchos años, particularmente en los campos científico y tecnológico, donde los artículos de revistas se publican con frecuencia. Muchos estudios han señalado varios defectos con la confianza en estas métricas, y con el tiempo, se ha creado una multitud de métricas complementarias basadas en citas para tratar de abordar varias competencias. Al mismo tiempo, está emergiendo las medidas del impacto en los medios sociales (altmetrics) como una alternativa o complemento potencial a las citas, donde podemos recolectar diferentes datos sobre las formas en que la investigación es vista, guardada y compartida en línea.

Sin embargo, lo que se discute con menos frecuencia es qué tan bien todas estas métricas se alinean realmente con la evaluación subjetiva del impacto y la importancia misma. Todos hemos llegado a ver las métricas como sinónimo de impacto y, por delegación, de importancia. ¿Pero lo son?

Todos hemos llegado a ver las métricas como sinónimo de impacto y, por derivación, de la importancia de una investigación. ¿Pero realmente lo son?

Para responder a esta pregunta se encuestó a investigadores de Química para medir que percepciones tenían de aquellos documentos que consideraban importantes y sobre los materiales muy citados. En un artículo en el blog orientado a la química de Matt, se pidió a los lectores que analizaran 63 artículos de una edición de la revista Journal of the American Chemical Society y utilizaran el hastag el #JACSChallenge. Se les pidió que identificaran los tres artículos que consideraban más significativos (permitiéndoles definir el significado de la manera que consideraban adecuada); los más citados; los artículos que compartirían con otros químicos; y los artículos que compartirían más ampliamente. Se analizaron los datos de más de 350 encuestados.

Los resultados, si bien no fueron realmente sorprendentes, fueron sin embargo un claro ejemplo de lo diferentes que son estos conceptos. Para empezar, los encuestados eligieron diferentes artículos para cada una de las cuatro preguntas, aunque algunas preguntas se correlacionaron más que otras. Los artículos significativos y muy citados tenían la correlación más alta en.9, mientras que los artículos para compartir con los químicos y los artículos para compartir ampliamente tenían la correlación más baja.64 Esto demuestra que los encuestados ven diferencias en estos diferentes enfoques de lo que podríamos llamar «investigación de impacto».

Pero quizás el descubrimiento más sorprendente fue cuando empezamos a comparar estas respuestas a las citas. Al comparar las cuatro preguntas con los recuentos de citas 10 y 13 años después de la publicación de los artículos, las correlaciones oscilaron entre 0,06 (artículos para compartir con los químicos) y 0,33 (artículos muy citados). Esto muestra una discrepancia sorprendentemente grande entre las percepciones de los investigadores sobre el impacto y la métrica que utilizamos actualmente para medir el impacto.

La investigación demostró que existe una una discrepancia sorprendentemente grande entre las percepciones que los investigadores tienen sobre el impacto y la métrica que utilizamos actualmente para medir el impacto.

¿Por qué estas correlaciones son tan bajas? Es probable que haya una serie de razones por las que la práctica real de citación no está más alineada con la percepción de los investigadores, pero resalta cuán diferente es la percepción de la práctica actual.

Estos datos dejan en evidencia que hay un problema importante con las métricas – no están midiendo lo que todos comúnmente asumimos que estamos midiendo, o al menos, no están representando con precisión las percepciones más abstractas de impacto e importancia de los documentos. lo que demuestra que el impacto va más allá del conteo de citas, y más allá del impacto académico. Pero, ¿qué podemos hacer para cambiar la práctica actual?

Parte de la responsabilidad recae en los evaluadores – los administradores, los «benchmarkers» de los rankings de prestigio de las universidades, los financiadores de la investigación. Pero la responsabilidad también recae en los investigadores y sus respectivas sociedades profesionales. Muchas sociedades profesionales tienen declaraciones amplias y generales sobre el papel de las métricas en la evaluación de los investigadores en su campo, pero hay más trabajo por hacer.

Estos datos dejan en evidencia que hay un problema importante con las métricas – no están midiendo lo que todos comúnmente asumimos que estamos midiendo, o al menos, no están representando con precisión las percepciones más abstractas de impacto e importancia de los documentos. lo que demuestra que el impacto va más allá del conteo de citas, y más allá del impacto académico.

Por una parte describir mejor los tipos de impacto en la academia y más allá, y presentarlos en un documento en el que los investigadores puedan confiar cuando se les pida que presenten sus evidencias de investigación para su revisión. Por otra parte sería necesario crear un marco de evaluación que comunique claramente los tipos de resultados de investigación y los modelos para su evaluación. Este tipo de marco se asemejaría al utilizado en el Modelo Becker, creado para la comunidad biomédica, que destaca cinco áreas diferentes de impacto, incluyendo el impacto económico y político, y describe claramente los resultados de la investigación y los modelos de evaluación para cada área de impacto.

Todas las disciplinas académicas estarían bien servidas para examinar con seriedad los resultados de la investigación de su disciplina y proporcionar una orientación significativa sobre su importancia en la comunicación científica de esa disciplina, junto con las mejores prácticas para su evaluación apropiada. Al mismo tiempo, los investigadores también pueden abogar por un cambio en las prácticas de evaluación de la investigación en sus instituciones en forma de documentos de políticas actualizados, incluidas las directrices departamentales para la promoción del investigador, que reflejen con mayor precisión su investigación disciplinaria y su impacto.

Sólo entonces empezaremos a cerrar la brecha entre la práctica «real» de impacto y la evaluación significativa de la investigación.

Esta entrada de blog se basa en el artículo co-escrito por los autores, «Perception of the importance of chemistry research papers and comparison to citation rates«, publicado en PLoS ONE (DOI: 10.1371/journal.pone.0194903).

Crédito de la imagen destacada: Dmitri Popov, via Unsplash (licenciado bajo una licencia CC0 1.0).