Addy Osmani. Critical Thinking during the age of AI. Publicado el 21 de noviembre de 2025 en Substack (Addyo).

El artículo destaca que, en una época en la que la inteligencia artificial puede generar código, ideas de diseño y respuestas plausibles de inmediato, el pensamiento crítico humano es más esencial que nunca.

Osmani señala que, aunque la IA puede acelerar muchas tareas, no puede sustituir la capacidad humana de cuestionar suposiciones, verificar resultados y pensar de forma independiente.

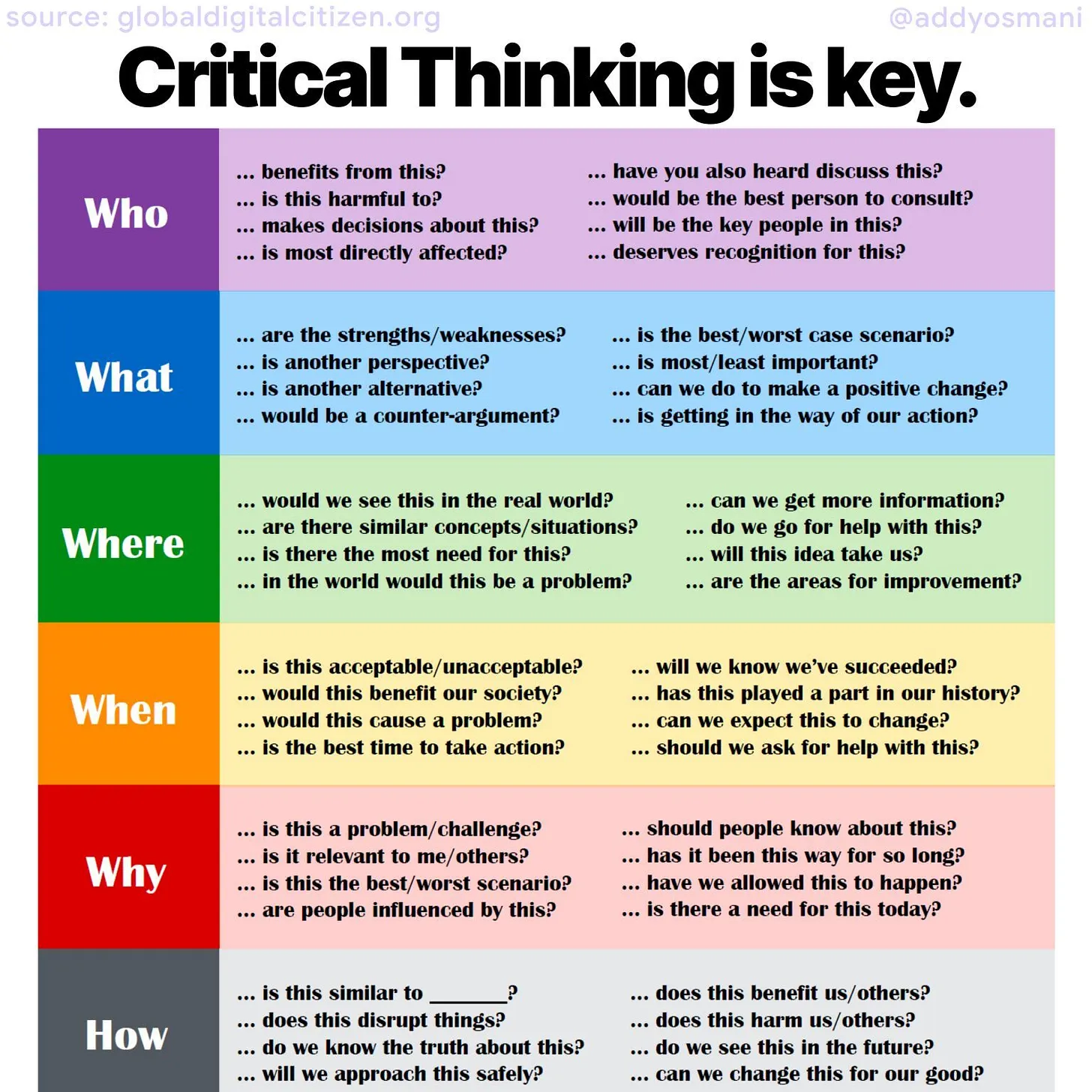

Utilizando un enfoque estructurado basado en las clásicas preguntas quién, qué, dónde, cuándo, por qué y cómo, el autor guía al lector sobre cómo aplicar el pensamiento crítico en equipos técnicos y de ingeniería que trabajan con herramientas potenciadas por IA. Por ejemplo, enfatiza que no se debe confiar en la IA como una autoridad incuestionable, sino tratar sus respuestas como sugerencias que deben ser verificadas y evaluadas por personas.

El artículo continúa explicando que el pensamiento crítico implica definir claramente el problema real antes de buscar soluciones, considerar el contexto completo (no solo un entorno aislado de prueba), y distinguir entre una solución rápida superficial y un análisis profundo de causa raíz. Además, subraya la importancia de involucrar a las personas adecuadas en el proceso de toma de decisiones para evitar el pensamiento de grupo y ampliar la diversidad de perspectivas.

También se hace hincapié en que el pensamiento crítico requiere basarse en evidencia y datos, no en opiniones o intuiciones. Esto significa recopilar hechos, validar hipótesis y comunicarse de forma clara y lógica. Según Osmani, estas prácticas ayudan a evitar errores comunes —como aceptar respuestas plausibles sin prueba— y permiten que los equipos mantengan un juicio sólido incluso cuando trabajan con tecnologías avanzadas.

La imagen es una guía visual que propone preguntas esenciales para aplicar el pensamiento crítico estructurado alrededor de las clásicas interrogantes en inglés: Who (Quién), What (Qué), Where (Dónde), When (Cuándo), Why (Por qué) y How (Cómo).

Cada sección de la imagen está codificada por colores y contiene un conjunto de preguntas orientadas a profundizar en el análisis de cualquier tema, problema o decisión, facilitando una exploración completa desde diferentes ángulos.

Comentario sobre cada sección:

- Who (Quién):

Aquí se busca identificar a los actores involucrados. Preguntas como “¿Quién se beneficia?” o “¿Quién está más afectado?” nos ayudan a entender los intereses, responsabilidades y las relaciones de poder que rodean el asunto. También destaca la importancia de reconocer a las personas clave y a quienes deben ser consultadas o reconocidas. - What (Qué):

Esta sección invita a examinar las características del tema, sus fortalezas y debilidades, alternativas y posibles argumentos en contra. Preguntas como “¿Cuál es la mejor o peor opción?” y “¿Qué está bloqueando nuestra acción?” apuntan a evaluar las opciones y obstáculos para tomar decisiones informadas. - Where (Dónde):

Se enfoca en el contexto y la relevancia geográfica o situacional. Por ejemplo, “¿Dónde sería un problema?” o “¿Podemos obtener más información?” son preguntas que resaltan la importancia de situar el análisis en el mundo real y buscar datos adicionales para un juicio más sólido. - When (Cuándo):

Aquí el énfasis está en el tiempo: identificar momentos adecuados para actuar, entender la historia detrás del problema y anticipar cambios futuros. Preguntas como “¿Es este el mejor momento para actuar?” o “¿Sabremos cuándo hemos tenido éxito?” fomentan la planificación y evaluación temporal. - Why (Por qué):

Busca entender las razones fundamentales del problema o situación, su relevancia y su duración. Cuestiona si el problema es realmente importante y si ha sido aceptado o permitido por la sociedad. Esto ayuda a clarificar motivaciones y a desafiar el status quo. - How (Cómo):

Finalmente, esta parte explora los métodos, impactos y posibilidades de cambio. Preguntas como “¿Conocemos la verdad?” o “¿Podemos cambiar esto para nuestro beneficio?” incitan a reflexionar sobre la implementación práctica y las consecuencias de las acciones.

Esta imagen es una herramienta excelente para fomentar el pensamiento crítico de forma estructurada, ya sea en la educación, en el trabajo o en la vida cotidiana. Al usar estas preguntas, podemos evitar conclusiones apresuradas o sesgadas y promover un análisis más profundo y equilibrado.

Su formato visual con colores ayuda a organizar ideas y facilita recordar qué aspectos considerar para evaluar problemas complejos. También subraya que el pensamiento crítico no es solo cuestionar, sino hacerlo de manera amplia, rigurosa y desde múltiples perspectivas.

El autor defiende que la combinación de curiosidad consciente, cuestionamiento riguroso y razonamiento fundamentado sigue siendo indispensable en la era de la inteligencia artificial, especialmente para tomar decisiones robustas y evitar soluciones incompletas o erróneas.