Está ampliamente aceptado que los artículos académicos rara vez se citan o incluso se leen. ¿Pero qué tipo de datos hay detrás de estas afirmaciones?

El genetista y premio Nobel Oliver Smithies, fallecido el pasado mes de enero a los 91 años, era un inventor modesto y autocomplaciente. Era típico de él contar uno de sus mayores fracasos: un artículo sobre la medición de la presión osmótica publicado en 1953, que, como él decía, tenía «la dudosa distinción de no haber sido citado nunca«. «Nadie lo citó nunca, y nadie utilizó nunca el método», dijo a los estudiantes en una reunión de 2014 en Lindau (Alemania).

La idea de que la literatura está plagada de investigaciones no citadas se remonta a un par de artículos publicados en Science: uno de 1990 y otro de 1991. El de 1990 señalaba que el 55% de los artículos publicados entre 1981 y 1985 no habían sido citados en los 5 años siguientes a su publicación.

Dahlia Remler echa un vistazo a la investigación académica sobre las prácticas de citación y descubre que, aunque está claro que los índices de citación son bajos, sigue habiendo mucha confusión sobre las cifras precisas y los métodos para determinar un análisis de citación preciso.

Un artículo de Lokman Meho en 2007 afirmaba que «El 90% de los trabajos publicados en revistas académicas nunca se citan». Esta estadística condenatoria, extraída de un resumen de 2007 sobre el análisis de citas, recorrió recientemente el ciberespacio. Una estadística similar había circulado en 2010, pero en aquella ocasión se decía que el 60% de los artículos de ciencias sociales y naturales no se citaban. Aunque ninguna de las dos estadísticas venía acompañada de un enlace a documentos de investigación académica que las respaldaran.

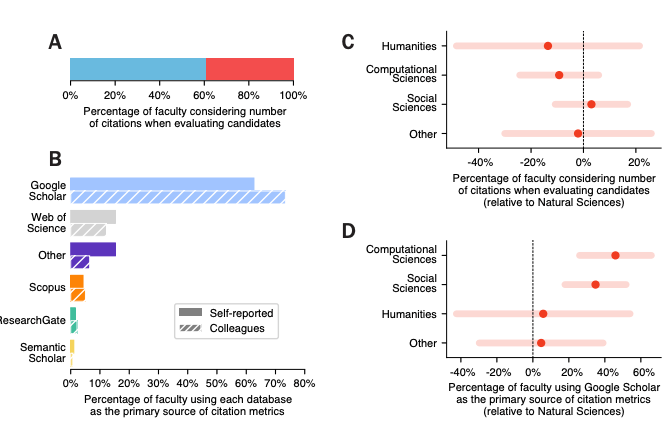

Según Sierra Williams, muchos artículos académicos no se citan nunca, aunque no pude encontrar ningún estudio con un resultado tan alto como el 90%. Las tasas de no citación varían enormemente según el campo. «Sólo» el 12% de los artículos de medicina no se citan, frente al 82% de las humanidades. Es del 27% para las ciencias naturales y del 32% para las ciencias sociales (cita). Para todo, excepto las humanidades, estas cifras están lejos del 90%, pero siguen siendo altas: Un tercio de los artículos de ciencias sociales no se citan

Pero esos análisis son engañosos, principalmente porque las publicaciones que contaron incluían documentos como cartas, correcciones, resúmenes de reuniones y otro material editorial, que normalmente no se citan. Si se eliminan estos documentos y se dejan sólo los trabajos de investigación y los artículos de revisión, las tasas de no citación caen en picado. Si se amplía el límite más allá de los cinco años, los índices se reducen aún más.

Con un recorte de diez años sigue habiendo artículos no citados, por supuesto, pero varía de forma interesante según el campo. Los artículos biomédicos tienen un 4% de artículos no citados, la química tiene un 8% de material refractario y la física un 11%. Sin embargo, hay que tener en cuenta que si se eliminan las autocitaciones de los mismos autores, estos índices aumentan, a veces de forma notable. La tasa de no citación en diez años en todas las disciplinas, menos la autocitación, es de alrededor del 18%. Pero otra cosa que han descubierto estos estudios es que esta tasa ha ido disminuyendo durante muchos años. Es de suponer que esto se debe a un mejor acceso y búsqueda en las revistas y a una tendencia relacionada con listas de referencias más largas en general. (En el ámbito de las ciencias, ese aumento comienza en torno a 1980 y se ha acentuado en los últimos años).

Pero aún así… …los artículos en la zona de no citados tienden (como es de esperar) a estar en revistas mucho menos prominentes (aparentemente casi todos los artículos publicados en una revista de la que has oído hablar son citados por alguien). Y eso trae a colación el problema de la «materia oscura»: todas estas cifras proceden de revistas indexadas en la Web of Science, una cohorte grande, pero que (justificadamente) ignora las hordas de revistas que publican cualquier cosa. Hay que imaginar que las tasas de citación son abismales entre las «revistas» que fabrican papeles, y la gran mayoría de ellas son seguramente autocitas. Si contamos estas cosas como «papers», entonces el número de publicaciones sin impacto nunca vistas aumenta de nuevo».

Bibliografía:

Willians. Sierra «Are 90% of Academic Papers Really Never Cited? Reviewing the Literature on Academic Citations.» Impact of Social Sciences, 23 de abril de 2014, https://blogs.lse.ac.uk/impactofsocialsciences/2014/04/23/academic-papers-citation-rates-remler/.

Hamilton, David P. «Publishing by—and for?—the Numbers». Science, vol. 250, n.o 4986, diciembre de 1990, pp. 1331-32. science.org (Atypon), https://doi.org/10.1126/science.2255902.

Derek Lowe. Not So Many Uncited Papers, Actually. Science, 20 feb. 2018. https://www.science.org/content/blog-post/not-so-many-uncited-papers-actually. Accedido 16 de septiembre de 2022.

Meho, Lokman I. «The Rise and Rise of Citation Analysis». Physics World, vol. 20, n.o 1, enero de 2007, pp. 32-36. Institute of Physics, https://doi.org/10.1088/2058-7058/20/1/33.

Tainer, John A., et al. «Science, Citation, and Funding». Science, vol. 251, n.o 5000, 1991, pp. 1408-11. JSTOR, https://www.jstor.org/stable/2875794.

Van Noorden, Richard. «The Science That’s Never Been Cited». Nature, vol. 552, n.o 7684, diciembre de 2017, pp. 162-64. http://www.nature.com, https://doi.org/10.1038/d41586-017-08404-0.