Ebrahim, Nader Ale. «Effective Strategies for Increasing and Ethically Managing Citation Frequency.» SSRN, June 13, 2025. https://www.linkedin.com/pulse/effective-strategies-increasing-ethically-managing-nader-ale-ebrahim-gm2yf/

Las citas son un indicador ampliamente reconocido del impacto académico y la visibilidad de la investigación. Sin embargo, la frecuencia de citas está influenciada por múltiples factores estratégicos, técnicos y éticos. Este artículo presenta una discusión equilibrada sobre estrategias efectivas para aumentar y gestionar éticamente la frecuencia de citas, fundamentadas en principios de visibilidad de la investigación y ética de las citas. Basándose en los trabajos y materiales públicos del Dr. Nader Ale Ebrahim, el estudio detalla medidas prácticas para mejorar la descubribilidad, accesibilidad y alcance académico, advirtiendo a la vez contra la manipulación poco ética de las citas. El artículo ofrece un marco para guiar a los investigadores en la maximización del impacto académico legítimo, manteniendo la integridad en las citas.

1. Introducción

La frecuencia de citas juega un papel central en la evaluación de la influencia académica, la reputación y los rankings institucionales. Aunque una investigación impactante puede no atraer atención inmediata, una difusión estratégica puede mejorar significativamente las métricas de citas. Al mismo tiempo, la comunidad académica enfrenta un escrutinio creciente hacia prácticas poco éticas, como la auto-citación excesiva y los carteles de citas. Este artículo busca presentar estrategias basadas en evidencia para aumentar la frecuencia de citas, enfatizando límites éticos y acciones que, justificadamente, podrían reducirlas.

2. Estrategias para aumentar la frecuencia de citas

2.1 Optimización de metadatos y títulos

La visibilidad de la investigación comienza con títulos, resúmenes y metadatos bien estructurados. Repetir palabras clave relevantes en el resumen y elegir títulos precisos mejora significativamente la indexación en bases de datos. La optimización de metadatos incrementa la probabilidad de que la investigación sea recuperada por motores de búsqueda académicos.

2.2 Publicar en revistas de alta visibilidad

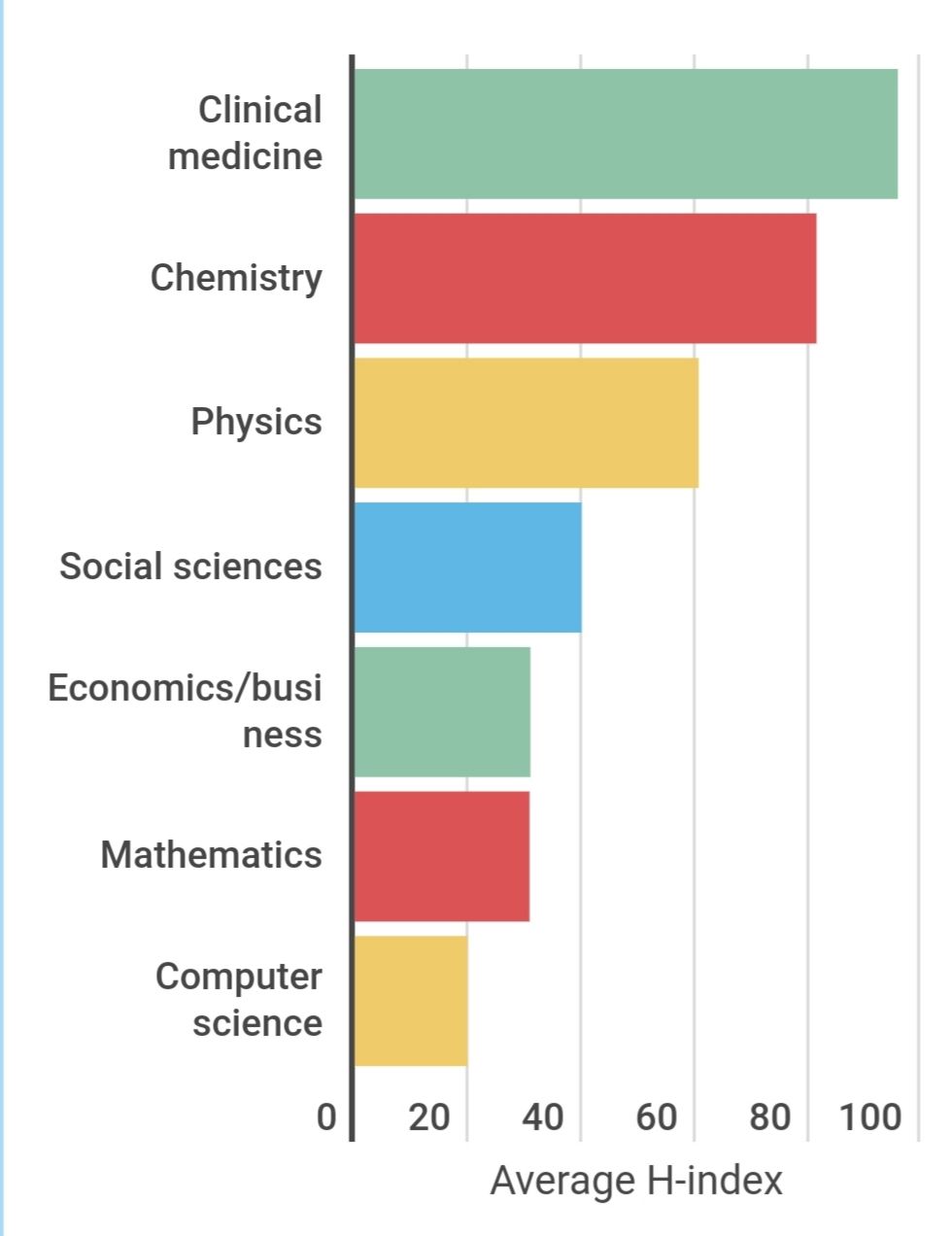

La selección de revistas es un factor determinante para el desempeño en citas. Los artículos en revistas bien indexadas y de alto impacto tienen mayor probabilidad de ser citados debido a su amplia difusión. Se recomienda apuntar a revistas con lectores establecidos y presencia en Scopus, Web of Science y DOAJ.

2.3 Adoptar acceso abierto y autoarchivo

Numerosos estudios muestran que los artículos en acceso abierto reciben más citas. Hacer preprints o postprints disponibles públicamente a través de repositorios institucionales y plataformas como arXiv o SSRN aumenta la descubribilidad. La visibilidad es clave para el impacto.

2.4 Mantener una presencia digital actualizada

Perfiles profesionales en plataformas como Google Scholar, ORCID, ResearchGate y páginas institucionales deben estar siempre actualizados para amplificar el alcance y la indexación del trabajo académico.

2.5 Expandir colaboraciones

La investigación muestra que colaboraciones internacionales e interdisciplinarias se correlacionan positivamente con mayores tasas de citas. Los artículos con múltiples coautores, especialmente de distintas instituciones o países, atraen una audiencia más diversa.

2.6 Utilizar redes sociales y académicas

Difundir la investigación mediante redes sociales (LinkedIn, Twitter/X), plataformas académicas y blogs extiende el alcance más allá de los lectores tradicionales de revistas. Estas actividades son esenciales en las estrategias modernas de difusión.

2.7 Publicar artículos de revisión y encuestas

Los artículos de revisión, meta-análisis y encuestas suelen atraer más citas que la investigación original por su mayor atractivo. Apuntar a revistas de alto impacto con revisiones es una estrategia probada para aumentar citas.

2.8 Compartir datos y preprints

Los investigadores que comparten conjuntos de datos o documentos en proceso suelen recibir más citas. Los datos abiertos mejoran la replicabilidad y la credibilidad, y amplían el uso del trabajo por otros académicos.

3. Estrategias para gestionar éticamente la frecuencia de citas

3.1 Evitar la auto-citación excesiva

Mantener una tasa equilibrada de auto-citación es esencial para la ética académica. Monitorizar las auto-citas con plataformas como Scopus o Google Scholar ayuda a mantener transparencia y credibilidad.

3.2 Asegurar la relevancia en las referencias

Solo se deben incluir citas que apoyen el argumento o proporcionen contexto necesario. El exceso de referencias puede disminuir la calidad del artículo y provocar solicitudes editoriales para reducirlas.

3.3 Prevenir la manipulación de citas

Prácticas poco éticas como peticiones coercitivas de cita, carteles de citas o referencias irrelevantes distorsionan las métricas académicas. Quienes las practiquen arriesgan daños reputacionales y sanciones, incluyendo la exclusión de bases de datos.

3.4 Practicar la transparencia en las citas

Hacer seguimiento de las fuentes de citas y entender las métricas, incluyendo la exclusión de auto-citas, ayuda a los investigadores a rendir cuentas. Promover la ética en las citas es parte fundamental de una investigación responsable.

4. Conclusión

Aumentar la frecuencia de citas requiere combinar investigación de calidad, difusión estratégica y prácticas éticas. El trabajo del Dr. Nader Ale Ebrahim demuestra que no solo el contenido importa, sino también cómo se comparte y accede a él. Mantener la integridad en las citas asegura que las contribuciones académicas sean creíbles y éticamente fundamentadas. Este enfoque equilibrado brinda a los investigadores las herramientas para construir un perfil académico sólido y contribuir responsablemente al ecosistema científico.

References

1. Ale Ebrahim, N. (Access to Publications). SSRN Author Page. Retrieved from https://papers.ssrn.com/sol3/cf_dev/AbsByAuth.cfm?per_id=1379350

2. Ale Ebrahim, N. (Teaching Materials). Figshare Author Page. Retrieved from https://figshare.com/authors/Nader_Ale_Ebrahim/100797

3. Moed, H. F. (2005). Citation analysis in research evaluation. Springer.

4. Bornmann, L., & Daniel, H.-D. (2008). What do citation counts measure? A review of studies on citing behavior, Journal of Documentation, 64(1), 45–80.

5. Björk, B.-C., & Solomon, D. (2012). Open access versus subscription journals: A comparison of scientific impact. BMC Medicine, 10(1), 73.

6. Tahamtan, I., Afshar, A. S., & Ahamdzadeh, K. (2016). Factors affecting the number of citations: A comprehensive review of the literature. Scientometrics, 107(3), 1195–1225.

7. Harzing, A. W. (2010). The Publish or Perish Book: Your guide to effective and responsible citation analysis. Tarma Software Research.

8. How to improve your visibility as a researcher, available online at: https://authorservices.taylorandfrancis.com/blog/research-impact/how-to-improve-research-visibility/

9. Ale Ebrahim, N. (2025). AI-Powered Tools and Strategies to Boost Research Visibility and Impact [Presentation]. Figshare. https://doi.org/10.6084/m9.figshare.28877966.v1

10. Ale Ebrahim, N. (2025). AI-Driven Research Tools for Literature Search, Writing, Publishing, and Boosting Research Visibility and Impact [Presentation]. Figshare. https://doi.org/10.6084/m9.figshare.28369517.v1

11. Ale Ebrahim, N. (2025). AI Application for Maximizing Research Visibility and Impact through Open Science [Presentation]. Figshare. https://doi.org/10.6084/m9.figshare.28306838.v1