Haider, Jutta, Kristofer Rolf Söderström, Björn Ekström, y Malte Rödl. «GPT-Fabricated Scientific Papers on Google Scholar: Key Features, Spread, and Implications for Preempting Evidence Manipulation». Harvard Kennedy School Misinformation Review, 3 de septiembre de 2024. https://doi.org/10.37016/mr-2020-156.

El estudio analiza la aparición de publicaciones científicas cuestionables, producidas con transformadores pre-entrenados generativos (GPT), en Google Scholar. Se investiga dónde se publican o depositan estos trabajos, sus características principales, cómo se difunden en la infraestructura de comunicación académica y cómo desafían el rol de esta infraestructura en mantener la confianza pública en la ciencia.

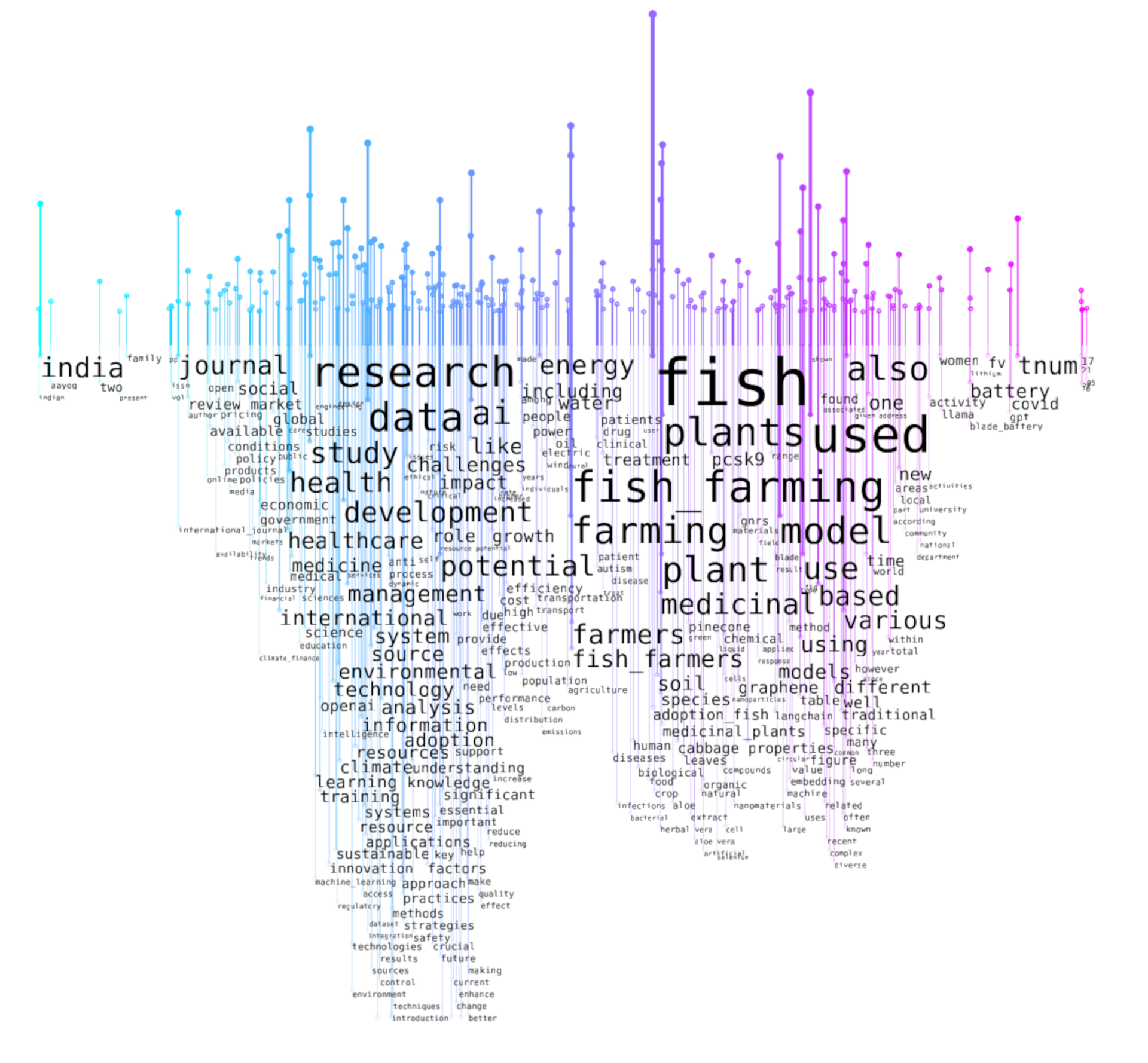

Para elaborar el estudio se realizó una búsqueda y extracción de datos en Google Scholar utilizando la biblioteca de Python Scholarly (Cholewiak et al., 2023) para identificar artículos que contenían frases comunes generadas por ChatGPT y aplicaciones similares basadas en el mismo modelo subyacente (GPT-3.5 o GPT-4): «a partir de mi última actualización de conocimiento» y/o «no tengo acceso a datos en tiempo real». Esto permitió identificar artículos que probablemente usaron inteligencia artificial generativa para producir texto, resultando en 227 artículos recuperados. La información bibliográfica de estos artículos se añadió automáticamente a una hoja de cálculo y se descargó en Zotero.

Todos los artículos contenían al menos una de las dos frases comunes devueltas por los agentes conversacionales que utilizan grandes modelos de lenguaje (LLM) como ChatGPT de OpenAI. A continuación, se utilizó la búsqueda de Google para determinar en qué medida existían copias de artículos cuestionables elaborados con GPT en diversos repositorios, archivos, bases de datos de citas y plataformas de redes sociales.

Para explorar la extensión del trabajo generado por ChatGPT en el índice de Google Scholar, se realizó un estudio que rastreó la plataforma en busca de publicaciones que contenían respuestas comunes de ChatGPT. El análisis reveló que alrededor del 62% de estos artículos no declaraban el uso de GPT, con la mayoría encontrados en revistas no indexadas y documentos de trabajo, aunque algunos aparecían en revistas y actas de conferencias de prestigio. Es notable que el 57% de estos artículos estaban relacionados con áreas de política susceptibles a operaciones de influencia. La mayoría de estos documentos estaban relacionados con temas relevantes para políticas públicas, como el medio ambiente, la salud y la informática, que son susceptibles de ser manipulados.

La presencia de texto generado por GPT se observó en diversas secciones de los artículos, incluyendo revisiones de literatura, métodos, marcos teóricos y discusiones. Esto sugiere un uso generalizado de GPT en la creación de artículos completos, lo que genera preocupaciones sobre la integridad de las publicaciones científicas y la posibilidad de lo que se denomina «piratería de evidencia»—la manipulación deliberada de la base de evidencia para influir en la opinión pública y en las políticas.

La proliferación de publicaciones fabricadas pone en riesgo la integridad del sistema de comunicación académica y socava la confianza en la ciencia. Además, la posibilidad de que estos textos falsos sean recuperados por motores de búsqueda académicos como Google Scholar aumenta el riesgo de manipulación maliciosa de la evidencia científica.

Para mitigar estos riesgos, el estudio recomienda un enfoque multifacético que incluya medidas técnicas, educativas y regulatorias. Estas podrían implicar opciones de filtrado en los motores de búsqueda académicos para distinguir entre literatura revisada por pares y literatura gris, así como el desarrollo de un motor de búsqueda académico no comercial para uso público. Las iniciativas educativas dirigidas a los responsables de la formulación de políticas, periodistas y otros profesionales de los medios también son cruciales para mejorar la alfabetización mediática e informativa y reducir el impacto de la desinformación.

Este problema no solo se deriva del uso de generadores de texto como ChatGPT, sino que también refleja preocupaciones más amplias sobre el sistema de publicaciones académicas y la monopolización de la información por parte de plataformas como Google Scholar. La proliferación de artículos fraudulentos puede erosionar la confianza en la ciencia, con consecuencias graves para la sociedad y la forma en que se manejan las «desórdenes de información».

El estudio concluye que el problema de los artículos fabricados por GPT probablemente se vuelva más generalizado, con implicaciones significativas para la credibilidad de la comunicación científica y la confianza pública en la ciencia. Para abordar este problema, es esencial entender las razones subyacentes a la proliferación de dicho contenido y desarrollar estrategias para prevenir su manipulación y difusión.