Brian A. Nosek, David B. Allison, Kathleen Hall Jamieson, Marcia McNutt, A. Beau Nielsen y Susan M. Wolf. A Framework for Assessing the Trustworthiness of Scientific Research Findings. Proceedings of the National Academy of Sciences of the United States of America (PNAS), Vol. 123, No. 6, e2536736123, publicado el 3 de febrero de 2026. DOI: 10.1073/pnas.2536736123

El artículo propone un marco conceptual estructurado para evaluar qué hace que los resultados científicos sean confiables, abordando debates actuales sobre la integridad y la credibilidad de la investigación en múltiples áreas del conocimiento.

Los autores —expertos en metodología, comunicación científica, ética e integridad de la investigación— argumentan que no existe una única respuesta simple a la pregunta de qué hace que los hallazgos científicos sean dignos de confianza, dado que enfoques tradicionales como la reputación de la revista, el recuento de citas o la revisión por pares por sí solos son indicadores insuficientes y a veces engañosos de la calidad real de la investigación. En lugar de esto, proponen un enfoque de sistemas que se centra en prácticas y estructuras observables que pueden facilitar la evaluación de la confiabilidad de los resultados.

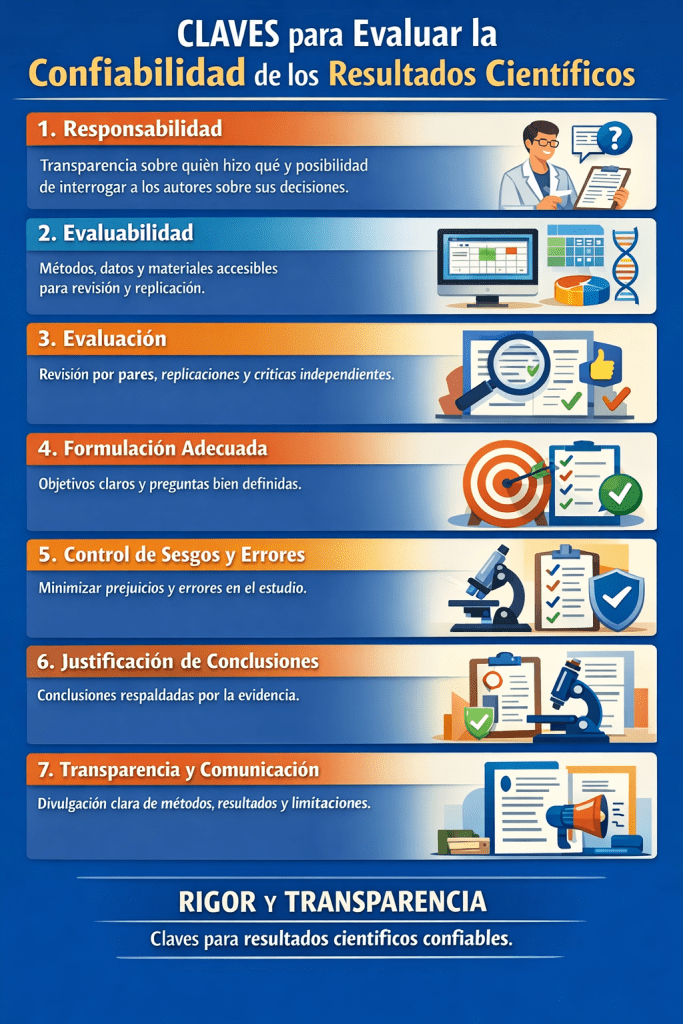

El marco desarrollado se organiza en siete componentes esenciales que, en conjunto, ayudan a juzgar la confianza que se puede depositar en una investigación. Estos pilares incluyen si el estudio es responsable (accountable), es decir, si quienes lo realizan son transparentes y responsables de sus decisiones; si es evaluable, lo que significa que sus métodos y datos pueden ser examinados por otros; si ha sido evaluado —por pares, por replicación o por crítica—; si está bien formulado, con objetivos claros y relevantes; si controla sesgos y errores y, finalmente, si las conclusiones están justificadas por la evidencia. Según los autores, estos aspectos combinados permiten un juicio más sólido sobre la confianza en los hallazgos que los simples proxies externos de reputación o prestigio.

Además, el artículo subraya que la confiabilidad no es sinónimo de corrección absoluta: un resultado puede ser imperfecto o incluso incorrecto en algún detalle, pero aún así ser confiable si ha sido producido y comunicado de manera que los errores sean transparentes y susceptibles de ser detectados y corregidos con el tiempo. Esta distinción es crucial, ya que refleja que la ciencia es un proceso acumulativo en el que la capacidad de detectar errores y aprender de ellos es lo que permite avanzar en el conocimiento. El marco enfatiza también la importancia de crear lenguajes comunes y métricas significativas para que investigadores, instituciones, revistas científicas, financiadores e incluso el público puedan evaluar y comunicar mejor la confiabilidad de la investigación.

Finalmente, los autores señalan que adoptar este marco no resolverá todos los problemas de la ciencia por sí mismo, pero puede servir como una herramienta integral para mejorar la evaluación de la investigación más allá de estándares obsoletos. Al centrarse en comportamientos y prácticas que fomentan el escrutinio crítico, la transparencia, la reducción de sesgos y la evidencia sólida, el marco pretende fortalecer la base de confianza en la ciencia, contribuyendo a que los hallazgos sean más útiles y significativos tanto para la comunidad académica como para la sociedad en general.

7 aspectos clave del marco para evaluar la confiabilidad de los resultados científicos, explicados uno por uno con detalle:

1. Responsabilidad (Accountability)

Los investigadores deben ser transparentes y responsables sobre cómo diseñaron, condujeron y reportaron su estudio. Esto implica que haya claridad en quién hizo qué, y que los autores puedan ser contactados o interrogados sobre sus decisiones. La responsabilidad fomenta la confianza porque asegura que no hay ocultamiento de información crucial.

2. Evaluabilidad (Evaluability)

Los métodos, datos y resultados deben ser accesibles y presentados de tal forma que otros científicos puedan revisar, reproducir o cuestionar el trabajo. Esto incluye compartir datos abiertos, protocolos, códigos y materiales usados, para que el estudio pueda ser examinado y validado por terceros.

3. Evaluación (Assessment)

El estudio debe haber sido sometido a algún tipo de revisión crítica, ya sea a través del proceso tradicional de revisión por pares, revisiones independientes, replicaciones por otros investigadores o críticas constructivas. La evaluación rigurosa ayuda a detectar errores o sesgos que podrían afectar la confiabilidad.

4. Formulación adecuada (Well-formulated)

El problema de investigación debe estar claramente definido, con objetivos precisos y relevantes. Un estudio bien planteado evita ambigüedades que dificultan interpretar los resultados y asegura que las preguntas que busca responder son importantes y están claramente expresadas.

5. Control de sesgos y errores (Control of biases and errors)

Los investigadores deben usar métodos para minimizar la influencia de prejuicios, errores sistemáticos o aleatorios que podrían distorsionar los resultados. Esto puede incluir diseño experimental riguroso, uso de controles, aleatorización y análisis estadísticos adecuados para validar la robustez del hallazgo.

6. Justificación de conclusiones (Justification of conclusions)

Las conclusiones que se presentan deben estar respaldadas por la evidencia empírica recogida. No basta con afirmar algo llamativo o deseable; debe haber una relación clara entre los datos y las interpretaciones o afirmaciones que se hacen.

7. Transparencia y comunicación (Transparency and communication)

Finalmente, el estudio debe comunicar claramente los métodos, limitaciones, resultados y cualquier conflicto de interés. La transparencia en la comunicación permite que otros comprendan plenamente el contexto y alcance del estudio, y facilita que se interpreten correctamente los hallazgos.