Rainie, Lee y American Association of Colleges and Universities. The AI Challenge: How College Faculty Assess the Present and Future of Higher Education in the Age of AI. Imagening the Digital Future Center (Elon University), 2026.

Direct to Full Text Report (26 pages; PDF)

Methodology and Topline (21 pages; PDF)

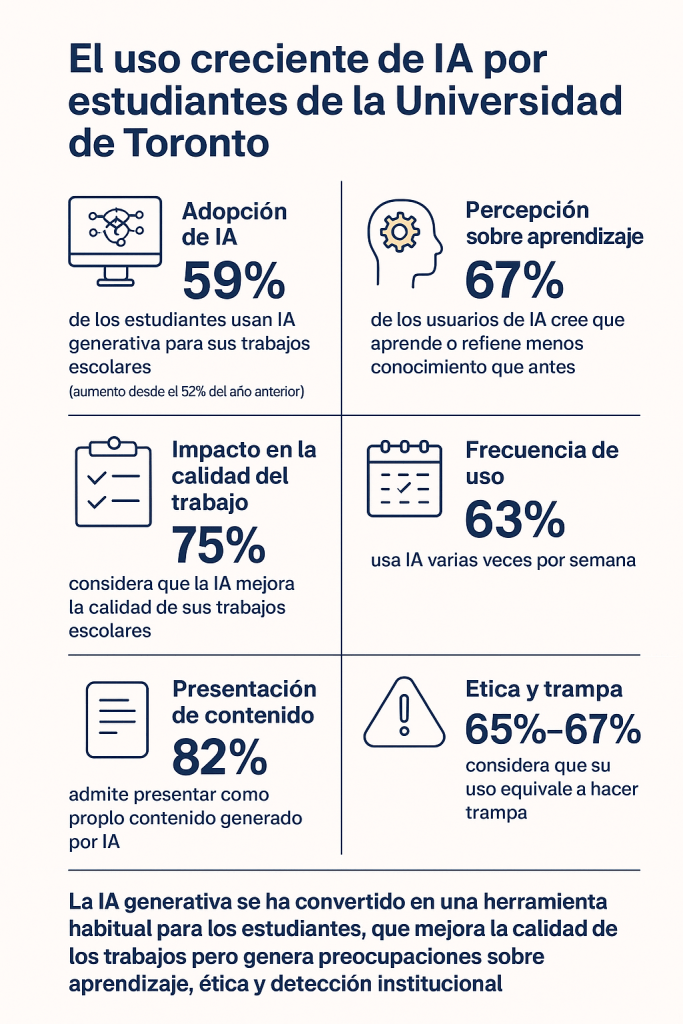

El informe colaborativo del Imagining the Digital Future Center y la American Association of Colleges and Universities presenta los resultados de una encuesta nacional realizada entre más de 1.000 profesoras y profesores universitarios sobre cómo la inteligencia artificial generativa (IA) está afectando la enseñanza, el aprendizaje y la integridad académica en la educación superior actual

El hallazgo más contundente es la preocupación generalizada del profesorado sobre la influencia de la IA en el pensamiento crítico y la honestidad académica: un 95 % de los docentes encuestados cree que las herramientas de IA generativa pueden incrementar la dependencia de los estudiantes en estas tecnologías y debilitar sus habilidades críticas, y una gran mayoría señala que han observado un aumento de problemas de integridad académica desde que estas herramientas se han popularizado. Muchos profesores piensan que estos cambios impactan directamente en la misión fundamental de la educación superior, poniendo en riesgo tanto la calidad del aprendizaje como el valor de los títulos universitarios.

No obstante, el informe también reconoce un reconocimiento creciente del potencial positivo de la IA, especialmente en aspectos relacionados con la personalización del aprendizaje y la eficiencia en ciertos procesos educativos. Un porcentaje significativo de docentes ya incluye temas de alfabetización en IA —como sesgos, privacidad y ética— en sus clases y muchos han desarrollado políticas explícitas sobre el uso aceptable de IA en los trabajos académicos. Los resultados destacan, además, que la mayoría de las instituciones todavía no están bien preparadas para implementar la IA de manera efectiva, y que existe una fragmentación en las políticas institucionales. En conjunto, el informe plantea que el desafío no radica en si la IA transformará la educación superior, sino en cómo las universidades encauzarán ese cambio para fortalecer el aprendizaje, la integridad y los valores educativos fundamentales.

Datos clave:

- Alcance de la encuesta

Más de 1.000 profesores universitarios participaron a nivel nacional.

Evaluó el uso, percepción y políticas relacionadas con la inteligencia artificial generativa (IA) en la enseñanza.

- Preocupaciones principales

95 % de los docentes cree que la IA puede debilitar el pensamiento crítico de los estudiantes.

Mayoría observa un incremento en problemas de integridad académica desde la popularización de la IA.

Temor a que la IA afecte la calidad del aprendizaje y el valor de los títulos universitarios.

- Reconocimiento del potencial

La IA puede personalizar el aprendizaje y mejorar la eficiencia en tareas educativas.

Muchos docentes incorporan alfabetización en IA, incluyendo ética, sesgos y privacidad.

Se desarrollan políticas explícitas sobre el uso aceptable de IA en trabajos académicos.

- Desafíos institucionales

La mayoría de las universidades no están completamente preparadas para integrar la IA de manera efectiva.

Existen diferencias importantes entre instituciones en cuanto a políticas y regulaciones sobre IA.

- Conclusión

La IA transformará la educación superior, pero el reto real es cómo las universidades guían esta transformación para proteger la integridad académica y mejorar el aprendizaje.