Ipsos. “Ipsos Veracity Index 2025.” Última modificación 2025. Accedido el 16 de diciembre de 2025. https://www.ipsos.com/en-uk/ipsos-veracity-index-2025

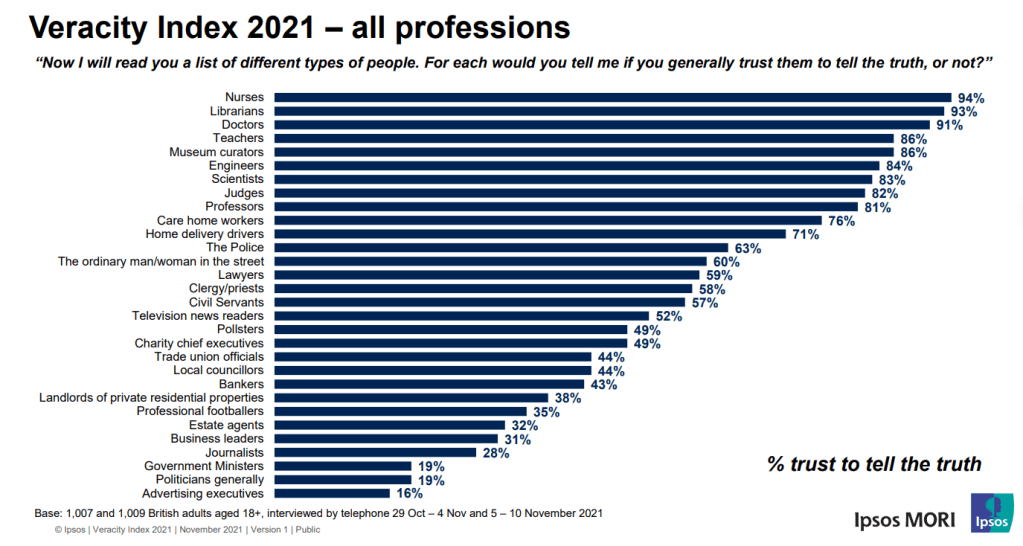

Las últimas encuestas de Veracity Index situaron a los bibliotecarios como una de las profesiones más confiables del Reino Unido, tradicionalmente muy arriba en la escala de confianza — incluso en el top 3 en ediciones previas.

Ipsos Veracity Index 2025 es una encuesta representativa de adultos en Gran Bretaña que mide qué profesiones el público considera más confiables para “decir la verdad” en 2025. El estudio compara la percepción actual con años anteriores y examina diferencias entre votantes de distintos partidos políticos.

Este estudio, iniciado en 1983 en el Reino Unido, recoge año tras año qué grupos profesionales son vistos como los más honestos y cuáles despiertan más desconfianza entre la población británica. Aunque el informe publicado en 2025 no enumera a los bibliotecarios entre las diez profesiones más confiadas, la historia reciente de la encuesta muestra que esta figura profesional ha ocupado tradicionalmente posiciones muy altas en la clasificación de confianza pública.

En la edición de 2021 del Veracity Index, los bibliotecarios aparecieron explícitamente entre las profesiones más confiables del Reino Unido, con un impresionante 93 % de los encuestados declarando que confiaban en ellos para decir la verdad. En ese año, sólo enfermeros superaron ligeramente ese nivel de confianza y los bibliotecarios quedaron claramente por delante de médicos, maestros y curadores de museo, consolidando su reputación como guardianes de la información veraz y asesores imparciales. Esta confianza tan alta refleja cómo la sociedad valora el rol tradicional de los bibliotecarios como intermediarios entre el conocimiento y la comunidad, especialmente en tiempos de alta desinformación y polarización informativa.

Los datos recogidos en 2023 también respaldan esta tendencia histórica, aunque con un enfoque más amplio en las profesiones científicas y académicas. En esa edición, los bibliotecarios seguían figurando entre las cinco profesiones con mayores niveles de confianza, con cifras en torno al 86 % — muy cerca de otros grupos también muy valorados, como pilotos de avión, médicos e ingenieros. El mantenimiento de este nivel no sólo ratifica la imagen de los bibliotecarios como profesionales íntegros y veraces, sino que además sitúa su función social en un contexto donde la alfabetización informacional y la facilitación del acceso a fuentes fiables son cada vez más críticas.

Al llegar al informe de 2025, aunque el comunicado principal de Ipsos no menciona explícitamente a los bibliotecarios en el top cinco de profesiones más confiadas —que en ese año son enfermeros, ingenieros, médicos, docentes y profesores universitarios— es importante interpretar estos resultados a la luz de la trayectoria de la profesión. El enfoque del índice puede variar ligeramente de un año a otro, con cambios en las profesiones incluidas o en la manera de agruparlas, pero la tendencia general sugiere que los bibliotecarios siguen siendo asociados con altos niveles de credibilidad, especialmente si los comparamos con profesiones menos confiadas como políticos, ministros de gobierno o influencers.

La posición históricamente alta de los bibliotecarios en el índice de confianza puede entenderse en relación con el papel social que desempeñan: no sólo custodios de colecciones físicas, sino mediadores críticos en la era digital, promotores de alfabetización mediática y defensores de la imparcialidad informativa. La percepción pública de los bibliotecarios como agentes neutrales, enfocados en facilitar el acceso a información rigurosa y en apoyar a estudiantes, investigadores y ciudadanos en general, ha contribuido a que se les otorgue una credibilidad sostenida a lo largo de los años