Bjelobaba, Sonja, Lorna Waddington, Mike Perkins, Tomáš Foltýnek, Sabuj Bhattacharyya, y Debora Weber-Wulff. “Maintaining Research Integrity in the Age of GenAI: An Analysis of Ethical Challenges and Recommendations to Researchers.” International Journal for Educational Integrity 21, no. 18 (2025). https://doi.org/10.1007/s40979-025-00191-w.

El artículo analiza los desafíos éticos emergentes derivados del uso creciente de herramientas de inteligencia artificial generativa (GenAI) en el ciclo de vida de la investigación académica. A través de una revisión rápida basada en la práctica, los autores identifican riesgos como la generación de contenido no verificable, la atribución inadecuada de autoría, y la posible erosión de la integridad académica.

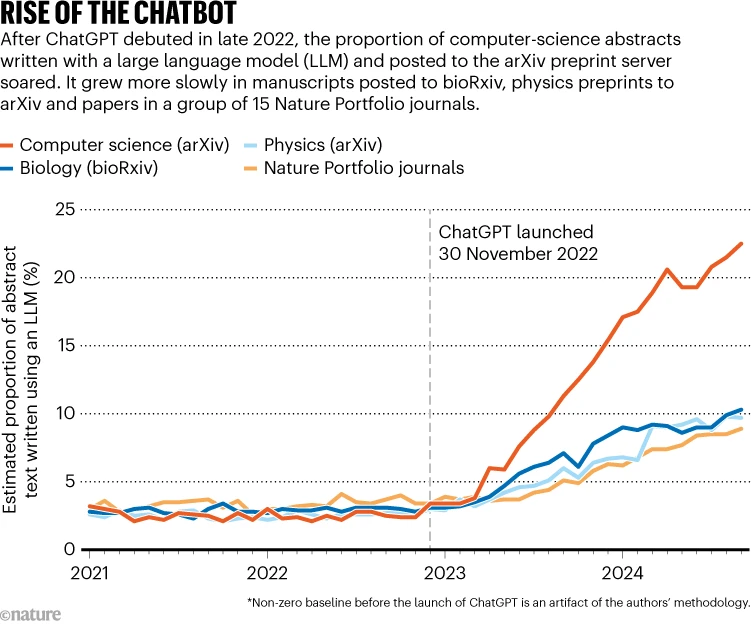

En los últimos años, el uso de inteligencia artificial generativa (GenAI) ha transformado drásticamente el panorama académico. Aunque se ha hablado extensamente sobre su impacto en el ámbito educativo —especialmente entre estudiantes—, existe aún poca investigación sobre cómo estas herramientas afectan el proceso investigador. Este artículo se propone llenar ese vacío, analizando los desafíos éticos que plantea el uso de GenAI en todas las etapas del ciclo de investigación académica, desde la formulación de hipótesis hasta la revisión por pares, con el objetivo de ofrecer recomendaciones claras para un uso responsable.

Los autores emplean una revisión rápida que combina literatura científica reciente con análisis práctico del funcionamiento de herramientas de GenAI aplicadas al trabajo investigador. Como marco ético, se basan en el Código Europeo de Conducta para la Investigación, que establece los principios fundamentales de fiabilidad, honestidad, respeto y responsabilidad. A partir de esta estructura, el artículo examina cómo estas herramientas pueden interferir, beneficiar o perjudicar las distintas fases del proceso científico.

En la formulación de preguntas de investigación y diseño de estudios, GenAI puede ayudar a generar ideas iniciales, pero muchas veces estas son superficiales, repetitivas o carentes de originalidad. Además, los modelos tienden a reproducir sesgos previos y, en algunos casos, suprimen ciertos temas o expresiones por filtros ideológicos o comerciales, lo que plantea un problema de censura encubierta. Estas dinámicas pueden limitar el pensamiento crítico y afectar la libertad académica.

Durante la revisión bibliográfica, el uso de GenAI presenta varios riesgos. Algunas herramientas proporcionan referencias aparentemente válidas, pero que no existen —las llamadas “alucinaciones”—, o bien generan resúmenes que reproducen fragmentos literales, incurriendo en plagio inadvertido. Además, al cargar documentos protegidos por derechos de autor en estos sistemas, los investigadores pueden estar vulnerando normativas de propiedad intelectual, especialmente si las plataformas se quedan con una copia de los datos.

En la fase de recogida de datos, se advierte sobre el uso de GenAI para diseñar encuestas, formular entrevistas o transcribir audios. Las herramientas pueden no captar sutilezas culturales o lingüísticas, generando sesgos significativos. Asimismo, su uso en la transcripción o anonimización de datos puede violar leyes de protección de datos, sobre todo si el procesamiento se hace en servidores externos. Esto representa un riesgo ético y legal que debe ser gestionado desde el principio del proyecto.

El análisis de datos con apoyo de GenAI también está lleno de desafíos. Si bien puede ayudar a procesar grandes volúmenes de información, hay riesgo de interpretar incorrectamente resultados estadísticos o de generar conclusiones falsas. En particular, el uso de GenAI para anonimizar información sensible no es fiable, y puede permitir la reidentificación de personas si los modelos conservan trazas de los datos originales.

Durante la redacción de artículos académicos, se han detectado problemas como la omisión de comillas o referencias, la producción de frases sintácticamente confusas, y la inclusión de ideas mal citadas o alteradas. Todo ello puede derivar en acusaciones de plagio o mala praxis. En el ámbito de la traducción, aunque los LLM ofrecen resultados aceptables, también existe el riesgo de “falsos positivos” en detectores de IA, especialmente en manuscritos traducidos por hablantes no nativos.

En la revisión por pares y publicación científica, se subraya que GenAI no puede figurar como autor, ya que no puede asumir responsabilidades ni declarar conflictos de interés. Aun así, estas herramientas están siendo utilizadas para evaluar artículos, lo que plantea dudas sobre la transparencia del proceso. Además, el uso indiscriminado de GenAI puede incentivar prácticas cuestionables como el «salami slicing» (división artificial de investigaciones) o la proliferación de artículos fraudulentos en publicaciones depredadoras.

Entre los riesgos éticos identificados se destacan: la falta de transparencia en el uso de GenAI, el incumplimiento de derechos de autor, la exposición de datos personales, la generación de contenidos plagiados o erróneos, la reproducción de sesgos y estereotipos, la censura por diseño, y la fabricación de datos o resultados. Estos riesgos pueden acumularse a lo largo del proceso investigador y poner en peligro la integridad científica.

Como respuesta, el artículo ofrece recomendaciones claras: documentar y declarar el uso de GenAI en cada fase del trabajo; verificar manualmente los resultados generados; evitar subir materiales con derechos de autor sin permiso explícito; utilizar plataformas que garanticen privacidad y no reclamen propiedad sobre los contenidos; preferir el procesamiento local cuando sea posible; y fomentar normativas institucionales que regulen el uso de estas herramientas con criterios éticos.

Recomendaciones

Basándose en los principios del código europeo, el artículo propone medidas como:

– Documentar y declarar el uso de GenAI en la metodología.

– Verificar manualmente todas las salidas generadas.

– No cargar contenido con copyright sin permiso.

– Emplear herramientas que rastreen fuentes originales.

– Seleccionar servicios que no reclamen propiedad intelectual.

– Considerar la privacidad desde el inicio (optar por procesamiento local si es posible).

– Mantener supervisión ética del diseño, recogida, análisis y publicación de datos.

– Fomentar políticas institucionales claras. Individualmente, los investigadores deben asumir responsabilidad de transparencia y precisión .