Tutorial de Mendely con las nuevas incorporaciones y ejercicios

Más de 24.000 descargas actualmente

Oír PODCAST de Planeta Biblioteca

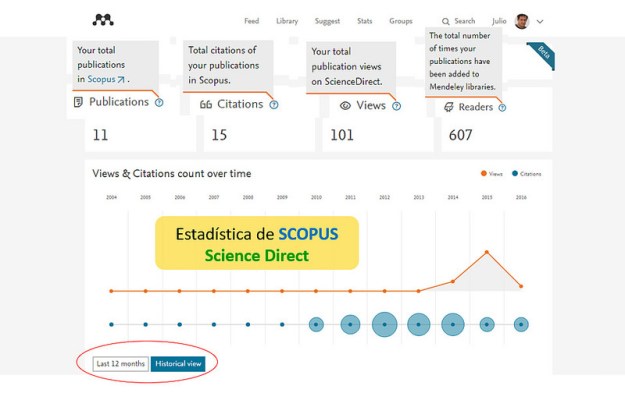

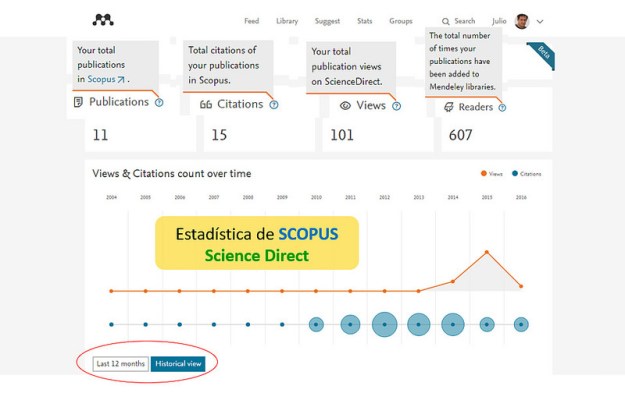

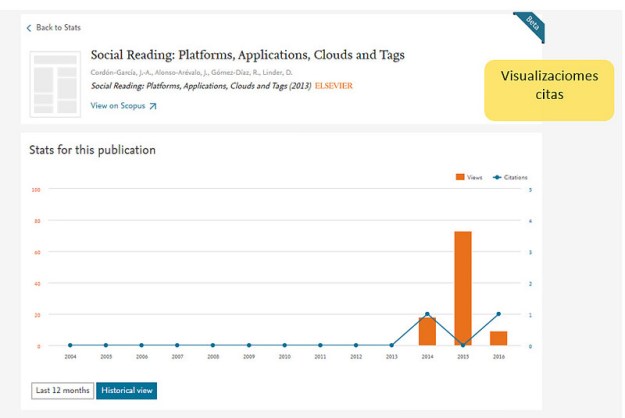

Entre los nuevos avances está la integración entre Mendeley y Scopus. Las estadísticas que encontramos en la versión web de Mendeley ya muestran la correlación entre los datos de veces que se ha compartido una publicación en Mendeley y las citas recibidas por SCOPUS. Esto también da lugar a que los usuarios de Mendeley tengan una manera fácil de acceder y agregar metadatos de millones de publicaciones de Scopus. De este modo el investigador podrá ser capaz de importar todas sus publicaciones a la vez, lo que evita la entrada de datos manualmente mediante un proceso tedioso.

Estadísticas con datos de SCOPUS y SCIENCE DIRECT

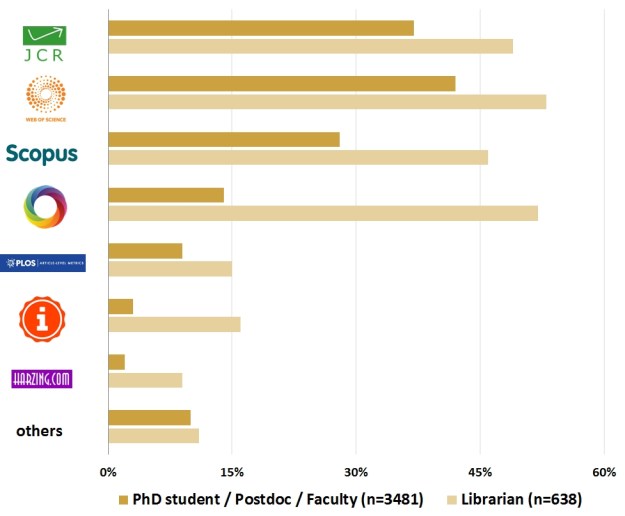

Mendeley muestra cuántos lectores y las descargas tienen nuestras publicaciones, y se incluye en casi todos las plataformas de medición altmétrica como Altmetric.com, ImpactStory, o Plos Altmetrics; lo que configura a este gestor de referencias como la herramienta más adecuada para el investigador. Se trata de un índice de popularidad.

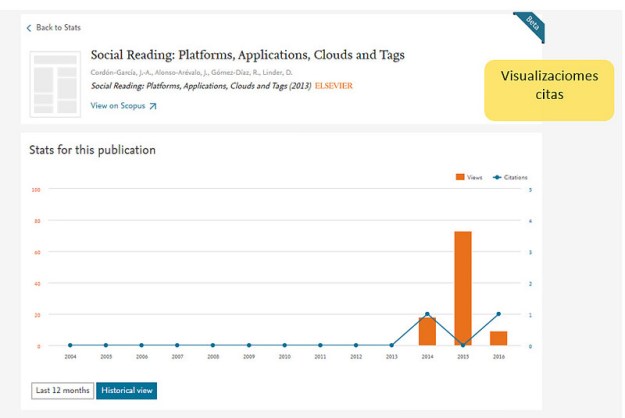

Correlación entre las veces que se compartió la publicación y las citas recibidas en SCOPUS

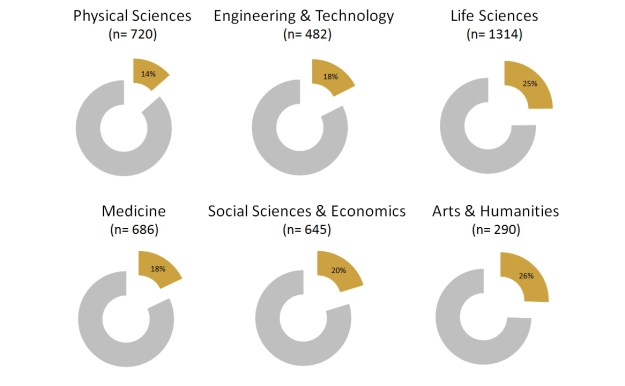

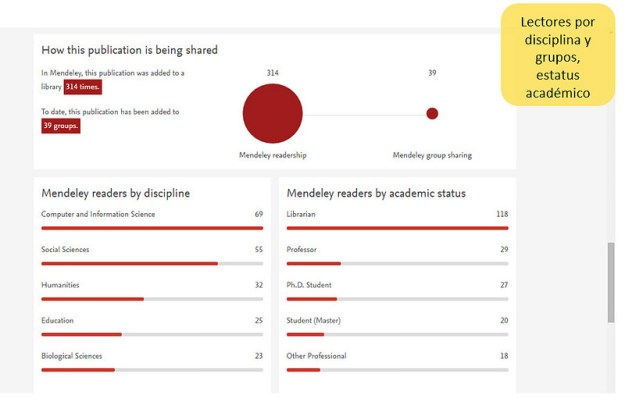

Pero no sólo proporciona datos de los lectores que compartieron la publicación que a veces pueden ser miles, si no que además da datos sobre perfiles de los lectores y áreas de procedencia temática y geográfica.

Investigadores que compartieron la publicación por categorías y áreas

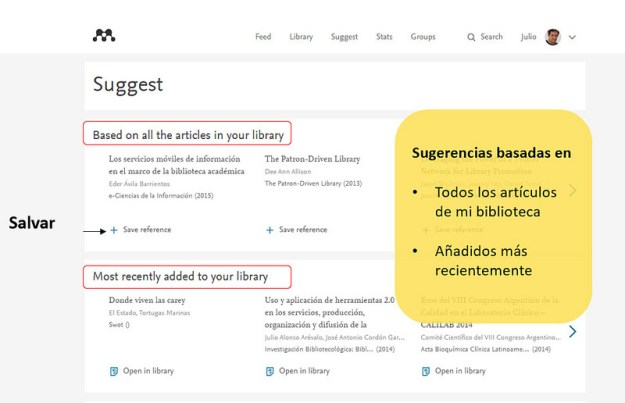

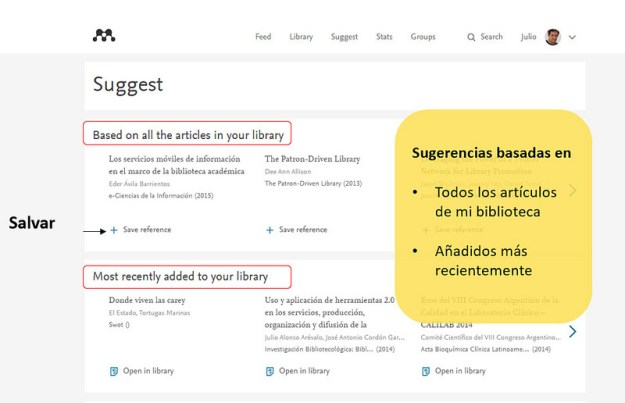

Otra de las novedades en la web es el módulo de recomendaciones, con sugerencias basadas en diferentes criterios

- Todos los artículos de mi biblioteca

- Añadidos más recientemente

- Áreas de interés

- Más populares de la disciplina

- El último documento añadido

- Último documento leído

- Los más populares de la disciplina

La compañía se refiere a sí misma como una “Wikipedia para información académica”, donde los usuarios de una comunidad global de 4 millones de investigadores ha creado una base de datos compartida de más de 360 millones de documentos (según datos del blog Mendeley). Mendeley dice que esto cubre alrededor de un 97,2% a un 99,5% de los artículos de investigación publicados en los últimos años. Cifra que lo convierte en un recurso de información de gran alcance. Y lo más importante es que la información que alimenta este ecosistema ha sido creada por la propia comunidad científica.

La empresa considera que el crowdsourcing -microvoluntariado- de datos agrega una tinte social a la labor académica y a la cooperación científica. Cada documento incluye información en tiempo real sobre el estado de la investigación, su ubicación, y las palabras clave generadas por sus lectores. Mendeley también añade información acerca de los documentos de investigación relacionados y grupos públicos de Mendeley en los que se discute sobre la misma. Además a plataforma de Mendeley intenta a su vez satisfacer la necesidad de métricas rápidas y granulares del impacto científico de una investigación.

En la nueva versión Mendeley, se ha añadido un nuevo punto de vista que proporciona una manera fácil de encontrar rápidamente los artículos que están relacionados con el contenido en la versión de escritorio seleccionado en función de tes aspectos:

1. Recomendaciones instantánea basado en artículos específicos – Seleccionando un sólo documento, un grupo de documentos o una carpeta entera y pulsando el botón de ‘relacionados’ encuentra las investigaciones relacionadas con esos documentos.

2. Importación Rápida y fácil – Pudiendo añadir documentos recomendados a biblioteca personal “My Library” con un solo clic y si tenemos permiso para hacerlo, se incluirá también el texto completo del artículo.

3. Drill-down en recomendaciones – Cuando encuentras una recomendación que te interesa, selecciona y haz clic en “Documentos relacionados” para ver más sugerencias basadas en ese documento.

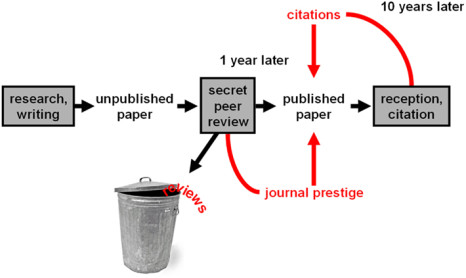

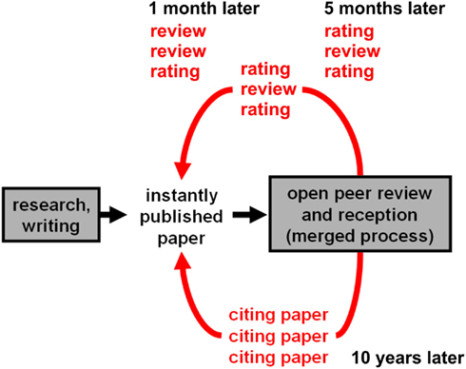

Entre las novedades que quiere incorporar Mendeley en el futuro está la posibilidad de revisión por pares en la plataforma , al igual que hacen Arxiv o PloS, por lo que en un futuro próximo, los revisores podrán anotar documentos y ver los comentarios de los otros revisores directamente en Mendeley, antes de la publicación. De manera que el editor de la revista recibiría todos estos comentarios por correo electrónico y sólo tendrá que enviarlos todos a los autores del artículo.

Otro de los proyectos que quiere incorporar la aplicación es a través de la adquisición por parte de Elsevier de la startup de noticias de seguimiento Newsflo. Su software puede ofrecer a los usuarios Mendeley una manera de seguir el impacto de sus investigaciones a través de la web, y convertirse en una nueva forma de medir el impacto de una investigación (Almétrics). Este tipo de métrica alternativa es uno de los caminos de la ciencia abierta que complementa el sistema de citas de las revistas tradicionales, donde la influencia de una revista por sí solo puede favorecer la carrera de un investigador a través de los índices de impacto.