Langin, Katie «Vendor Offering Citations for Purchase Is Latest Bad Actor in Scholarly Publishing». Science 12 feb. 2024, Accedido 20 de febrero de 2024. https://www.science.org/content/article/vendor-offering-citations-purchase-latest-bad-actor-scholarly-publishing.

Un nuevo estudio resalta que un vendedor que ofrece citas a la venta se suma a la lista de actores problemáticos en la publicación académica. Según la investigación, investigadores sin escrúpulos disponen de múltiples opciones para manipular las métricas de citas.

En 2023, apareció un nuevo perfil de Google Scholar en línea que presentaba a un investigador desconocido. En pocos meses, el científico, un experto en noticias falsas, fue catalogado por la base de datos académica como el 36º investigador más citado en su campo. Tenía un índice h de 19, lo que significa que había publicado 19 artículos académicos que habían sido citados al menos 19 veces cada uno. Fue un impresionante debut en la escena de la publicación académica.

Pero nada de eso era legítimo. El investigador y su institución eran ficticios, creados por investigadores de la Universidad de Nueva York en Abu Dhabi que investigaban prácticas editoriales cuestionables. Las publicaciones fueron escritas por ChatGPT. Y los números de citas eran falsos: algunas provenían de la excesiva auto-cita del autor, mientras que otras 50 fueron compradas por 300$ a un vendedor que ofrecía un «servicio de impulso de citas».

«La capacidad de comprar citas en gran cantidad es un desarrollo nuevo y preocupante», dice Jennifer Byrne, una investigadora de cáncer de la Universidad de Sídney que ha estudiado publicaciones problemáticas en la literatura biomédica. En la universidad, el índice h de un investigador y el número de citas que han recibido a menudo se utilizan para decisiones de contratación y ascenso. Y el perfil fabricado, que fue parte de un estudio publicado como preprint la semana pasada en arXiv, muestra tácticas «extremas» que se pueden emplear para manipularlos, agrega Byrne, quien no estuvo involucrada en el trabajo. (Los investigadores declinaron nombrar al vendedor para evitar darles más negocios).

El estudio comenzó cuando Yasir Zaki, un científico de la computación en la Universidad de Nueva York en Abu Dhabi, y sus colegas notaron patrones preocupantes entre investigadores reales. Después de examinar los perfiles de Google Scholar de más de 1.6 millones de científicos y mirar a autores con al menos 10 publicaciones y 200 citas, el equipo identificó a 1016 científicos que habían experimentado un aumento de 10 veces en las citas en un solo año. «Sabes que algo anda mal cuando un científico experimenta un aumento repentino y masivo en sus citas», dice Zaki.

El equipo señaló a 114 científicos que habían recibido más de 18 citas de un solo artículo, un signo sospechoso, según Zaki, «ya que es raro que incluso los científicos establecidos tengan más de un puñado de citas provenientes de la misma fuente». En un caso particularmente flagrante, el 90% de las referencias en un solo artículo citaban las publicaciones de un científico. «Fue… publicado en una revista de la que el científico sospechoso es editor», dice Zaki.

Muchas de las citas asociadas con los 114 científicos sospechosos provenían de publicaciones de baja calidad, dicen los investigadores, incluidos preprints, que no están sujetos a revisión por pares. Algunas de las publicaciones citantes ni siquiera mencionaban el trabajo del investigador en el texto principal del artículo; la cita simplemente se había añadido a la lista de referencias al final.

El equipo también notó que uno de los autores había recibido muchas citas de documentos alojados por una cuenta en ResearchGate, un sitio de redes sociales para científicos. «Para nuestro asombro, ¡esa cuenta estaba anunciando abiertamente un servicio de compra de citas!», dice el autor del estudio, Talal Rahwan, un científico de informática en la Universidad de Nueva York en Abu Dhabi.

Fue entonces cuando decidieron crear el perfil ficticio de Google Scholar y ver si podían comprar citas ellos mismos. Le pidieron a ChatGPT que escribiera 20 artículos de investigación sobre el tema de las noticias falsas, incluyendo muchas auto-citas, referencias a documentos escritos por el mismo autor ficticio, imitando una práctica que algunos investigadores usan para aumentar sus números de citas.

Luego, publicaron los artículos en varios servidores de preprints. Google Scholar detectó esos artículos en su exploración de la literatura académica y se recogieron en el perfil del autor ficticio, enumerando esos preprints como publicaciones y dándole al investigador crédito por 380 auto-citas contenidas en ellos.

A partir de ahí, fue relativamente fácil comprar citas adicionales. Utilizando el nombre del científico ficticio, el equipo de investigación contactó al vendedor a través de WhatsApp y compró el «paquete de 50 citas». Dentro de 40 días, se publicaron cinco artículos que incluían cada uno 10 citas al trabajo del investigador de noticias falsas ficticio. Cuatro de los cinco aparecieron en una sola revista de química. «Esto no tenía sentido, ya que los documentos de nuestro investigador ficticio no estaban ni remotamente relacionados con la química», señala Rahwan.

El estudio sugiere que algunos investigadores están utilizando tácticas similares a las empleadas por el equipo de la Universidad de Nueva York en Abu Dhabi para aumentar sus clasificaciones de citas. «La evidencia que muestran en este documento es bastante sólida», dice Naoki Masuda, un matemático de la Universidad de Buffalo que ha estudiado citas anómalas.

Los autores no pueden decir cuan extendidos son estos problemas en la literatura académica. «Solo nos enfocamos en los casos escandalosos», dice Rahwan. Pero vieron señales de que otros artículos publicados por la misma revista de química pueden haber incluido citas que fueron compradas: Once otros (reales) científicos habían recibido al menos 10 citas de un solo artículo publicado en esa revista.

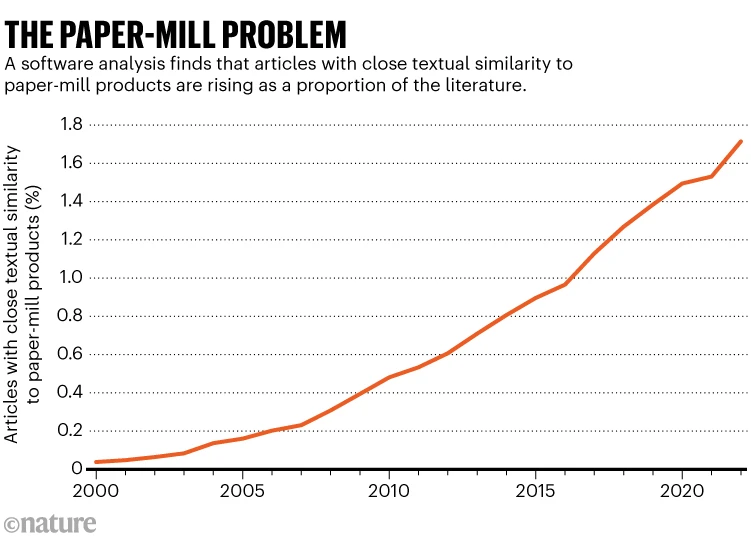

Bernhard Sabel, un neuropsicólogo de la Universidad Otto von Guericke en Magdeburgo que ha estudiado fábricas de papel que venden autoría en artículos científicos, dice que la comunidad académica debería estar «muy preocupada» por este tipo de manipulaciones. «El problema es grande, y ha estado creciendo rápidamente en los últimos 10-15 años», agrega Sabel. En su opinión, Google Scholar y otras bases de datos