Knibbs, Kate. «Anthropic Agrees to Pay Authors at Least $1.5 Billion in AI Copyright Settlement.» WIRED, 5 de septiembre de 2025. https://www.wired.com/story/anthropic-settlement-lawsuit-copyright/

Anthropic, la empresa estadounidense de inteligencia artificial creadora del chatbot Claude, ha acordado pagar 1.500 millones de dólares para resolver una demanda colectiva presentada por autores cuyos libros fueron utilizados sin autorización para entrenar su modelo de IA.

Este acuerdo, aún pendiente de aprobación judicial, constituye el mayor pago por infracción de derechos de autor en la historia de Estados Unidos.

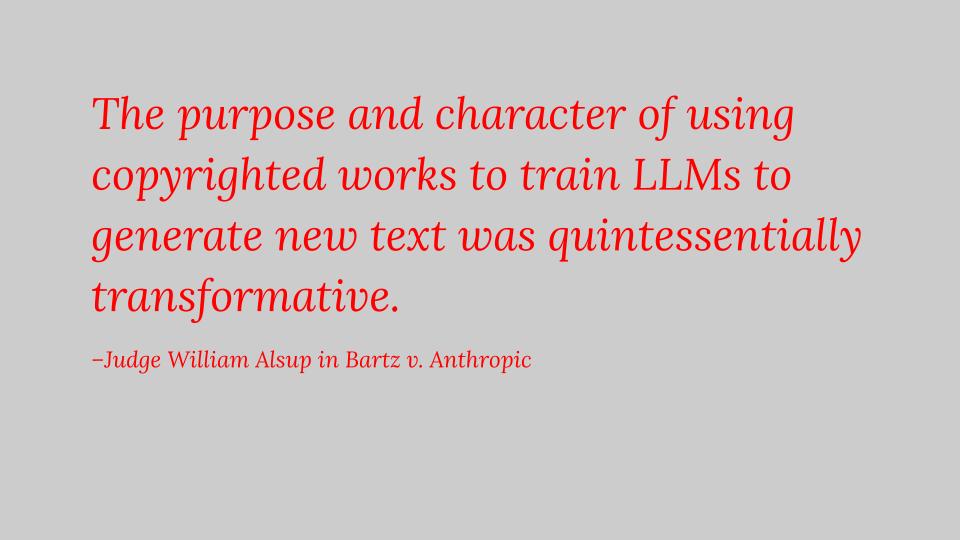

Los demandantes, entre ellos Andrea Bartz, Charles Graeber y Kirk Wallace Johnson, acusaron a Anthropic de descargar millones de libros desde sitios pirata como Library Genesis y Pirate Library Mirror, vulnerando los derechos de autor de los creadores. Aunque la justicia había establecido previamente que usar libros adquiridos legalmente para entrenar inteligencia artificial podía considerarse un uso legítimo, la demanda continuó debido al uso de material obtenido ilegalmente.

El acuerdo estipula que cada autor recibirá aproximadamente 3.000 dólares por obra, cubriendo unas 465.000 obras en total. Anthropic también se comprometió a destruir las copias pirata almacenadas, sin admitir responsabilidad legal. Sin embargo, el juez William Alsup expresó dudas sobre la falta de detalles del acuerdo y solicitó información adicional antes de la audiencia prevista para el 25 de septiembre de 2025.

Este caso es un precedente importante en la regulación del uso de contenido protegido por derechos de autor para entrenar modelos de inteligencia artificial, con implicaciones significativas para otras compañías tecnológicas que desarrollan herramientas de IA.