Microsoft Research ha logrado un avance en tecnología de animación al desarrollar una aplicación de inteligencia artificial que convierte una imagen estática de una persona y una pista de audio en una animación realista con expresiones faciales adecuadas. El sistema, llamado VASA-1, puede transformar imágenes estáticas, como fotografías, dibujos o pinturas, en animaciones «exquisitamente sincronizadas» que imitan el habla humana y el canto.

VASA-1 está entrenado con miles de imágenes con una amplia variedad de expresiones faciales y puede producir imágenes de 512×512 píxeles a 45 cuadros por segundo. Sin embargo, debido al potencial de mal uso, el equipo de investigación actualmente no ha puesto el sistema disponible públicamente. Están dedicados a desarrollar la IA de manera responsable y no tienen planes de lanzar una demostración en línea, API, producto o detalles adicionales hasta estar seguros de que la tecnología se utilizará de manera responsable y de acuerdo con las regulaciones adecuadas.

El modelo principal, VASA-1, es capaz no solo de producir movimientos de labios exquisitamente sincronizados con el audio, sino también de capturar un amplio espectro de matices faciales y movimientos naturales de la cabeza que contribuyen a la percepción de autenticidad y vivacidad. Las innovaciones principales incluyen un modelo holístico de generación de dinámicas faciales y movimientos de cabeza que funciona en un espacio latente facial, y el desarrollo de un espacio latente facial expresivo y disociado utilizando videos. A través de experimentos extensos, incluida la evaluación en un conjunto de nuevas métricas, se demuestra que el método supera significativamente a los métodos anteriores en diversas dimensiones de manera integral. El método no solo ofrece una alta calidad de video con dinámicas faciales y de cabeza realistas, sino que también admite la generación en línea de videos de 512×512 a hasta 40 FPS con una latencia inicial insignificante. Allana el camino para interacciones en tiempo real con avatares realistas que emulan comportamientos conversacionales humanos.

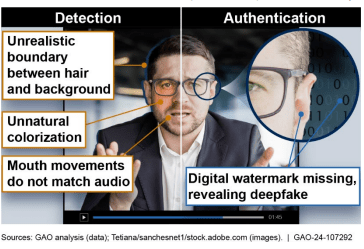

El enfoque de investigación se centra en generar habilidades visuales afectivas para avatares virtuales de IA, con el objetivo de aplicaciones positivas. No pretenden crear contenido que se utilice para engañar o malinterpretar. Sin embargo, como otras técnicas relacionadas de generación de contenido, aún podría ser potencialmente mal utilizado para suplantar a humanos. Se oponen a cualquier comportamiento que cree contenidos engañosos o perjudiciales de personas reales, y están interesados en aplicar la técnica para avanzar en la detección de falsificaciones. Actualmente, los videos generados por este método aún contienen artefactos identificables, y el análisis numérico muestra que aún hay una brecha para lograr la autenticidad de los videos reales.

Aunque reconocen la posibilidad de mal uso, es imperativo reconocer el sustancial potencial positivo de la técnica. Los beneficios, como mejorar la equidad educativa, mejorar la accesibilidad para personas con desafíos de comunicación, ofrecer compañía o apoyo terapéutico a quienes lo necesitan, entre muchos otros, subrayan la importancia de la investigación y otras exploraciones relacionadas. Están dedicados a desarrollar la IA de manera responsable, con el objetivo de avanzar en el bienestar humano.

Dado dicho contexto, no tienen planes de lanzar una demostración en línea, API, producto, detalles de implementación adicionales o cualquier oferta relacionada hasta estar seguros de que la tecnología se utilizará de manera responsable y de acuerdo con las regulaciones adecuadas.