IndiaTimes. «Deepfakes And The Safety Of AI Tools: Ways To Navigate This Murky Landscape», 6 de noviembre de 2023. https://www.indiatimes.com/technology/news/deepfakes-and-the-safety-of-ai-tools-619754.html.

Los deepfakes, medios sintéticos que manipulan vídeos y audio, plantean riesgos significativos, incluida la erosión de la confianza pública y la amenaza a la privacidad. La detección y atribución de deepfakes sigue siendo desafiante, lo que destaca la necesidad de estrategias de seguridad. Se sugieren soluciones como invertir en algoritmos de detección, promover la alfabetización mediática, establecer leyes claras y éticas, y fomentar la colaboración entre empresas, investigadores y responsables políticos para abordar estos desafíos y garantizar el uso responsable de la IA.

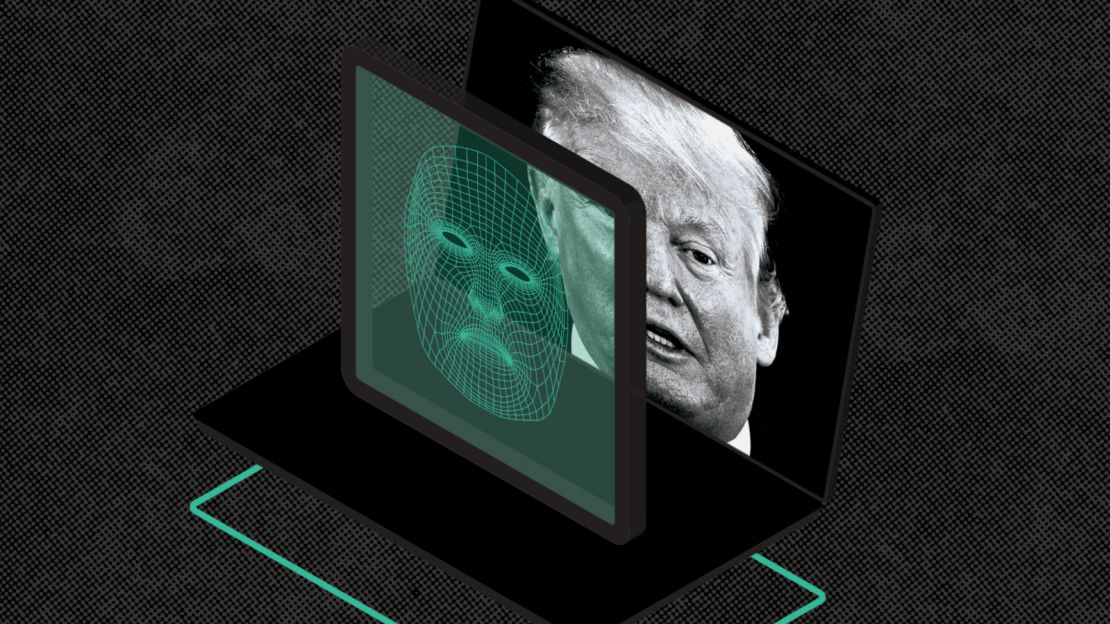

Los deepfakes son medios sintéticos que incluyen vídeos y audio manipulados, sustituyendo la imagen de una persona por otra. A la luz de un reciente vídeo de deepfake en el que participaba la actriz india Rashmika Mandanna, vuelven a surgir demandas de regulación de las herramientas de inteligencia artificial (IA). El vídeo, creado con tecnología deepfake, muestra el rostro de Mandanna superpuesto al cuerpo de otra mujer. Los videos deepfake se crean utilizando algoritmos de inteligencia artificial para manipular y fabricar contenido de apariencia realista, a menudo con intenciones maliciosas. En este caso, el vídeo muestra falsamente a Mandanna entrando a un ascensor con un vestido negro. La tecnología deepfake es cada vez más sofisticada y accesible, lo que pone de relieve los riesgos asociados a su uso indebido. ¿Cuáles son los riesgos de estas herramientas de IA?

Los deepfakes pueden erosionar la confianza en las instituciones y en la información que producen y difunden. Las herramientas de IA pueden crear vídeos y audio que luego pueden ser utilizados por agentes malintencionados para cambiar la percepción pública, difundir información errónea y sembrar la discordia en la sociedad. Los deepfakes pueden utilizarse para dañar reputaciones, incitar a la violencia y montar escándalos políticos.

Amenaza a la privacidad individual

La privacidad y la reputación de las personas se enfrentan a un riesgo significativo por culpa de los deepfakes. La capacidad de generar medios sintéticos realistas puede utilizarse para producir pornografía no consentida, profundizar los casos de ciberacoso y dañar la posición personal o profesional de una persona. En estos casos, las víctimas de deepfakes pueden sufrir angustia emocional, aislamiento social e incluso pérdidas económicas.

Modificación de la opinión pública

Los deepfakes pueden utilizarse para manipular la opinión pública sobre una persona o un partido político, con la posibilidad de interferir en las elecciones. Estas herramientas pueden ser utilizadas por actores malintencionados para crear vídeos de figuras políticas haciendo declaraciones falsas o incurriendo en comportamientos poco éticos con el fin de influir en el sentimiento de los votantes. Debido a ello, la confianza en las instituciones públicas y el alcance de la democracia pueden verse socavados.

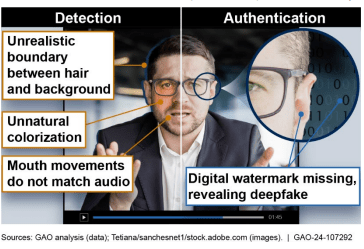

Dificultades para identificar los deepfakes

Aunque hay algunos signos reveladores, como el movimiento distorsionado, los deepfakes siguen siendo en gran medida difíciles de detectar, al menos a primera vista. Además, también son difíciles de atribuir. Con los continuos avances en este tipo de tecnología, será aún más difícil distinguir entre medios auténticos y manipulados, lo que facilitará que los deepfakes se propaguen sin reparos.

Estrategias para garantizar la seguridad

A la luz de las preocupaciones que rodean a estas falsificaciones, es imperativo desarrollar estrategias para prevenir su uso indebido. ¿Cuáles son las posibles soluciones contra el uso indebido de deepfakes?

- Invertir en algoritmos de detección que puedan ayudar a identificar deepfakes inmediatamente. Con los avances en el aprendizaje automático y la inteligencia artificial, estos deepfakes pueden ser más fáciles de identificar.

- Es esencial promover la alfabetización mediática capacitando a las personas para evaluar la información que consumen. Para que esto funcione, es necesario educar a las personas sobre la existencia y los peligros de los deepfakes.

- Es necesario desarrollar leyes y normativas claras para abordar el uso indebido de los deepfakes y proteger a las personas de cualquier daño. Esto significa definir límites legales para la creación y distribución de medios sintéticos, establecer sanciones por uso indebido y proporcionar recursos a las víctimas.

- Las empresas tecnológicas, los investigadores y los responsables políticos deben trabajar juntos para hacer frente a los retos que plantean los deepfakes. Además, es esencial promover directrices éticas para el consumo de medios sintéticos.

Como la tecnología de IA sigue evolucionando a este ritmo, es imperativo establecer medidas contra el uso indebido de deepfakes. Mediante la aplicación de mecanismos de detección eficaces, la promoción de la alfabetización mediática, el establecimiento de marcos jurídicos claros y el fomento de prácticas éticas de desarrollo de la IA, podemos mitigar los efectos negativos de los deepfakes y salvaguardar el uso responsable de las herramientas de IA. Para saber más sobre el mundo de la tecnología y la ciencia, sigue leyendo Indiatimes.com y haz clic aquí para consultar nuestras guías prácticas.