Resolución de 9 de diciembre de 2024, de la Comisión Nacional Evaluadora

de la Actividad Investigadora, por la que se publican los criterios para la

evaluación de la actividad investigadora.

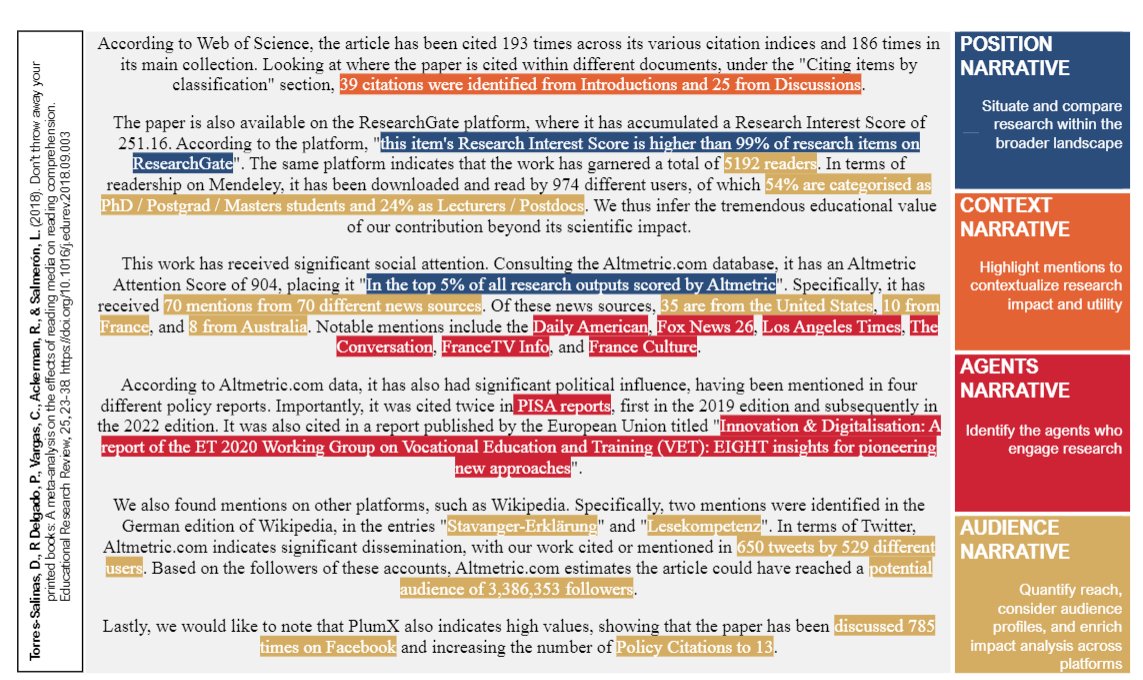

La Comisión Nacional Evaluadora de la Actividad Investigadora (CNEAI) ha aprobado los criterios para la evaluación de la actividad investigadora correspondientes a la convocatoria de 2024. Estos criterios, que serán publicados en el Boletín Oficial del Estado (BOE), ya se han difundido para facilitar la preparación anticipada de las solicitudes. Finalmente, para garantizar transparencia y uniformidad, ANECA ha publicado un baremo único que será aplicado por los quince Comités Asesores.

Entre los cambios destacados, se elimina el apartado de «mínimos orientativos», permitiendo la obtención de una evaluación positiva mediante cinco aportaciones que cumplan con los criterios generales, sin depender de indicadores cuantitativos relacionados con medios de difusión. Esto refuerza el enfoque en la calidad intrínseca de las aportaciones.

El baremo para la evaluación de la actividad investigadora en la convocatoria de 2024 de los sexenios de investigación establece criterios clave para calificar las aportaciones de los solicitantes, otorgando mayor peso al impacto científico y contemplando elementos relacionados con la originalidad, la relevancia social y la promoción de la ciencia abierta. A continuación, se resumen los principales aspectos de cada criterio:

Contribución al progreso del conocimiento (10%)

Este apartado evalúa la originalidad, innovación y pertinencia de la investigación, destacando la capacidad del trabajo para abordar problemas relevantes en el área y proponer soluciones novedosas. Se valora también el enfoque metodológico, incluyendo el desarrollo de nuevos métodos o la mejora de los existentes. Se excluyen trabajos meramente descriptivos, recopilaciones bibliográficas sin análisis crítico o traducciones sin aportaciones significativas.

Impacto científico (60%)

Es el criterio más relevante, dividido en cuatro subcategorías principales:

- Uso de la aportación: Se mide por lecturas, descargas y visualizaciones en plataformas académicas.

- Citas recibidas: Considera el número y calidad de las citas recibidas, excluyendo autocitas.

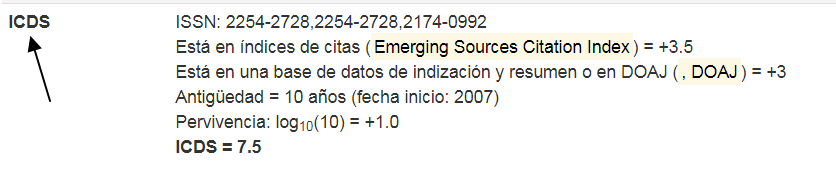

- Calidad del medio de difusión: Se analiza la reputación del medio donde se publica, incluyendo revisiones por pares y estándares de calidad.

- Impacto del medio: Examina el reconocimiento científico del medio de publicación, con énfasis en premios, críticas y reseñas.

Se tienen en cuenta otros indicadores como vínculos con proyectos de investigación, tesis doctorales, premios y menciones en medios especializados.

Impacto social (10%)

Evalúa la repercusión de las investigaciones fuera del ámbito académico, como su influencia en políticas públicas, documentos normativos, guías clínicas o la industria. Además, se considera su difusión en medios de comunicación, plataformas digitales y eventos culturales, y la interacción con el público.

Contribución a la ciencia abierta (10%)

Se premian aportaciones accesibles públicamente, ya sea en versiones finales o preliminares, y el cumplimiento de principios FAIR en datasets y software. También se valora la publicación en revistas de acceso abierto (diamante) y el uso de licencias libres como Creative Commons.

Aportación preferente (10%)

Se analiza el ajuste de las aportaciones al tipo preferente definido en los criterios de evaluación, como artículos, libros, capítulos de libro, patentes o contribuciones a congresos.

Circunstancias reductoras

La puntuación puede reducirse en casos como:

- Reiteración de publicaciones: Más de tres aportaciones en un mismo medio sin justificación suficiente.

- Conflicto de interés editorial: Relaciones que comprometan la objetividad del proceso editorial.

- Malas prácticas: Plagio, duplicación de contenido, alteración de datos o artículos retractados.

- Procesos de revisión cuestionables: Medios con estándares poco fiables o periodos de aceptación injustificadamente cortos.

- Autoría insuficientemente justificada: Participación no justificada adecuadamente en casos de coautoría múltiple.

Este baremo asegura una evaluación integral y motivada de las contribuciones, exigiendo evidencia clara de su relevancia científica, metodológica y social, y fomentando la transparencia en la producción académica.