Westreich, Sam. «Why ChatGPT Creates Scientific Citations — That Don’t Exist.» Age of Awareness, June 4, 2025. https://medium.com/age-of-awareness/why-chatgpt-creates-scientific-citations-that-dont-exist-8978ec973255

Se aborda un fenómeno cada vez más observado en la inteligencia artificial generativa: la creación de referencias bibliográficas falsas o inventadas. Este problema, conocido en la comunidad de IA como “hallucination” (alucinación), consiste en que los modelos de lenguaje como ChatGPT generan respuestas plausibles y estructuradas, pero que no se corresponden con datos reales verificables.

En el caso de las citas científicas, el modelo construye referencias completas que incluyen autores, títulos, años y revistas, pero que no existen en ninguna base de datos académica. Esto ocurre porque la IA no accede directamente a una base de datos específica al generar la respuesta, sino que se basa en patrones probabilísticos aprendidos durante su entrenamiento en grandes corpus textuales.

El fenómeno de la hallucination en modelos de lenguaje ha sido documentado por varios estudios recientes. Por ejemplo, Ji et al. (2023) en su trabajo “Survey of Hallucination in Natural Language Generation” indican que esta tendencia a inventar hechos o detalles es inherente a la forma en que estos modelos predicen palabras en secuencia para maximizar la coherencia textual, pero sin una “conciencia” o acceso en tiempo real a datos verdaderos (Ji et al., 2023, ACM Computing Surveys). Así, el modelo genera lo que “suena correcto” más que lo que es correcto, produciendo con frecuencia referencias falsas, especialmente cuando se le solicita citar fuentes académicas.

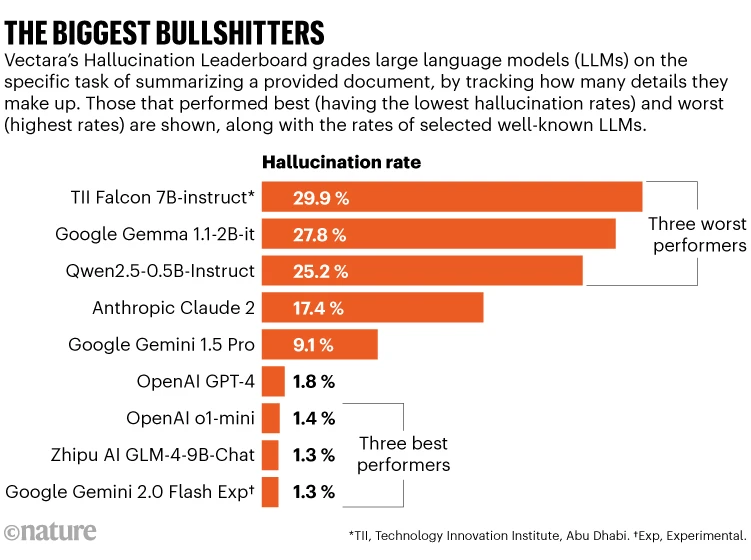

El problema de las citas inventadas tiene graves implicaciones en ámbitos científicos y académicos, donde la veracidad y la confiabilidad de las referencias es fundamental para la integridad del conocimiento. Según un artículo publicado en Nature sobre la creciente adopción de IA en la generación de textos académicos, existe preocupación entre investigadores sobre el potencial de estas herramientas para introducir errores difíciles de detectar, que pueden desinformar a estudiantes y profesionales (Nature Editorial, 2024). La confianza que los usuarios depositan en estas IA aumenta el riesgo, dado que una cita bien formada visualmente se asume auténtica, lo que puede propagar información errónea y socavar la credibilidad de trabajos científicos.

Westreich señala que la raíz del problema está en la naturaleza probabilística del entrenamiento del modelo, que aprende a generar texto basado en patrones estadísticos en lugar de verificar hechos. Además, las bases de datos académicas tienen un acceso limitado y no siempre están integradas en los sistemas de generación de lenguaje, lo que impide la validación automática de las citas en tiempo real. Sin embargo, se están explorando soluciones para mitigar este problema. Por ejemplo, la integración de sistemas de búsqueda y recuperación de información en tiempo real (RAG, Retrieval-Augmented Generation) permitiría a los modelos consultar bases de datos académicas fiables durante la generación de texto, reduciendo la producción de referencias falsas (Lewis et al., 2020, NeurIPS).

Otra estrategia recomendada es aumentar la transparencia del modelo, avisando a los usuarios de que las referencias generadas pueden no ser reales y deben ser verificadas independientemente. Instituciones educativas y editoriales también pueden establecer guías para el uso responsable de estas herramientas, fomentando la revisión manual de las citas generadas por IA.

En un análisis crítico más amplio, la producción de citas falsas por IA pone en evidencia la brecha entre la fluidez lingüística y la comprensión real del contenido que tienen estos modelos. Aunque pueden imitar estructuras y formatos, carecen de un sistema de verificación interna que asegure la veracidad. Por ello, investigadores como Bender et al. (2021) advierten que el uso indiscriminado de estas tecnologías sin supervisión puede erosionar la confianza en la información científica y educativa, un problema que debe abordarse con estrategias técnicas, educativas y éticas.

La comunidad científica y tecnológica trabaja para desarrollar métodos que permitan una generación de contenido más responsable, precisa y verificable. Mientras tanto, es imprescindible que los usuarios mantengan un enfoque crítico y verifiquen cualquier referencia proporcionada por estas herramientas, para preservar la integridad académica y evitar la propagación de desinformación.