Marques, F. (2025, marzo). Use of fake email addresses leads to retraction of 45 articles by Brazilian scientists. Revista Pesquisa FAPESP. Recuperado de https://revistapesquisa.fapesp.br/en/use-of-fake-email-addresses-leads-to-retraction-of-45-articles-by-brazilian-scientists/

Se relata un caso significativo de problemas de integridad académica que llevó a la retracción de 45 artículos científicos firmados por un mismo investigador brasileño, el biólogo Guilherme Malafaia Pinto, del Instituto Federal Goiano (IF-Goiano), campus de Urutaí.

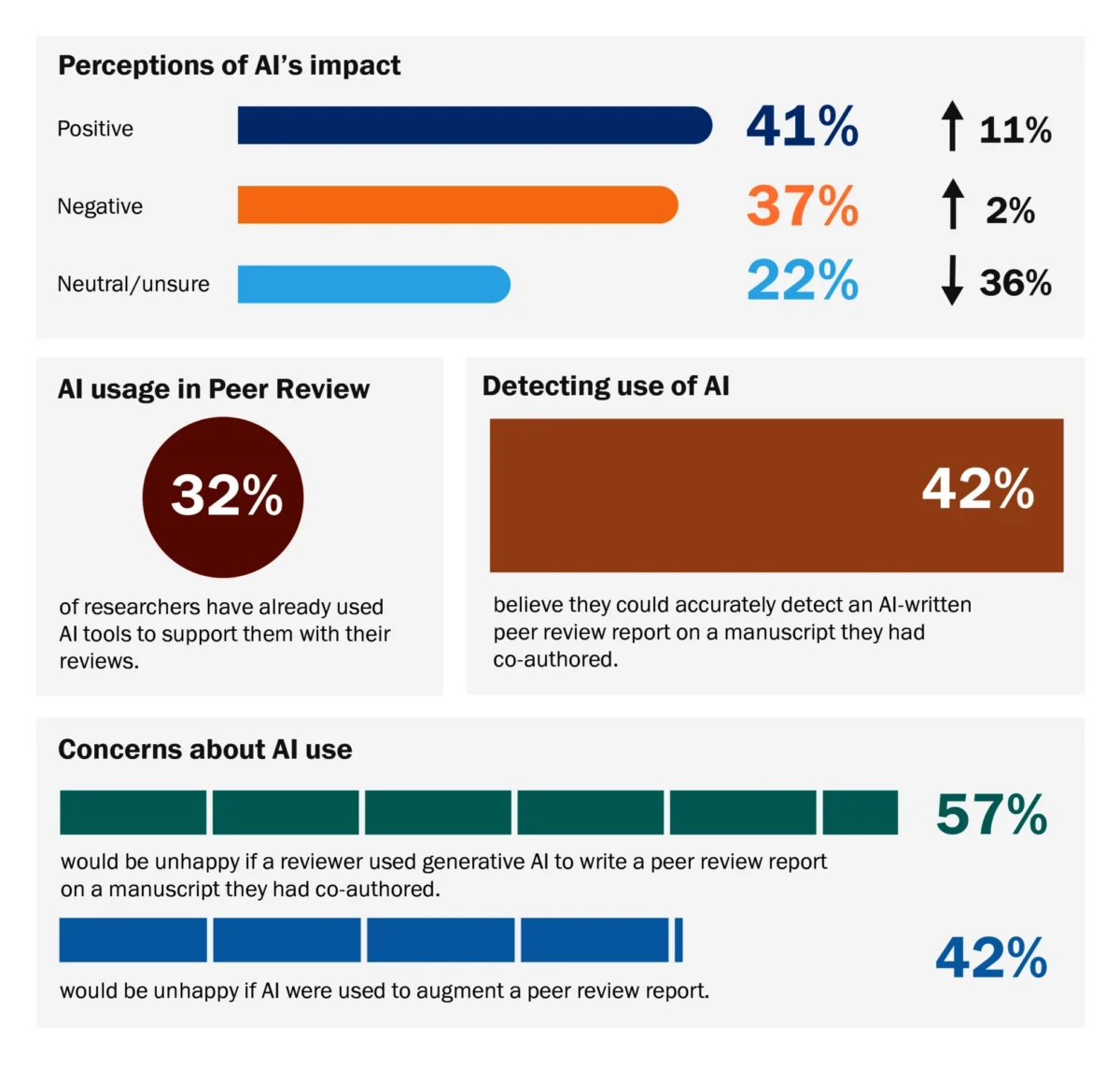

Los 45 trabajos fueron publicados en la revista Science of the Total Environment (STOTEN), editada por Elsevier, y su retirada no obedeció a errores experimentales o conclusiones erróneas, sino al compromiso del proceso de revisión por pares. Las notas de retracción señalaron que el sistema de evaluación había sido adulterado porque, aunque Malafaia sugería a revisores legítimos para sus manuscritos —práctica habitual en muchos procesos editoriales—, proporcionó direcciones de correo electrónico falsas para al menos tres de esos investigadores, de modo que las invitaciones de STOTEN llegaban a cuentas ficticias desde las cuales se devolvían opiniones favorables a la publicación. Como resultado, a pesar de que algunos artículos también recibieron evaluaciones de revisores independientes, Elsevier decidió retirar los trabajos al haber “perdido confianza en la validez o integridad” de los manuscritos.

La publicación también explora el contexto y las consecuencias del caso, tanto para el propio investigador como para la comunidad académica. Antes de este escándalo, Malafaia era un científico muy productivo, con casi 350 artículos publicados en una carrera de 15 años, supervisión de numerosos estudiantes de maestría y doctorado, y participación en comités editoriales de varias publicaciones, incluida STOTEN. Él niega haber manipulado deliberadamente la revisión de sus artículos, afirmando que usó direcciones de una base de datos china (CNKI) sin saber que eran falsas y que no tuvo participación directa en la redacción de los supuestos informes de revisión. En una carta abierta, argumentó que el problema fundamental era responsabilidad de los editores por no verificar los correos, y sugirió que sanciones menos drásticas que la retracción hubieran sido más apropiadas. Sin embargo, la situación ha tenido un impacto profundo en su reputación y la de sus colaboradores, muchos de los cuales ahora enfrentan cuestionamientos y el dilema de defender o distanciarse de los trabajos retractados; a la vez, la comunidad académica brasileña reflexiona sobre la importancia de fortalecer la ética y los sistemas de revisión para preservar la confianza en la ciencia.