Amodei, Dario. “The Urgency of Interpretability.” Dario Amodei (blog). 21 de mayo de 2024. https://www.darioamodei.com/post/the-urgency-of-interpretability

El ensayo “La urgencia de la interpretabilidad” de Dario Amodei, CEO de Anthropic, es una llamada de atención sobre la necesidad crítica y urgente de comprender el funcionamiento interno de los sistemas de inteligencia artificial (IA) avanzados. A medida que estos modelos, especialmente los generativos como los grandes modelos de lenguaje (LLM), se vuelven más poderosos y autónomos, su opacidad representa un riesgo significativo para la seguridad, la gobernanza y la alineación con los valores humanos.

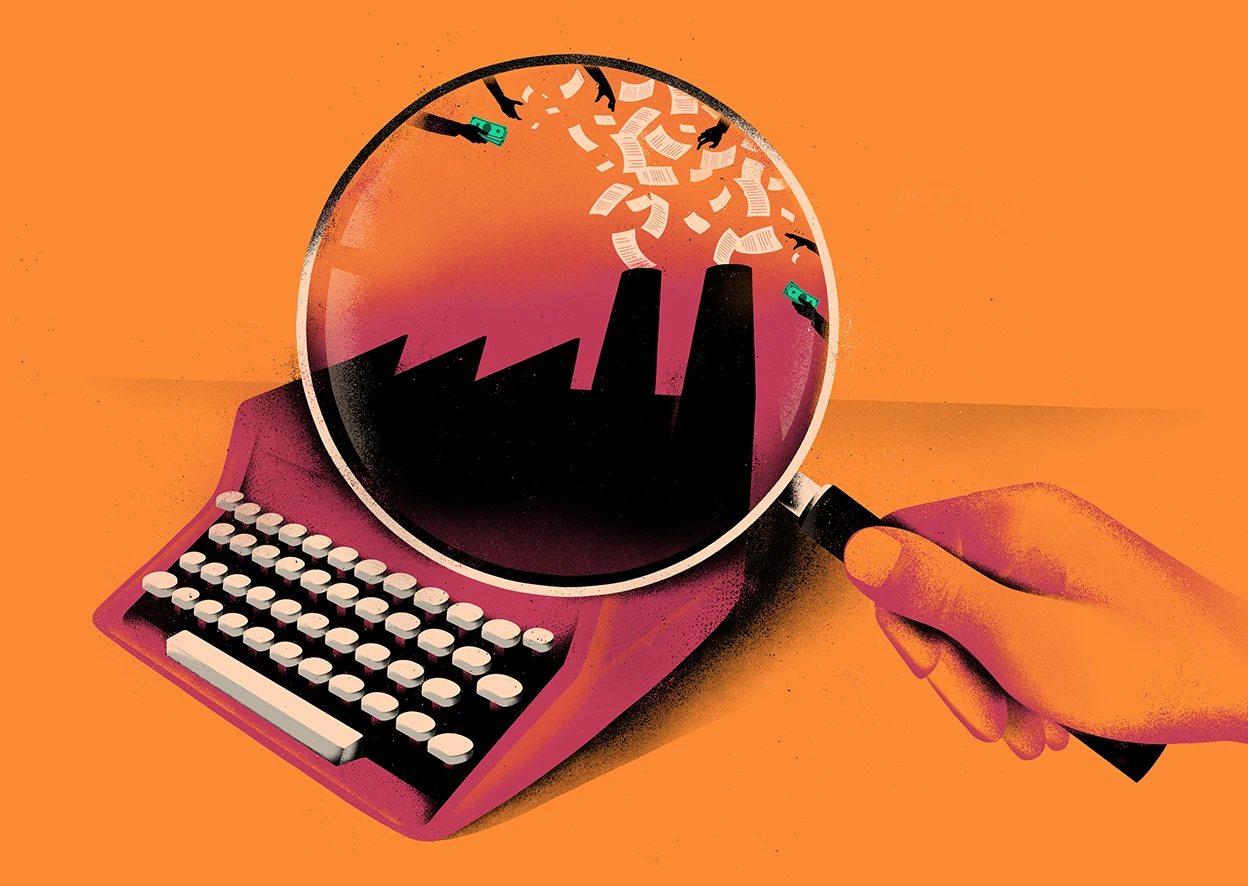

En su texto, Amodei parte de una preocupación central: los sistemas de inteligencia artificial, especialmente los grandes modelos de lenguaje como Claude (de Anthropic) o GPT (de OpenAI), están creciendo a un ritmo acelerado en capacidad y sofisticación, pero no así en transparencia. Esto significa que, aunque estos modelos pueden generar textos altamente coherentes, resolver tareas complejas o incluso programar código, no sabemos realmente cómo lo hacen. Sus «razonamientos», sus objetivos internos y sus procesos de toma de decisiones permanecen en gran parte ocultos incluso para sus propios creadores. Esta característica —la opacidad estructural de las redes neuronales profundas— convierte a estos sistemas en cajas negras: modelos altamente potentes que no podemos auditar, ni predecir completamente.

«Las personas ajenas al sector suelen sorprenderse y alarmarse al descubrir que no comprendemos cómo funcionan nuestras propias creaciones de IA. Y tienen razón en estar preocupados: esta falta de comprensión no tiene precedentes en la historia de la tecnología»

La falta de interpretabilidad no es simplemente una limitación técnica, sino un riesgo existencial. En la medida en que confiamos cada vez más en estas IA para realizar funciones críticas (desde atención médica hasta procesos financieros, desde generación de conocimiento hasta decisiones de seguridad), no poder explicar su funcionamiento significa que tampoco podemos anticipar ni prevenir fallos. La IA podría comportarse de forma no alineada con los valores humanos, y al carecer de herramientas para “leer su mente”, esos errores podrían pasar inadvertidos hasta que sea demasiado tarde.

«No podemos detener el autobús, pero podemos dirigirlo«

Amodei sostiene que una IA verdaderamente alineada no basta con estar bien entrenada o con tener filtros de seguridad externos. Debemos ser capaces de abrir sus “circuitos internos” y comprender cómo ha llegado a una conclusión determinada, qué objetivos está persiguiendo y si está desarrollando estrategias emergentes, como el engaño o la manipulación. La interpretación, por tanto, no es un lujo ni un ideal ético: es una condición esencial para el control, la supervisión y la gobernanza efectiva de estos sistemas. Para lograrlo, la investigación debe centrarse en métodos que permitan mapear las conexiones neuronales, desentrañar sus representaciones internas y ofrecer explicaciones comprensibles para humanos sobre el “por qué” de cada decisión.

«Los sistemas de IA generativa modernos son opacos de una manera que difiere fundamentalmente del software tradicional. Si un programa de software ordinario hace algo (por ejemplo, un personaje en un videojuego dice una línea de diálogo o mi aplicación de entrega de comida me permite dar propina a mi conductor), hace esas cosas porque un humano las programó específicamente. La IA generativa no es así en absoluto . Cuando un sistema de IA generativa hace algo, como resumir un documento financiero, no tenemos idea, a un nivel específico o preciso, de por qué toma las decisiones que toma (por qué elige ciertas palabras sobre otras o por qué ocasionalmente comete un error a pesar de que generalmente es preciso)»

A modo de analogía, Amodei compara esta necesidad con los avances en medicina que nos permitieron visualizar el interior del cuerpo humano —por ejemplo, con resonancias magnéticas—. Sin esas herramientas, nuestros diagnósticos serían a ciegas. Algo similar ocurre con la IA: necesitamos instrumentos que nos permitan visualizar qué ocurre en las capas profundas del modelo, en sus pesos y patrones internos. Esa “resonancia magnética” de las redes neuronales es lo que está en juego con la interpretabilidad.

Uno de los aspectos más inquietantes del ensayo es el reconocimiento de que, actualmente, las capacidades de la IA avanzan más rápido que nuestra comprensión de ellas. Ya estamos desarrollando modelos capaces de comportamientos complejos, y sin embargo apenas comenzamos a entender su arquitectura interna. Esta brecha entre poder y entendimiento, según Amodei, es peligrosa: es como construir reactores nucleares sin comprender del todo la física que los gobierna. En algunos casos, la IA ha demostrado “comportamientos emergentes”, es decir, habilidades que no fueron programadas ni anticipadas por sus diseñadores. Estas capacidades surgen de la interacción entre millones de parámetros y datos de entrenamiento, y pueden incluir razonamientos complejos, generación de código, toma de decisiones estratégicas e incluso formas incipientes de “metacognición”. Si no podemos explicar cómo surgen estos comportamientos, tampoco podremos saber si en algún momento serán perjudiciales o si conducirán a formas de autonomía fuera de nuestro control.

Otro eje central del texto es el vínculo entre interpretabilidad y seguridad. Muchos investigadores en el campo de la inteligencia artificial alineada (AI alignment) consideran que el mayor desafío de largo plazo es evitar que una IA avanzada desarrolle objetivos propios que entren en conflicto con los intereses humanos. Pero sin interpretabilidad, no podemos saber si eso ya está ocurriendo. ¿Cómo detectar si una IA ha aprendido a mentir? ¿O si está desarrollando objetivos intermedios no explícitos, como obtener más acceso a recursos computacionales o evitar ser apagada? Estas preguntas no pueden responderse solo observando la salida del modelo (sus respuestas). Se requiere una forma de entender lo que está ocurriendo dentro del sistema, a nivel estructural.

Además, la interpretabilidad no solo es importante para evitar riesgos catastróficos. También lo es para la ética, la transparencia y la responsabilidad. Si una IA toma decisiones que afectan a personas (por ejemplo, en el sistema judicial, en seguros médicos o en procesos de contratación), es imprescindible poder justificar esas decisiones. Sin interpretabilidad, las decisiones de la IA serían arbitrarias y opacas, y socavarían los principios básicos de la justicia y la rendición de cuentas.

En las secciones finales del ensayo, Amodei lanza una advertencia clara: si no invertimos masivamente en investigación sobre interpretabilidad ahora, podemos perder una ventana crítica para controlar y entender la IA antes de que se vuelva demasiado poderosa. Y lo más preocupante, señala, es que esta investigación todavía está infravalorada dentro del campo de la IA, donde la mayor parte de los recursos se destinan a construir modelos cada vez más grandes y potentes, en lugar de desarrollar herramientas para comprenderlos mejor. El autor aboga por un esfuerzo concertado entre laboratorios de investigación, universidades, gobiernos y entidades reguladoras para que la interpretabilidad sea una prioridad al mismo nivel que el rendimiento o la eficiencia computacional.