Aczel, Balazs, Ann-Sophie Barwich, Amanda B. Diekman, y John P. A. Ioannidis. 2025. «The Present and Future of Peer Review: Ideas, Interventions, and Evidence.» Proceedings of the National Academy of Sciences 122 (5): e2401232121. https://doi.org/10.1073/pnas.2401232121

El sistema de revisión por pares enfrenta críticas por su falta de transparencia, sesgos e ineficiencia, poniendo en duda su sostenibilidad y utilidad. Este artículo analiza modelos alternativos y posibles mejoras para promover un debate amplio entre la comunidad científica. Los autores coinciden en que se necesita más evidencia rigurosa para implementar cambios justos y efectivos.

El sistema de revisión por pares (peer review) es uno de los pilares fundamentales de la ciencia moderna, pero actualmente se encuentra en el centro de un intenso debate sobre su eficacia, sostenibilidad y futuro. Este artículo ofrece una revisión crítica y panorámica sobre el estado actual de la revisión por pares, sus problemas más destacados, posibles soluciones y alternativas emergentes, buscando promover un diálogo constructivo entre los actores clave del ecosistema académico, incluyendo investigadores, editores, revisores, instituciones y financiadores.

Problemas identificados en la revisión por pares

Los autores enumeran una serie de deficiencias que afectan al sistema actual:

- Sesgos e inequidades: La revisión por pares puede estar influenciada por prejuicios conscientes e inconscientes relacionados con la identidad del autor (género, afiliación institucional, país de origen), lo que genera desigualdades sistemáticas en la evaluación.

- Opacidad: Muchos procesos de revisión siguen siendo confidenciales, lo que limita la transparencia y la rendición de cuentas, tanto de los revisores como de los editores.

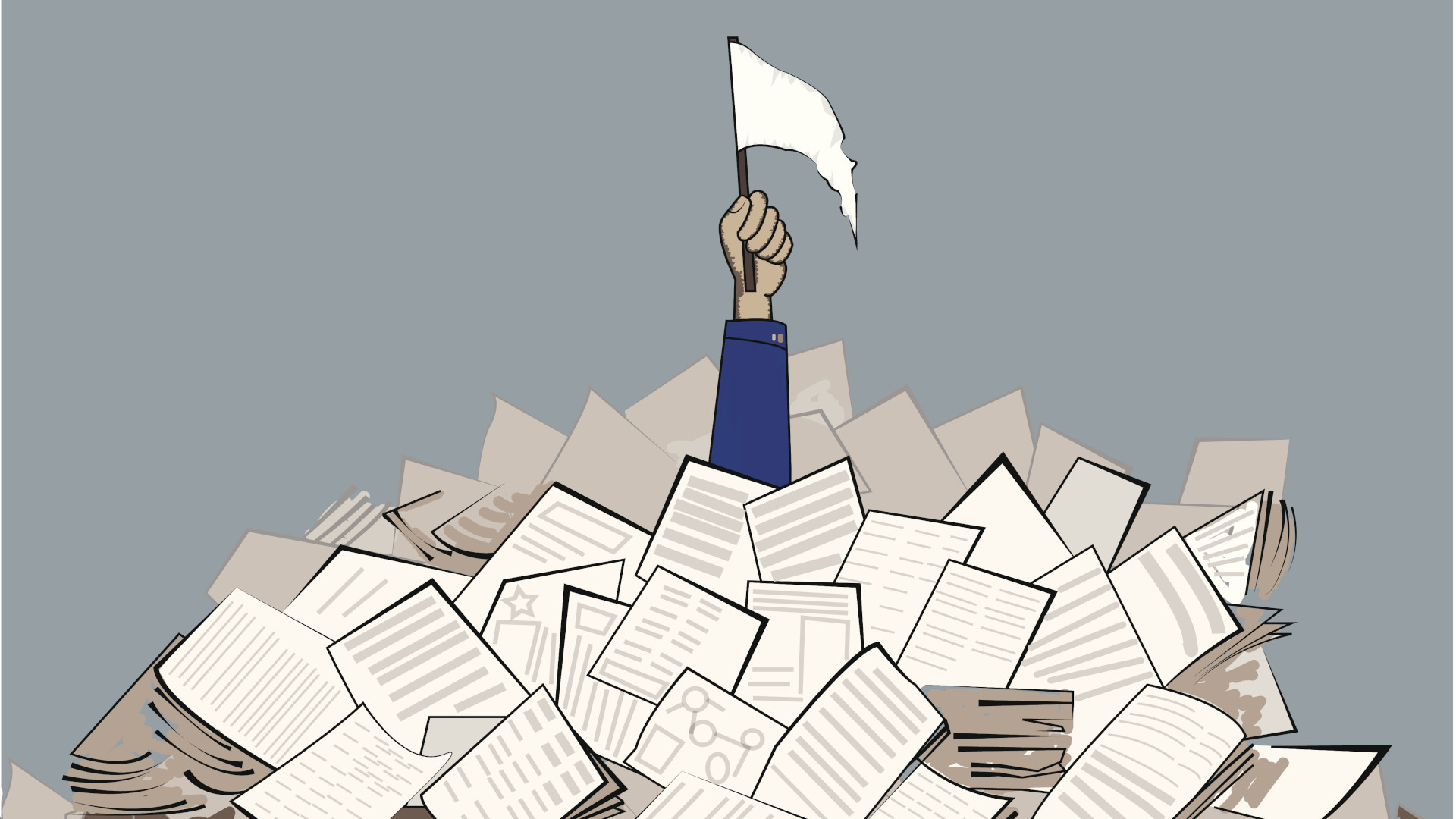

- Sobrecarga de trabajo: La creciente cantidad de publicaciones y manuscritos ha generado una sobrecarga en los revisores, quienes muchas veces asumen esta labor sin compensación adecuada, lo que afecta la calidad de las evaluaciones.

- Retrasos y lentitud: El proceso puede ser extremadamente largo, obstaculizando la rápida difusión del conocimiento, especialmente en áreas donde la inmediatez es crucial, como la salud pública.

- Dudas sobre la eficacia: Aunque el peer review busca garantizar la calidad, la reproducibilidad y la validez de los resultados científicos, existen estudios que ponen en duda su capacidad real para detectar errores, fraudes o investigaciones irrelevantes.

¿Es sostenible y útil el sistema?

El artículo señala que la revisión por pares, aunque imperfecta, sigue siendo el mejor método del que dispone actualmente la ciencia para evaluar la validez de los trabajos antes de su publicación. Sin embargo, su sostenibilidad está en entredicho debido a la sobrecarga de trabajo y a la creciente insatisfacción de autores y revisores.

Los autores subrayan que, aunque no existe un consenso claro sobre su eficacia absoluta, desmantelar el sistema sin contar con alternativas robustas podría ser arriesgado. La revisión por pares cumple funciones sociales (legitimación del conocimiento) y prácticas (control de calidad), pero necesita adaptarse y evolucionar.

Alternativas y posibles mejoras

El texto revisa distintas propuestas e intervenciones que podrían reformar o complementar el sistema actual:

- Revisión abierta (Open Peer Review): Hace públicos los nombres de los revisores y/o los informes de revisión. Aporta transparencia, aunque puede generar presiones y autocensura.

- Preprints y revisión post-publicación: Permiten la difusión inmediata del trabajo y que la comunidad científica en general realice comentarios y críticas posteriores.

- Incentivos para revisores: Desde reconocimientos públicos hasta compensaciones económicas o acreditaciones profesionales, se discuten mecanismos para valorar el trabajo de revisión.

- Uso de inteligencia artificial: Para asistir en tareas preliminares como la detección de plagio, verificación de datos o evaluación del rigor metodológico.

- Diversidad e inclusión: Fomentar la participación de revisores de diversas geografías, géneros y trayectorias, mitigando sesgos históricos.

- Capacitación formal: Desarrollar programas de formación para revisores, asegurando criterios de evaluación más homogéneos y profesionales.

- Evaluación de revisores: Incorporar sistemas de retroalimentación sobre la calidad de las revisiones realizadas.

Evidencias e investigación sobre peer review

Uno de los puntos clave del artículo es la falta de datos sólidos sobre el funcionamiento y los efectos reales de la revisión por pares. Los autores reclaman más estudios empíricos y comparativos que analicen:

- La eficacia real del sistema en mejorar la calidad de los artículos.

- El impacto de los distintos modelos alternativos.

- Los factores que generan sesgos o inequidades.

- Las experiencias de los diferentes actores involucrados.

Sin una base de evidencia más rigurosa y exhaustiva, sostienen los autores, cualquier reforma corre el riesgo de ser insuficiente o contraproducente.

Conclusiones

El artículo no pretende ofrecer una lista exhaustiva de problemas ni soluciones definitivas, sino abrir un espacio para la reflexión colectiva sobre cómo mejorar el sistema de revisión por pares en un contexto de cambios acelerados en la producción y comunicación del conocimiento científico.

Los autores coinciden en que garantizar evaluaciones justas, eficientes y sostenibles requiere no solo intervenciones concretas, sino también una mayor comprensión de cómo funciona realmente el sistema, sus puntos críticos y las mejores formas de transformarlo.

En definitiva, el futuro de la revisión por pares dependerá de un equilibrio entre innovación y prudencia, combinando la experiencia acumulada con nuevas prácticas que refuercen la confianza, la calidad y la equidad en la ciencia global.