Hanson, Mark A., Pablo Gómez Barreiro, Paolo Crosetto, y Dan Brockington. 2024. “The Strain on Scientific Publishing.” Quantitative Science Studies 5 (4): 823–843. https://doi.org/10.1162/qss_a_00327

El artículo analiza la presión creciente que sufre la publicación científica como consecuencia del aumento acelerado del número de artículos que se publican cada año. Aunque la producción de conocimiento científico se ha expandido de forma notable, el número de investigadores capaces de leer, evaluar y revisar ese volumen de trabajos no ha crecido al mismo ritmo, lo que genera una sobrecarga estructural en todo el sistema editorial académico.

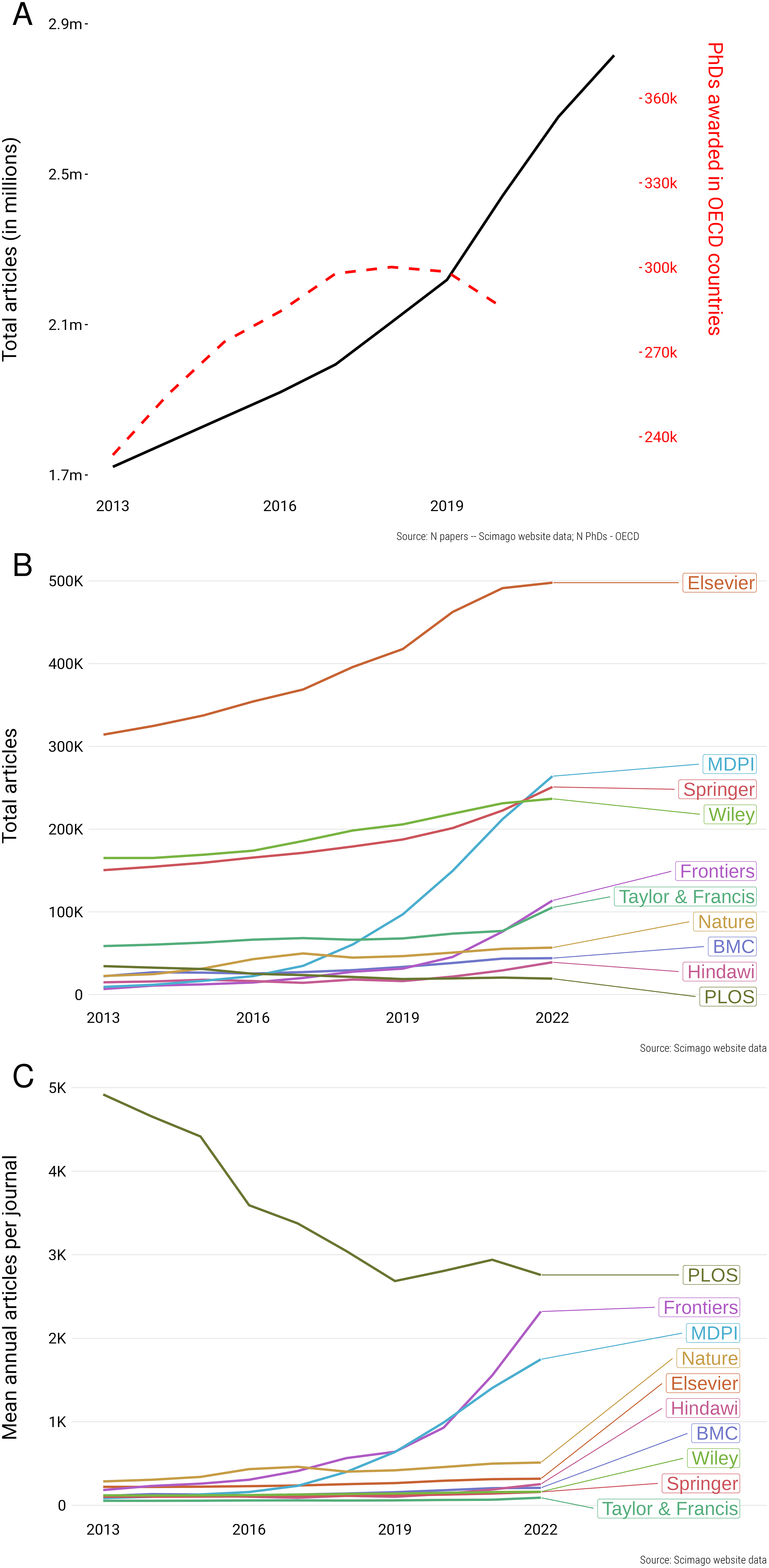

Los autores muestran que, en la última década, las bases de datos científicas han registrado un incremento muy significativo del número de artículos indexados. Este crecimiento ha intensificado las exigencias para los investigadores, que no solo deben producir más publicaciones, sino también dedicar una cantidad cada vez mayor de tiempo a tareas como la lectura y la revisión por pares. Como resultado, el sistema de “publicar o perecer” se vuelve más exigente y menos sostenible. Así, el número de artículos indexados en bases como Scopus y Web of Science se ha incrementado de forma exponencial en los últimos años, con un aumento de alrededor del 47 % entre 2016 y 2022.

Mientras que las grandes editoriales tradicionales (como Elsevier o Springer) han aumentado su producción de manera moderada, otras —especialmente aquellas que dependen de modelos de acceso abierto con cargos por procesamiento de artículos (APC) como MDPI y Frontiers— han visto incrementos marcados en artículos por revista y en la proporción de publicaciones a través de special issues o números especiales. Esto sugiere que las estrategias editoriales específicas pueden estar impulsando parte de la expansión de contenidos.

El trabajo propone una serie de métricas para analizar esta tensión, entre ellas el aumento del volumen total de artículos, el uso creciente de números especiales, los tiempos de evaluación editorial, las tasas de rechazo y la evolución de las métricas de impacto. Estas medidas permiten observar cómo las prácticas editoriales han cambiado y cómo algunas estrategias contribuyen a acelerar la publicación sin que ello garantice una mejora en la calidad científica.

Uno de los hallazgos más relevantes es que ciertos modelos editoriales, especialmente aquellos basados en el acceso abierto financiado mediante cargos por publicación, han impulsado un crecimiento muy rápido del número de artículos por revista. En algunos casos, este crecimiento se apoya en un uso intensivo de números especiales, lo que puede facilitar procesos editoriales más rápidos y homogéneos, pero también suscita dudas sobre el rigor de la revisión por pares.

El análisis de los tiempos de aceptación muestra que algunas revistas publican artículos con gran rapidez y con escasa variación entre los plazos de revisión, lo que sugiere procesos altamente estandarizados. Aunque la rapidez no implica necesariamente baja calidad, los autores señalan que esta tendencia puede aumentar la presión sobre revisores y editores y reducir la capacidad de evaluación crítica en profundidad.

En relación con las tasas de rechazo, el estudio revela que no existe un patrón único: algunas editoriales mantienen niveles altos, mientras que otras los reducen o los estabilizan. Esto indica que el aumento de publicaciones no responde a una lógica uniforme, sino a decisiones editoriales específicas que influyen directamente en la carga global del sistema.

El artículo también aborda la inflación de las métricas de impacto, mostrando cómo el aumento generalizado de citas puede distorsionar la percepción de calidad científica. La dependencia excesiva de indicadores bibliométricos refuerza comportamientos estratégicos por parte de investigadores y revistas, orientados a maximizar visibilidad y rendimiento cuantitativo más que a fortalecer la solidez del conocimiento producido.

En sus conclusiones, los autores sostienen que la tensión en la publicación científica no es consecuencia de un único factor, sino del encaje problemático entre incentivos académicos, modelos de negocio editoriales y sistemas de evaluación de la investigación. Para aliviar esta presión, consideran necesario repensar las políticas de evaluación, mejorar la transparencia editorial y reducir la dependencia de métricas basadas exclusivamente en el volumen de publicaciones.