Fried, Ina. «Generative AI Has a Growing Privacy Problem». Axios, 14 de marzo de 2024. https://www.axios.com/2024/03/14/generative-ai-privacy-problem-chatgpt-openai.

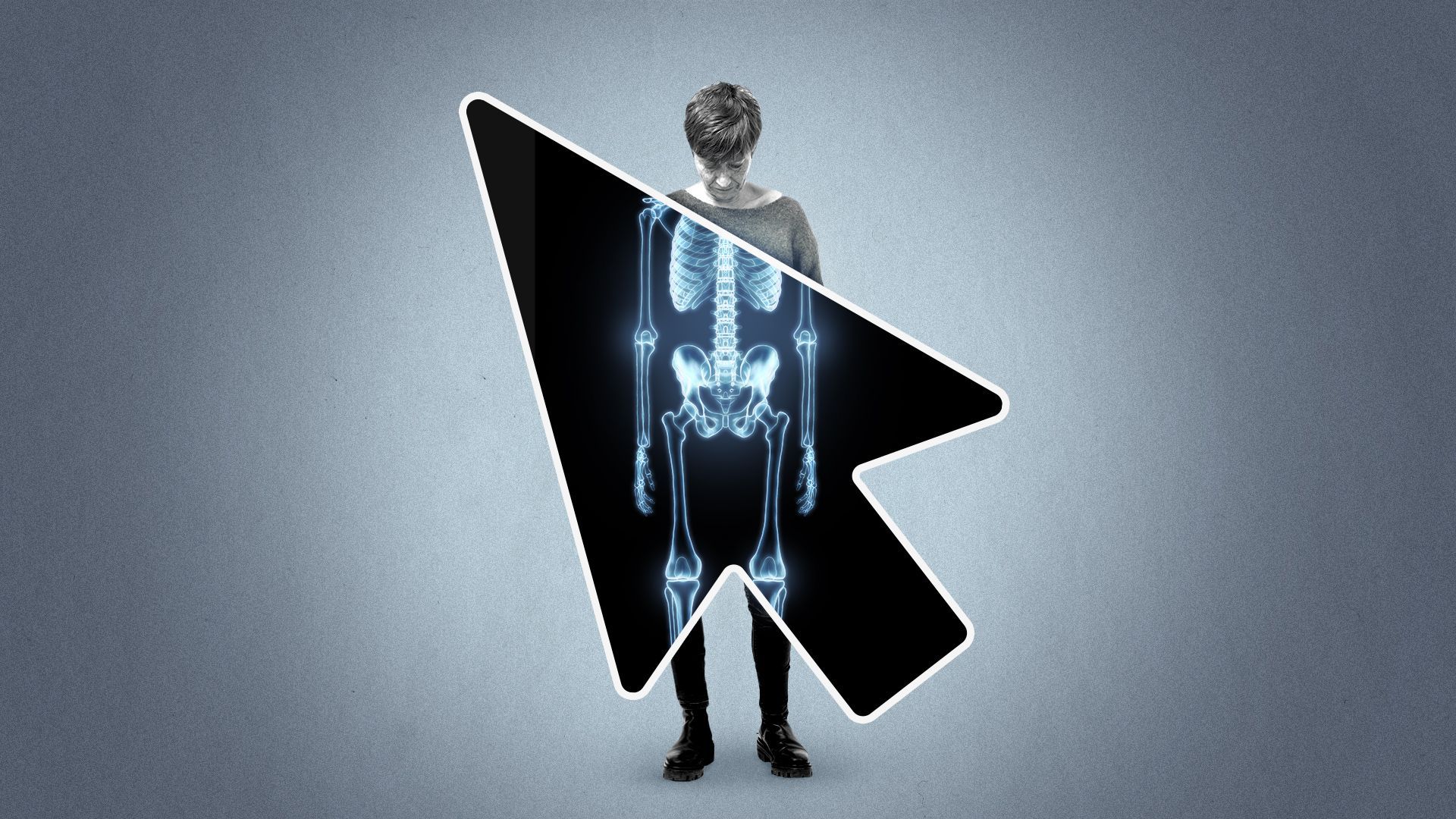

La privacidad se está convirtiendo en el próximo campo de batalla en el debate sobre la inteligencia artificial, incluso mientras continúan los conflictos sobre derechos de autor, precisión y sesgo.

Por qué es importante: Los críticos sostienen que los modelos de lenguaje grandes están recopilando y, frecuentemente, revelando información personal recopilada de toda la web, muchas veces sin el permiso de las personas involucradas.

El panorama general: Muchas empresas han empezado a desconfiar del uso de información patentada por parte de ejecutivos y empleados para consultar a ChatGPT y otros bots de inteligencia artificial, ya sea prohibiendo tales aplicaciones o optando por versiones pagas que mantienen la información comercial privada.

A medida que más personas utilizan la IA para buscar consejos sobre relaciones, información médica o asesoramiento psicológico, los expertos dicen que los riesgos para los individuos están aumentando. Las filtraciones de datos personales desde la IA pueden tomar varias formas, desde la divulgación accidental de información hasta la obtención de datos mediante esfuerzos deliberados para superar las protecciones.

La noticia destacada: Se han presentado varias demandas buscando el estatus de acción de clase en los últimos meses, alegando que Google, OpenAI y otros han violado las leyes federales y estatales de privacidad en la capacitación y operación de sus servicios de IA.

La FTC emitió una advertencia en enero de que las empresas tecnológicas tienen la obligación de cumplir con sus compromisos de privacidad mientras desarrollan modelos de IA generativa. «Con la IA, hay una gran fiebre por los datos, y estas empresas están recopilando cualquier dato personal que puedan encontrar en Internet,» dijo a Axios el profesor de derecho de la Universidad George Washington, Daniel J. Solove.

Los riesgos van mucho más allá de la simple divulgación de piezas discretas de información privada, argumenta Timothy K. Giordano, socio de Clarkson Law Firm, que ha presentado varios juicios por privacidad y derechos de autor contra empresas de IA generativa.

Entre líneas: Si bien la IA está creando nuevos escenarios, Solove señala que muchos de estos problemas de privacidad no son nuevos.

«Muchos de los problemas de IA son exacerbaciones de problemas existentes que la ley no ha tratado bien,» dijo Solove a Axios, señalando la falta de protecciones federales de privacidad en línea y los defectos en las leyes estatales que sí existen. «Si tuviera que calificarlas, serían como D y F», dijo Solove. «Son muy débiles.» El panorama general: Las capacidades únicas de la IA generativa plantean preocupaciones más grandes que la simple agregación común de información personal vendida y distribuida por corredores de datos.

Además de compartir datos específicos, las herramientas de IA generativa pueden establecer conexiones o inferencias (precisas o no), dijo Giordano a Axios.

Esto significa que las empresas tecnológicas ahora tienen, en palabras de Giordano, «un entendimiento escalofriantemente detallado de nuestra personalidad, suficiente para crear finalmente clones digitales y deepfakes que no solo se parecerían a nosotros, sino que también podrían actuar y comunicarse como nosotros».

Crear IA que respete la privacidad de los datos es complicado por cómo funcionan los sistemas de IA generativa.

Por lo general, se entrenan con conjuntos enormes de datos que dejan una especie de huella de probabilidad en el modelo, pero no guardan o almacenan los datos después. Eso significa que no se puede simplemente eliminar la información que se ha tejido. «No se puede desentrenar a la IA generativa,» dijo Grant Fergusson, un compañero del Electronic Privacy Information Center. «Una vez que el sistema ha sido entrenado en algo, no hay forma de revertirlo.»

Realidad: Muchos editores en línea y empresas de IA han agregado lenguaje que indica que los datos de los clientes pueden ser utilizados para entrenar modelos futuros.

En algunos casos, las personas tienen la opción de elegir no permitir que sus datos se utilicen para el entrenamiento de IA, aunque estas políticas varían y la configuración para compartir datos puede ser confusa y difícil de encontrar. Además, incluso cuando los usuarios ofrecen consentimiento, podrían estar compartiendo datos que podrían afectar la privacidad en línea de otros.

El otro lado: Un representante de OpenAI dijo a Axios que la empresa no busca datos personales para entrenar sus modelos y toma medidas para evitar que sus modelos revelen información privada o sensible. «Queremos que nuestros modelos aprendan sobre el mundo, no sobre individuos privados», dijo un portavoz de OpenAI a Axios. «También entrenamos a nuestros modelos para que se nieguen a proporcionar información privada o sensible sobre las personas». La empresa dijo que su política de privacidad describe opciones para que las personas eliminen cierta información y opten por no participar en el entrenamiento de modelos.

¿Qué sigue?: Los reguladores intentarán hacer cumplir las leyes de privacidad existentes en el nuevo ámbito de la IA, los legisladores propondrán nuevos proyectos de ley y los tribunales lidiarán con dilemas novedosos. Las empresas de IA podrían hacer más por sí mismas, pero Solove dijo que esperar que las empresas protejan la privacidad sin que se lo exija la ley probablemente sea poco realista. «Es como decirle a los tiburones: ‘Por favor, siéntense y usen cubiertos'», dijo Solove.