Caswell, Amanda. “I Tested 8 AI Chatbots for Our First Ever AI Madness — and This Is the Surprise Winner.” Tom’s Guide, marzo‑abril 2025.

En marzo de 2025, el medio tecnológico Tom’s Guide organizó una competencia llamada “AI Madness”, una especie de torneo eliminatorio inspirado en los brackets deportivos, para evaluar y comparar ocho de los chatbots de inteligencia artificial más avanzados del momento.

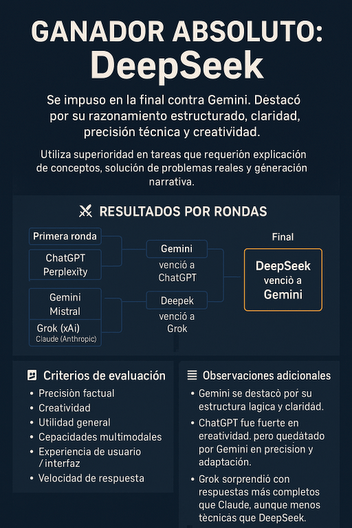

La periodista Amanda Caswell fue la encargada de probar cada modelo en múltiples rondas, utilizando una serie de prompts reales que abarcaban seis criterios clave: precisión factual, creatividad, utilidad, capacidades multimodales, experiencia de usuario e interfaz, y velocidad de respuesta.

En la primera ronda, ChatGPT (de OpenAI) venció a Perplexity.ai gracias a su equilibrio entre creatividad, profundidad y claridad. Gemini, el chatbot de Google, superó a Mistral por ofrecer una lógica más ordenada y explicaciones más didácticas. Una de las mayores sorpresas fue que Grok, el modelo de xAI desarrollado por Elon Musk, derrotó a Claude (de Anthropic), al mostrar respuestas más completas y accesibles para usuarios generales. Finalmente, DeepSeek, una plataforma emergente de origen chino, logró imponerse a Meta AI destacando por su tono conversacional, precisión técnica y versatilidad temática.

En las semifinales, Gemini se enfrentó a ChatGPT en una ronda muy reñida. Aunque ambos ofrecieron un alto nivel de rendimiento, Gemini destacó por estructurar mejor las respuestas y adaptarse a distintos tipos de consultas, como explicaciones académicas, planificación de menús y diseños de bases de datos. DeepSeek, por su parte, logró derrotar a Grok al demostrar una mayor profundidad analítica y un estilo más claro, manteniendo a la vez un enfoque conversacional eficaz.

La final del torneo fue entre Gemini y DeepSeek. Aunque Gemini mantuvo un nivel alto de desempeño, DeepSeek logró brillar en la mayoría de las tareas propuestas, entre ellas la resolución de problemas reales, la explicación de conceptos para diferentes edades, y la creatividad narrativa. El modelo combinó razonamiento avanzado con un lenguaje claro y accesible, superando las expectativas del jurado. Como resultado, DeepSeek fue proclamado ganador absoluto del torneo AI Madness 2025.

Un factor diferencial que explica el rendimiento sobresaliente de DeepSeek fue su enfoque de entrenamiento. A diferencia de muchos modelos que dependen principalmente del aprendizaje supervisado, DeepSeek-R1 utiliza aprendizaje por refuerzo (reinforcement learning), lo que le permite mejorar su capacidad de razonamiento y reflexión con menos intervención humana. Esto le otorga mayor autonomía y eficiencia a la hora de generar respuestas coherentes y detalladas en tiempo real.