Índice de Transparencia de Modelos Fundamentales

«New Index Finds AI Models Are Murky, Not Transparent At All». 2023. Accedido 21 de diciembre de 2023. https://www.darkreading.com/cyber-risk/new-index-finds-ai-models-are-murky-not-transparent-at-all.

El Índice de Transparencia de Modelos Fundamentales de la Inteligencia Artificial es una evaluación que se realiza a los principales modelos de IA para medir la transparencia en su desarrollo y funcionamiento. Cuando se menciona que la gran mayoría de estos modelos son opacos, significa que existe una falta significativa de claridad y divulgación sobre cómo se entrenan, las fuentes de datos que utilizan, y cómo toman decisiones.

La nueva orden ejecutiva sobre inteligencia artificial (IA) firmada por el presidente de Estados Unidos, Joe Biden, detalla cómo la industria debe asegurarse de que la IA sea confiable y útil. La orden sigue a discusiones destacadas en julio y septiembre entre empresas de IA y la Casa Blanca, que resultaron en promesas sobre cómo las empresas de IA serán más transparentes acerca de las capacidades y limitaciones de la tecnología.

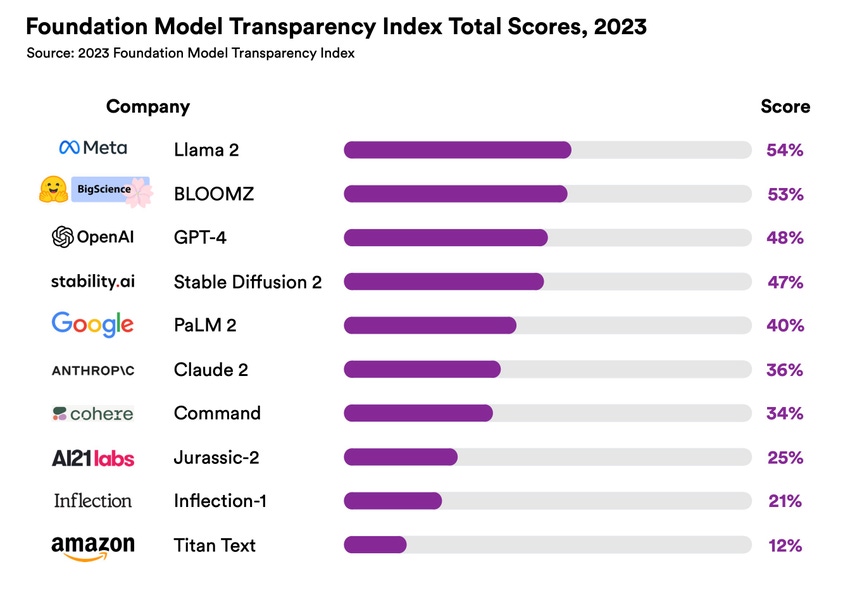

Hacer promesas de transparencia es un paso positivo, pero es necesario contar con un método para medir cuán bien se están cumpliendo esas promesas. Un método podría ser el Model Transparency Index desarrollado por el Centro de Investigación sobre Modelos Fundamentales de la Universidad de Stanford. El índice calificó 10 modelos de IA en función de 100 métricas diferentes, incluyendo cómo se entrenan los modelos, información sobre las propiedades y funciones del modelo, y cómo se distribuyen y utilizan los modelos. Las puntuaciones se calcularon en base a datos disponibles públicamente, aunque las empresas tuvieron la oportunidad de proporcionar información adicional para cambiar la puntuación.

¿Cómo se ve la transparencia al hablar de algunos de los modelos fundamentales más utilizados? No es buena. «Ningún desarrollador importante de modelos fundamentales se acerca a proporcionar transparencia adecuada, revelando una falta fundamental de transparencia en la industria de la IA», escribieron los investigadores de Stanford en el resumen de sus hallazgos.

Llama 2 de Meta recibió la puntuación total más alta en el índice, con 54 sobre 100.

El GPT-4 de OpenAI obtuvo 48, lo cual no es sorprendente, ya que OpenAI decidió retener detalles «sobre la arquitectura (incluido el tamaño del modelo), hardware, ordenador de entrenamiento, construcción del conjunto de datos [y] método de entrenamiento» al pasar de GPT-3 a GPT-4 a principios de este año.

En su mayor parte, los sistemas de IA potentes, como el GPT-4 de OpenAI y el PaLM2 de Google, son sistemas de caja negra. Estos modelos se entrenan con grandes volúmenes de datos y se pueden adaptar para su uso en una amplia variedad de aplicaciones. Pero para un creciente grupo de personas preocupadas por cómo se utiliza la IA y cómo podría afectar a las personas, el hecho de que haya poca información disponible sobre cómo se entrenan y utilizan estos modelos es un problema.

Según los investigadores, hay un poco más de transparencia en torno a la protección de datos de usuario y la funcionalidad básica del modelo. Los modelos de IA obtuvieron buenos resultados en indicadores relacionados con la protección de datos de usuario (67%), detalles básicos sobre cómo se desarrollan sus modelos fundamentales (63%), las capacidades de sus modelos (62%) y sus limitaciones (60%).

La nueva orden ejecutiva describe varias cosas que deben suceder para mejorar la transparencia. Los desarrolladores de IA deberán compartir los resultados de las pruebas de seguridad y otra información con el gobierno. El Instituto Nacional de Estándares y Tecnología tiene la tarea de crear estándares para garantizar que las herramientas de IA sean seguras y seguras antes de su lanzamiento público.

Las empresas que desarrollen modelos que representen riesgos serios para la salud y seguridad públicas, la economía o la seguridad nacional deberán notificar al gobierno federal cuando estén entrenando el modelo y compartir los resultados de las pruebas de seguridad antes de hacer públicos los modelos.

Pingback: Algunas cosas a considerar al decidir si comenzar a construir con «IA» en bibliotecas y archivos. | Universo Abierto