Koo, Ryan, Minhwa Lee, Vipul Raheja, Jong Inn Park, Zae Myung Kim, y Dongyeop Kang. 2023. «Benchmarking Cognitive Biases in Large Language Models as Evaluators». arXiv. https://doi.org/10.48550/arXiv.2309.17012.

En respuesta a la creciente preocupación sobre los posibles sesgos en los LLMs y su impacto en aplicaciones del mundo real, se llevó a cabo un estudio. El estudio se centró en analizar 15 LLMs diferentes utilizando el «Cognitive Bias Benchmark for LLMs as EvaluatoRs» (CoBBLEr). La motivación principal detrás de esta investigación fue identificar y mitigar sesgos que podrían llevar a preferencias injustas y disparidades en las evaluaciones de texto.

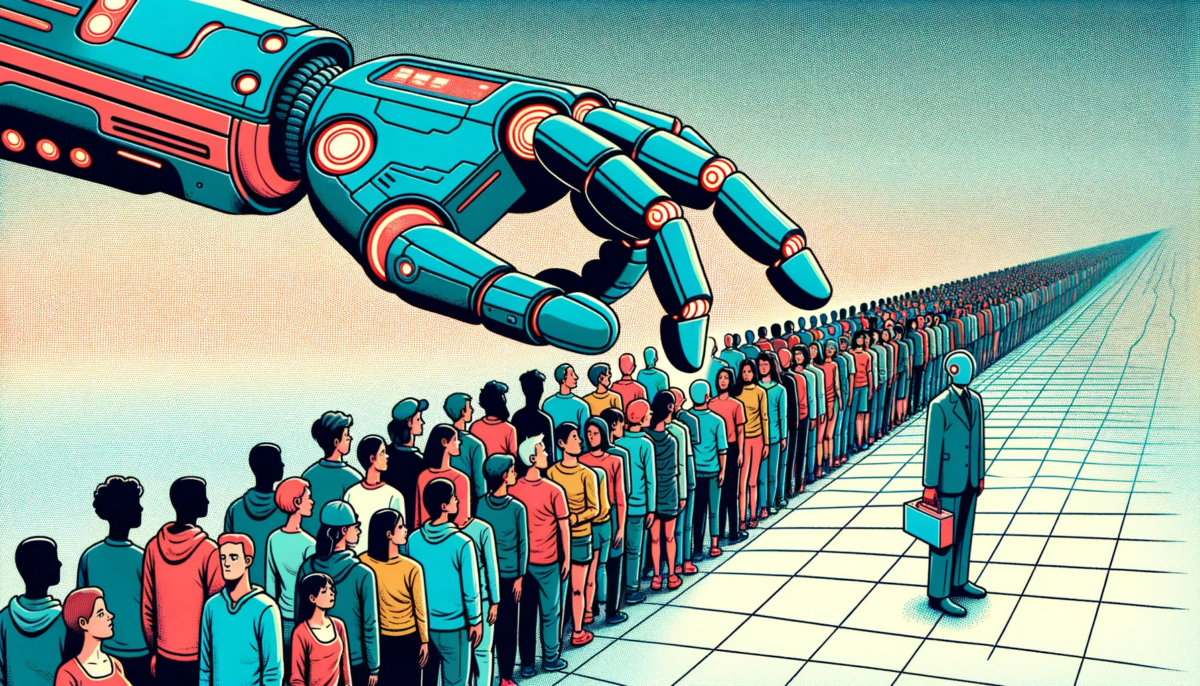

El estudio revela que los grandes modelos de lenguaje exhiben sesgos cognitivos y no se alinean con las preferencias humanas en la evaluación de textos. Entender estos sesgos es crucial, ya que los LLMs se utilizan cada vez más en aplicaciones del mundo real, desde recomendaciones de contenido hasta la evaluación de solicitudes de empleo. Cuando estos modelos son sesgados, pueden tomar decisiones o hacer predicciones que son injustas o inexactas.

Imaginemos un sistema de inteligencia artificial utilizado para evaluar solicitudes de empleo. El sistema utiliza un gran modelo de lenguaje para evaluar la calidad de la carta de presentación. Pero si ese modelo tiene un sesgo inherente, como favorecer textos más largos o ciertas palabras clave, podría favorecer injustamente a algunos solicitantes sobre otros, incluso si no son necesariamente más calificados.

Sesgos Cognitivos en LLMs: Investigadores de la Universidad de Minnesota y Grammarly realizaron un estudio para medir los sesgos cognitivos en los grandes modelos de lenguaje cuando se utilizan para evaluar automáticamente la calidad del texto.

El equipo de investigación seleccionó 15 LLMs de cuatro rangos de tamaño diferentes y analizó sus respuestas. Se les pidió a los modelos que evaluaran las respuestas de otros LLMs, por ejemplo, «System Star es mejor que System Square».

Para este propósito, los investigadores introdujeron el «COgnitive Bias Benchmark for LLMs as EvaluatoRs» (COBBLER), un referente para medir seis sesgos cognitivos diferentes en las evaluaciones de LLMs.

Resultados y Conclusiones: El estudio muestra que los LLMs presentan sesgos al juzgar la calidad del texto. Se identificaron sesgos clave, como la egocentricidad y la preferencia de orden, ambos con el potencial de influir en la evaluación del contenido de texto. Las implicaciones de estos sesgos son particularmente críticas en aplicaciones como la recomendación de contenido y la selección de solicitudes de empleo, donde los LLMs desempeñan un papel crucial en la toma de decisiones. Los investigadores también examinaron la correlación entre las preferencias humanas y las preferencias de la máquina, encontrando que estas no se alinean estrechamente (superposición de sesgos de rango: 49.6%).

Según el equipo de investigación, los resultados sugieren que los LLMs no deberían utilizarse para la anotación automática basada en preferencias humanas. Incluso los modelos ajustados a instrucciones o entrenados con retroalimentación humana mostraron diversos sesgos cognitivos al utilizarse como anotadores automáticos.

La baja correlación entre las calificaciones humanas y las calificaciones de la máquina sugiere que las preferencias de la máquina y las humanas generalmente no están muy cercanas. Esto plantea la pregunta de si los LLMs son capaces de proporcionar calificaciones justas en absoluto.

Con capacidades de evaluación que incluyen varios sesgos cognitivos y un bajo porcentaje de acuerdo con las preferencias humanas, los hallazgos sugieren que los LLMs aún no son adecuados como evaluadores automáticos justos y confiables.

Soluciones Propuestas:

- Algoritmos de Mitigación de Sesgos: Desarrollar e implementar algoritmos que puedan identificar y mitigar sesgos en los LLMs, asegurando evaluaciones justas y objetivas.

- Actualizaciones Regulares de Evaluación: Establecer un sistema de evaluación continua y actualizaciones para los LLMs, con el fin de abordar sesgos emergentes y mejorar su alineación con las preferencias humanas.

- Transparencia y Explicabilidad: Mejorar la transparencia y explicabilidad de los LLMs para proporcionar información sobre sus procesos de toma de decisiones, permitiendo una mejor comprensión y rendición de cuentas.

- Datos de Entrenamiento Diversificados: Asegurar que los LLMs se entrenen con conjuntos de datos diversos que representen con precisión la variedad de perspectivas y voces en la sociedad, reduciendo el riesgo de resultados sesgados.

Conclusión: Los hallazgos del estudio subrayan la necesidad de medidas proactivas para abordar los sesgos cognitivos en los LLMs. Al implementar las soluciones propuestas, podemos mejorar la confiabilidad y equidad de los LLMs, haciéndolos más adecuados para aplicaciones del mundo real donde el juicio imparcial es crucial. Esta investigación sirve como base para los esfuerzos continuos destinados a mejorar el uso ético y responsable de la inteligencia artificial en los procesos de toma de decisiones