Sample, Ian. “Quality of Scientific Papers Questioned as Academics ‘Overwhelmed’ by the Millions Published.” The Guardian, Jul 13, 2025. https://www.theguardian.com/science/2025/jul/13/quality-of-scientific-papers-questioned-as-academics-overwhelmed-by-the-millions-published

La calidad de los artículos científicos está siendo seriamente cuestionada, ya que los académicos se encuentran desbordados por los millones de estudios que se publican cada año, una saturación que amenaza la integridad y la fiabilidad del sistema científico a escala global.

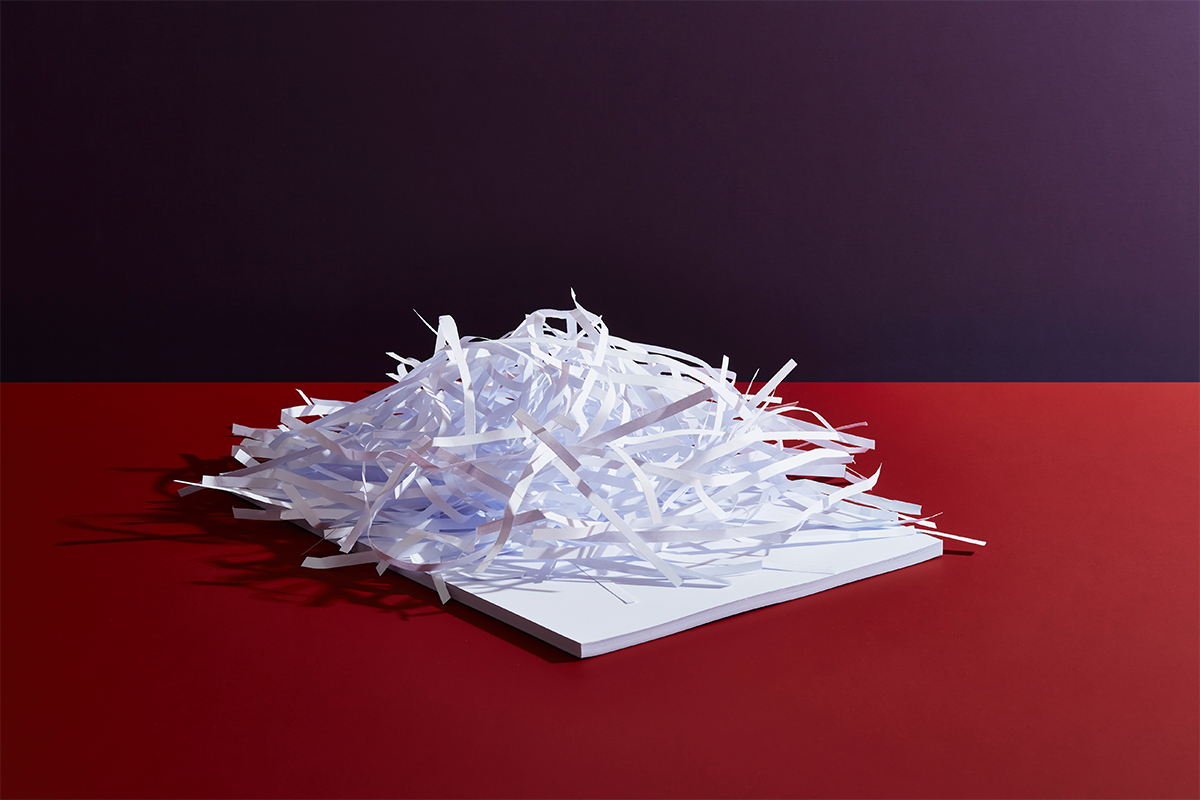

Un artículo en una revista científica que se hizo viral no por su ciencia, sino por una imagen generada por inteligencia artificial que mostraba una rata con un pene enorme y etiquetada con palabras sin sentido. Esa imagen pasó desapercibida por revisores y editores y llevó a que el artículo fuese retirado tres días después de su publicación, poniendo de manifiesto fallos en los procesos de revisión y control.

El texto recuerda que las revistas científicas no son simples repositorios académicos: condicionan decisiones médicas, políticas públicas, desarrollos tecnológicos y estrategias geopolíticas, incluso estimaciones de víctimas en conflictos armados. Desde el siglo XVII —cuando la Royal Society inició la publicación continuada de revistas científicas—, estos espacios han sido centrales para el avance del conocimiento, acogiendo trabajos de figuras como Newton, Darwin, Einstein o Marie Curie.

Sin embargo, los datos muestran que la cantidad de artículos científicos indexados ha crecido de forma exponencial: por ejemplo, en la base de datos Web of Science los estudios aumentaron de 1,71 millones en 2015 a 2,53 millones en 2024, y sumando otros tipos de artículos el total ronda más de 3 millones al año. Esta expansión ha superado con creces el crecimiento del número de investigadores y la capacidad de la comunidad científica para leer, revisar y valorar críticamente todos esos trabajos.

El sistema de evaluación por pares —el sistema en el que científicos expertos revisan artículos antes de su publicación— está cada vez más estresado. Revisar millones de artículos requiere tiempo, y muchos académicos están «agotados» por la carga de trabajo voluntario que supone revisar textos para otros investigadores. Este estrés contribuye a que errores, contenidos de baja calidad o incluso fraudes pasen desapercibidos, lo que debilita la confianza en los resultados publicados. Según un estudio reciente, solo en 2020, los académicos de todo el mundo dedicaron más de 100 millones de horas a la revisión por pares de artículos para revistas. En el caso de los expertos de Estados Unidos, el tiempo dedicado a la revisión ese año supuso más de 1500 millones de dólares en mano de obra gratuita.

Una causa fundamental es el conjunto de incentivos académicos y comerciales que priorizan cantidad sobre calidad:

- Los investigadores compiten por publicar más y más artículos para avanzar en su carrera (“publish or perish”), lo que puede llevar a trabajos fragmentados, poco sustanciales o exagerados.

- Las editoriales científicas comerciales obtienen grandes beneficios de los modelos de acceso abierto con tasas por publicación, lo que puede fomentar la proliferación de textículos académicos y revistas especializadas que aceptan prácticamente cualquier envío.

El artículo destaca que estas dinámicas han creado un sistema que incentiva la producción masiva de estudios aunque muchos aporten poco conocimiento nuevo o incluso errores, algo que preocupa a científicos de alto nivel, incluidos premios Nobel y sociedades científicas.

Varios expertos y organizaciones están pidiendo reformas profundas. Entre las propuestas que circulan en el debate público y académico están:

- Reformar el sistema de evaluación de investigadores para valorar calidad sobre cantidad.

- Repensar el rol y modelo de negocio de las editoriales, reduciendo la dependencia de tarifas por publicación y fomentando modelos de acceso y revisión más sostenibles.

- Incrementar el uso de herramientas y métodos que mejoren la calidad de la revisión por pares y detecten malas prácticas, incluidos fraudes y contenidos generados de forma automatizada.

La IA ha acelerado la producción de artículos y podido generar textos e imágenes científicas que no siempre son verificados adecuadamente. Esto alimenta temores de que herramientas como modelos de lenguaje puedan ser utilizadas para generar artículos de baja calidad o manipular revisiones si no se establecen mejores salvaguardas de integridad.