Smith, Noah. 2025. “I Love A.I. Why Doesn’t Everyone?” Noahpinion, 1 de diciembre de 2025. https://www.noahpinion.blog/p/i-love-ai-why-doesnt-everyone

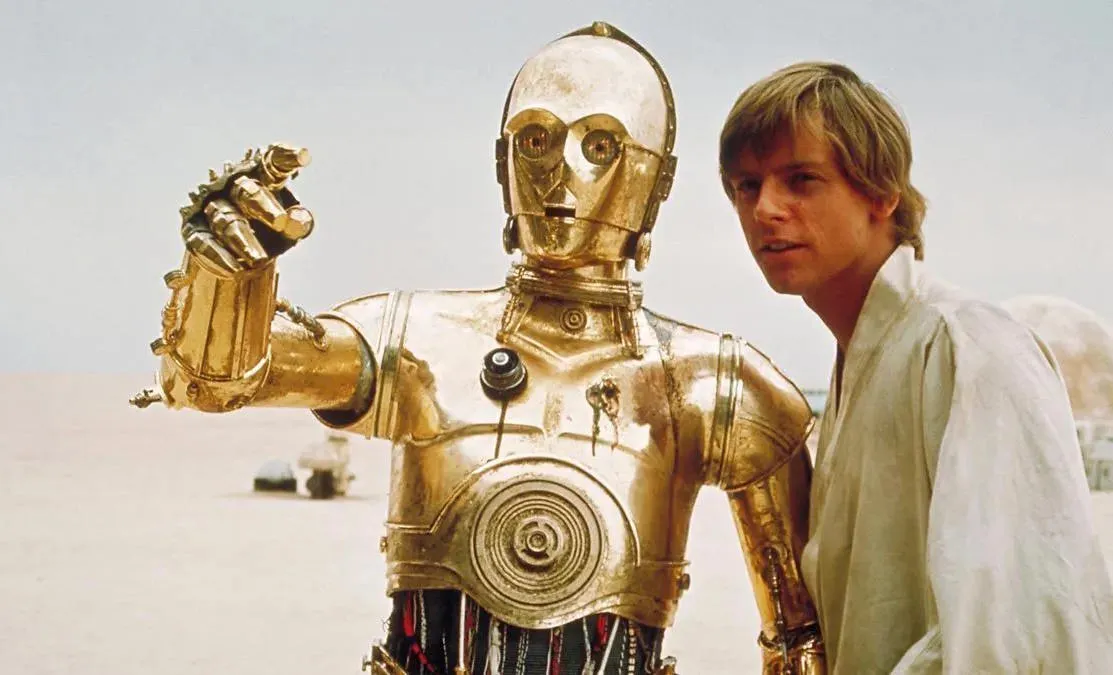

En su artículo, el autor describe su entusiasmo por la inteligencia artificial (IA) generativa, defendiendo que muchas de las críticas populares —a menudo emotivas o basadas en miedos— están fundamentadas en argumentos débiles o erróneos. Señala que aunque las tecnologías nuevas siempre traen riesgos y problemas (como la contaminación en la era industrial o el impacto social de la automatización), históricamente las sociedades han sabido adaptarse: lo mismo podría ocurrir con la IA.

Para el autor, usar IA hoy se parece a tener “un pequeño amigo robot”: un asistente que puede responder preguntas, ayudar a redactar textos, traducir, buscar información, resolver dudas cotidianas o tareas técnicas, o servir como herramienta de estudio, creatividad o investigación. Esa capacidad de poner al alcance de cualquiera —y con facilidad— prácticamente todo el conocimiento humano convierte a la IA en una de las tecnologías de propósito general más potentes jamás creadas.

Sí, admite que la IA comete errores: mezcla datos, inventa referencias, da respuestas equivocadas. Pero argumenta que esa falibilidad no la distingue fundamentalmente de cualquier herramienta de información: los humanos leen artículos, webs o libros que también a veces están equivocados o sesgados. Por eso —dice— lo importante es usar la IA con criterio, contrastar su output y no esperar que sea un oráculo infalible.

El artículo advierte también frente a ciertos debates críticos sobre la IA cuyos fundamentos considera exagerados, como los que destacan su consumo de agua o predicen impactos catastróficos inmediatos. En su opinión, esos temores a menudo sirven como “chivos expiatorios” influidos por la desconfianza general hacia lo nuevo, más que por evidencia concreta.

Finalmente, reflexiona sobre por qué muchas personas no comparten su entusiasmo. Entre las razones menciona inseguridades legítimas (riesgo de reemplazo laboral, cambios económicos, externalidades ambientales), pero también destaca un sesgo cultural: ante cada nueva tecnología disruptiva —como el automóvil, la electricidad o el internet— muchos reaccionan con miedo, cuando con el tiempo dichas tecnologías se normalizan y transforman la vida cotidiana. Cree que la IA puede seguir ese camino si aprendemos a gestionarla con responsabilidad